David Gunning, expert de la DARPA, a récemment promu une note sur l'eXplainable Artificiel Intelligence.

Le "deep learning" ou "apprentissage profond par machine" est un des domaines central d'application de l''Intelligence Artificielle. Les progrès en la matière ont permis de développer des systèmes autonomes qui collectent, analysent, regroupent et synthétisent des informations (perception), élaborent et stabilise des règles de représentation et de décision (apprentissage), et proposent ou prennent eux-mêmes des décisions (action). malheureusement, ces systèmes se heurtent au mu de la "confiance numérique" et mobilisant chez les humains des sentiments de méfiance, voire de défiance, conduisant dans les cas extrêmes de paranoïa à des déclarations intempestives de grands industriels du numérique sur la menace de l'IA sur l'avenir de l'humanité.

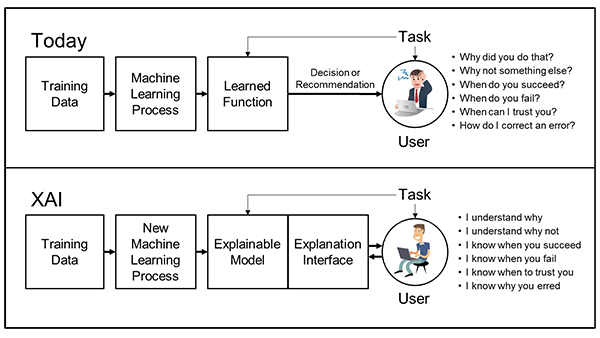

En fait, il est fort probable que cette "défiance numérique" soit relative à une forme d'incapacité des machines et systèmes à expliquer leurs processus, analyses et décisions ainsi que leurs propositions ou actions aux hommes avec lesquels ces machines sont sensées collaborer.

Les grands domaines régaliens de l'Etat, les services publics ainsi que de nombreuses entreprises privées sont aujourd'hui confrontés de plus en plus à de tels systèmes collaboratifs (HAT pour Human Artificial Teaming, ou MMS pour Man Machine Symbiosis). Ils sont de plus en plus nombreux, et de plus en plus performants, tout en échappant de plus en plus à la compréhension rationnelle. Il devient donc urgent de traiter d'un nouveau domaine de l'IA qui est connu chez les anglo-saxons court l'acronyme de "XAI" pour "Explainable Artificial Intelligence".

La XAI sera essentielle lorsque les futurs opérateurs de dispositifs amplifiés vont être amenés à à comprendre et gérer efficacement une nouvelle génération de smart machines.

Pour cela, le programme XAI doit s'attacher à des modèles plus explicables et compréhensibles, tout en maintenant un niveau élevé de performance, tant en précision qu'en rapidité et ciblage de l'efficacité, notamment prédictive (gaming), pour permettre l'établissement d'une confiance dans les artéfacts et leurs actions.

Les modèles explicables doivent s'inspirer et éventuellement être combinés aux techniques d'IHM, en valorisant les dimensions UX User eXperience) et KX (Knowledge eXchange). Cette préoccupation doit évidemment être prise en compte dès la conception des systèmes, alors qu'aujourd'hui, ce sont des patch explicatifs ou de convivialité qui sont surajoutés aux dispositifs existants.

Aucun commentaire:

Enregistrer un commentaire