Souhaitée par le Président du Conseil Régional d'Aquitaine et annoncée lors de sa dernière campagne électorale pour la Région Aquitaine-Limousin-Poitou-Charentes, l'Université du futur en Aquitaine doit permettre de doter la région d'un dispositif de recherche, formation et transfert, sensibilisation citoyenne et ouverture au monde concernant les révolutions numériques. Il s'agit d'une urgence stratégique absolue.

Nous passons à une vitesse inconcevable d’un ancien monde, semblant immuable et régi par les régularités, à un nouveau monde de plus en plus numérique, et auquel la plupart des citoyens ne comprend plus rien, dans un écart entre méfiance absolue et abandon dans une confiance totale aux politiques, économistes et scientifiques. Donner une vision panoramique du nouveau monde, en débattre, créer des vocations et permettre à chacun de mieux anticiper l’avenir, en mobilisant les forces vives pour l'avenir digital seront les principales missions de « l’Université du Futur en Aquitaine ». Cette structure à inventer devra notamment contribuer à transformer les menaces des technologies de rupture en opportunités de développement scientifiques et économiques, et donc en création de richesse et d’emplois.

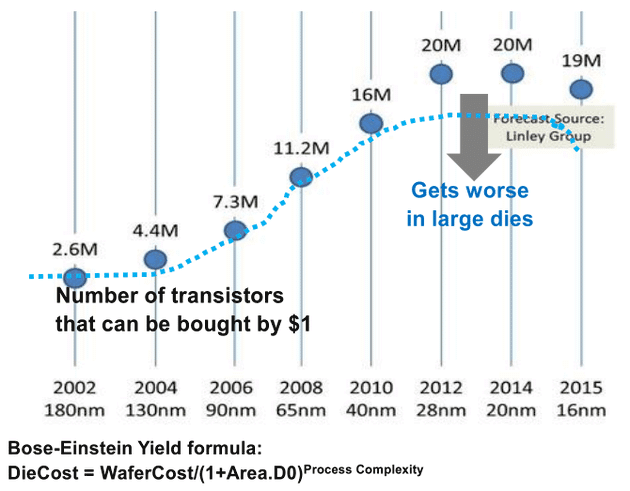

L'urgence : face à un tsunami technologique qui submerge le monde, la première vague numérique a été surfée par les GAFA (Google, Amazon, Facebook, Apple) américains, une seconde voit le réveil de la Corée du Sud, l'avance du Japon et d'autres grands majors de l'IA, des biotechnologies et de l'hybridité. L’Europe est en retard. Elle doit se mobiliser pour aborder les vagues suivantes. l'une d'elles est celle des NBIC (Nanotechs, Biotechs, Infotechs, Cognotechs). Il y va de son avenir, de son indépendance, ou… de son déclin.

Le défi est immense. Orienter le destin de tous, jeunes et moins jeunes, mais aussi générations futures, à long terme, revient au politique. Pour l'heure, son monde reste sourd aux alertes et aux souhaits d'un monde scientifique en alerte, qui voit l'avenir s'inventer sur les bords américains du Pacifique, en Asie du sud-est ou dans quelques pays dont on ne sait parfois pas trop grand-chose. À l’instar des initiatives des géants du numérique, des instances de la défense américaine, des firmes chinoises, japonaises et coréennes, les spécialistes des NBIC colonisent le cybermonde. On connaît les 1400 milliards d’euros de valorisation des GAFA, mais on ignore aussi les avancés plus discretes de la robotique et de la cobotique, celles de l'intelligence artificielle, de la génétique ou des nanotechnologies dans la transformation du monde, la transformation de l'homme, la transformation de la biosphère, et bientôt celle de l'espace.

Face à un tel déferlement, et malgré l'ignorance des élites politiques et le quasi-analphabétisme technologique des citoyens, il convient d'urgence de donner à chacun les moyens de ses choix, aux scientifiques ceux de la recherche et aux entreprises ceux de la compétitivité pour aborder l'avenir en position dominante, ou pour le moins non dominée. Face à l'actuelle mainmise du marché du numérique par les géants américains, à la captation de valeur et au déclin de l'économie européenne, il faut réinventer un moyen d'aborder les nouvelles frontières en valorisant les meilleurs cerveaux, notamment en les gardant, sans qu'ils ne fuient vers les côtes californiennes ou de l'est américain. ce sera dans l'échange, et le rééquilibrage que l'avenir peut se construire, pour retrouver une Europe qui a créé l’aéronautique, l’électricité, la chimie, l’auto, le téléphone et le cinéma, et qui abandonne le numérique et son implication sur le vivant, y compris sur le statut génétique même de l'homme, à l'étranger, sans contre-pouvoir, sans compétition, sans alternative autre que le clientélisme ou la soumission.

Dans le cadre d'une rupture de la distanciation, l’ “Université du Futur en Aquitaine” pourra former, informer et susciter ces débats philosophiques et technologiques, organiser la réponse scientifique et économique, promouvoir l'entreprise, les écoles d'ingénieurs et les laboratoires. Faire tomber les frontières, alors que de vieilles barbes discutent encore des différences entre SHS et TIC, des limites jusqu’ici établies entre vivant et non biologique s'estompent. La naissance de l’intelligence “non biologique”, pas seulement celle qui bât les joueurs de Go ou pose des diagnostics médicaux, trouve aujourd'hui des ouvertures dans l'hybridité, dans la biologie de synthèse, dans l'intrication homme-système, dans l'autonomie d'êtres virtuels et pourtant dont les actes et conséquences d'actes sont bien réels.

Derrière les NBIC, il y a des mutations économiques qui se profilent, avec Google et Apple constructeurs de voitures, fournisseurs de santé, et bientôt peut-être d'implémentation de la pensée.

J'ai vécu les époques où l'on niait la possibilité de la suprématie artificielle sur les jeux d'intelligence alors que le dernier vient de tomber, celle de l'impossibilité du décodage du génome aujourd'hui possible à quelques dollars, de l'hybridité artificielle dans la reproduction de la vie, frontière elle aussi tombée l'an passé, la possibilité des robots amoureux, des voitures autonomes, du terrorisme numérique, etc. La poursuite de l'autisme politique et scientifique n'est plus tenable. Le choc idéologique à négocier d'urgence sera moins douloureux que celui de l'asservissement des peuples ou même de leur disparition au profit des seuls technologues américains, asiatiques, ou pire, religieux.

Face à cette bombe sociale, économique, de civilisation, les positions acquises disparaissent, comme Kodak au profit des téléphones. Ceux qui n’ont pas saisi les opportunités de la compétition universelle du futur numérique sont probablement, sans le savoir, déjà d'un autre siècle.

L'Université du Futur, c'est une chance de recoller à l'avenir, de développer les orientations stratégiques et mélangées, scientifiques, culturelles, technologiques, économiques, pour s'inscrire dans le futur en marche. En s'appuyant sur les forces vives de la région, les clusters, les pôles de compétitivité, les lycées, les écoles d'ingénieurs, les universités, sur les étudiants et scientifiques, sur les entreprises et les laboratoires, sur les systèmes de santé, industriel et de défense, sur les associations culturelles et sociétés savantes ... toutes les volontés et les intérêts sont à mobiliser. L'Université du Futur en Aquitaine est l'opportunité de donner à la région la dimension de leader dans la compétition européenne pour son avenir, son indépendance et le pleine réalisation des ses citoyens pour une vie qui, que l'on le veuille ou non, sera numérique.