Cognitique / Cognitics - Ce site est destiné aux élèves ingénieurs et aux doctorants de l'École Nationale Supérieure de Cognitique (ENSC Bordeaux-INP). Il donne en complément des enseignements des pistes de documentation et de débat selon les thèmes SHS, IA, BIO, TECH, culture, infos générales et vie de l'ENSC. Il prépare notamment aux épreuves du grand oral de fin d’études.

31 décembre 2018

DIV : bonne année 2019.

Libellés :

ENSC

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

20 décembre 2018

IA : Pour une histoire naturelle de l’intelligence artificielle.

L’actualité et les succès informatiques de l’Intelligence Artificielle ainsi que les performances toujours plus spectaculaires des machines numériques, calculateurs et robots, amènent certains spécialistes de l’IA à la présenter et la faire considérer par le grand public comme un domaine spécifique, à part de ceux de la cognition ou de ses productions artefactielles. Ce statut singulier, qui mobilise les milieux socio-économiques comme les artistes et certains penseurs transhumanistes, ne peut pourtant pas être conçu sans référence à l’homme, à sa pensée et à sa puissance d’instrumentation, mais aussi et plus largement à sa place dans le monde du vivant.

Bernard Claverie propose ici un article, dans le numéro spécial « Le devenir-cyborg du monde » de la revue « Figures de l’art » (numero 35), coordonné par Bernard Lafargue et Bernard Andrieux, montrant comment la métaphore d’une IA toute puissante peut être ramenée au problème global de la valeur biologique des intelligences, et combien l’IA gagnerait à s’inscrire dans une vision intégrée, saine et évolutive de l’intelligence naturelle.

Lien de téléchargement de l’article (ici).

Libellés :

bio,

cerveau,

comportement,

ia,

publication,

ressource pédagogique,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

IA : Pourquoi les machines ne pensent pas.

Le projet des pionniers de l'intelligence artificielle (IA) était de vouloir « modéliser la pensée » pour pouvoir la connaître et la comprendre. Le principe était celui énoncé par Jean-Baptiste Vico selon lequel on ne connaît que ce que l'on crée, et donc que seul le créateur dispose de la connaissance de la création. C'était certainement oublier qu'il est alors facile de se prendre pour Dieu, ce que certains spécialistes de l'IA n'ont pas omis de faire. Et c'est ainsi que l'ambition a été de créer des machines intelligentes et de s'affranchir de la mission de connaissance pour aborder celle de faire. Mais que peut faire une machine intelligente, sinon de l'intelligence, et par là laisser croire qu'elle pense.

Si certains ne considèrent pas Philippe Dreyfus, mort l’été dernier à Biarritz dans l’indifférence générale, comme le père de l’informatique, c’est qu’ils ont oublié qu’il est le père du mot « informatique ». Avant lui, il y avait du calcul automatique, voire électronique, mais l’association des mots information et automatique fut en 1962 l’évènement qui nomma la discipline récente. Un peu, peut-être, comme si un créateur passant par là avait nommé Homme un singe que l’évolution darwinienne avait fait émergé comme pure « création » semantique.

Dix ans plus tard, un autre Dreyfus, Hubert, a montré en 1972 dans What Machine Can't Do que les machines ne font qu'exécuter des règles abstraites, alors que la pensée humaine est fondée sur l'émergence de contenus mentaux, motivés par les ambitions, des espoirs, des projets, et tant de choses que les phénoménologiques regroupent sous le terme d'intentions. Cette notion d’émergence cognitive est l’une des bases de la pensée de Francisco Varela.

Turing avait déjà jeté un pavé dans la mare avec l'application du jeu de l'imitation aux machines. Ce jeu consistant pour une personne ne communiquant avec les membres d'un couple par des petits bouts de papier écrits, à deviner qui était l'homme et qui était la femme, en sachant que l'un et l'autre pouvaient imiter son partenaire. Il en fit une théorisation pour une machine versus un humain, et inventa le test de Turing. Celui-ci n'est rien d'autre que le moyen de la reconnaissance de l'intelligence à partir de la capacité d'analogie des productions de la machine avec celle de l'humain. Le problème de l’analogie est qu’il s’agit d’une assomption. On ne fait que considérer la similitude de comportement : "c’est comme si ça faisait pareil, mais on sait que ça ne fait pas pareil ... par contre les autres peuvent penser que c'est pareil". Ici, il faut rappeler deux dimensions spécifiques de l'analogie : ma croyance personnelle ou la croyance des autres. Si je fais "vroum vroum", je peux croire que j'ai une grosse voiture, et jouer à faire comme si j'avais une grosse voiture. Si j'ai une voiture qui fait "vroum vroum", les autres peuvent penser que c'est une grosse voiture, alors que je peux très bien savoir que c'est le résultat d'un tuning réussi sur une vieille cacugne.

Appliquée à l’informatique, on peut caractériser deux catégories d'informaticiens qui déterminent deux formes d'IA. On peut imaginer une IA forte qui ambitionne de créer une vraie intelligence réalisée par des machines, et une IA faible circonscrite à des tâches spécifiques réalisant des briques d'intelligence plus ou moins efficace, mais satisfaisante pour les tâches considérées, analogues à l’intelligence humaine circonscrite à la tâche considérée. On rencontre alors ceux qui rêvent de remplacer le créateur, ou l’évolution, ou la nature, quel que soit le nom qu’on donne à ce qui motiverait ce qui est, et ceux qui tentent de résoudre des problèmes concrets, précis et circonscrits, avec le plus d'efficacité et de sérieux possibles, dans un jeu d’imitation partielle.

Or, si la discussion sur la globalité de l’intelligence ou l’existence d’une collection d’intelligences reste entière, celle de la pensée ne fait pas de doute. Une pensée ne peut qu’être globale, et toute tentative d’une décision d’une pensée partielle est une négation du concept même de la pensée. Donc, dans l’attente d’une éventuelle IA forte, les machines ne pensent pas.

Libellés :

culture,

épistémologie,

ia,

NBIC,

numérique,

polémique,

Sciences cognitives,

shs

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

12 décembre 2018

SHS - TECH : Colloque FRACTURES à l'ENSC - 12-13 XII 2018

Colloque

Ecole Nationale Supérieure de Cognitique

109 avenue Roul - 33405 Talence

(Tram B - Station Béthanie)

La question des inégalités numériques est une question de société majeure à l’heure où les environnements, activités, relations sont profondément marqués par une hyper présence des outils et services numériques. Le programme initié grâce à la Maison des Sciences de l'Homme d'Aquitaine (MSHA) aborder cette problématique à partir des questions de l’accessibilité numérique et par rapport au public des personnes en situation de handicap (porteuses d'une déficience physique, sensorielle, cognitive…), des personnes âgées et d’une façon plus générale, de toutes personnes mises en situation de handicap.

Deux axes forts sont abordés pendant le colloque organisé à l'ENSC :

Accessibilité, handicap et communication dans les écosystèmes numériques

Dispositifs, expérimentations, usages : des dynamiques aux innovations.

Accès au programme : (lien ici).

Libellés :

comportement,

conférence,

ENSC,

handicap,

innovation,

NTIC,

réunion scientifique,

santé,

shs,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

IA - SHS : Journée "Justice et Intelligence-Artificielle" - ENSC Bordeaux

Le mercredi 12 décembre est organisé

un cycle de conférences/débats sur la problématique

Seront débattues les questions du rôle, de l'intérêt, des limites, dangers et contraintes ainsi que des perspectives d'application de l'Intelligence Artificielle dans les domaines du Droit et de la Justice.

Les élèves ingénieurs de 3ème année de l'ENSC sont invités à ces débats ouverts qui accueillent également d'autres élèves, étudiants et jeunes ingénieurs diplômés.

à l'Ecole Nationale Supérieure de Cognitique

109 avenue Roul, Talence (33405)

(station Béthanie du TRAM B)

14 heures - Petit amphithéâtre

un cycle de conférences/débats sur la problématique

"Justice et Intelligence-Artificielle".

- Bernard Taillebot - 1er Vice Président TGI de Bordeaux

- Thierry Wickers - Avocat au Barreau de Bordeaux

- Marc Rodier - Titulaire de la Chaire IBM / ENSC Sciences et Technologies Cognitives

- Hervé Le Guyader - Chargé de mission prospective et relations extérieures de l'ENSC

Seront débattues les questions du rôle, de l'intérêt, des limites, dangers et contraintes ainsi que des perspectives d'application de l'Intelligence Artificielle dans les domaines du Droit et de la Justice.

Les élèves ingénieurs de 3ème année de l'ENSC sont invités à ces débats ouverts qui accueillent également d'autres élèves, étudiants et jeunes ingénieurs diplômés.

Libellés :

conférence,

culture,

ENSC,

ia,

numérique,

réunion scientifique,

shs

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

10 décembre 2018

BIO - Cinq millions de génomes à séquencer.

2012, le National Health Service britannique lance le plan "Genomic England" visant au séquençage de 100 000 génomes.

2018, les chercheurs annoncent avoir atteint leur objectif, soit les génomes de 85 000 patients du National Health Service souffrant d’une maladie rare ou personnes apparentée à une personne atteinte de telles maladies, et de 15 000 génomes de cellules prélevées directement sur des tumeurs.

2023, l'objectif du NHS est le séquençage de 5 million de génomes, soit 10 fois plus de personnes.

Le but de ce projet de séquençage est de pouvoir diagnostiquer les personnes susceptibles de développer un cancer ou une maladie héréditaire.

Pour rappel, le génome correspond à la séquence d’ADN unique de chaque individu, contenu dans les chromosomes du noyau de chaque (ou presque) cellule du corps. Aujourd’hui, le séquençage, c'est-à-dire l'identification de toutes les séries de lettres (les 3 millions de paires de nucléotides ou acides nucléiques composant l'ADN - A, T, C et G) constituant les gènes, peut être réalisé en moins de 48 heures pour quelques dollars (13 ans, de 1990 à 2003, pour 3 milliards de dollars du "Human Genome Project") à partir d'un simple prélèvement de tissus ou de fluide corporel (par exemple une simple prise de sang). Les performances des machines vont encore s'améliorer et il sera bientôt facile d'identifier ces inventaires génétiques complets de manière encore plus facile et moins chère.

Pays/territoire :

18-20 Massetts Rd, Horley RH6 7DE, Royaume-Uni

30 novembre 2018

DIV : Inauguration de la 3ème tranche des bâtiments de l'ENSC.

Le vendredi 30 novembre 2018 a été inaugurée au 109, avenue Roul, 33400 Talence, la nouvelle extension (« troisième tranche ») de l’Ecole Nationale Supérieure de Cognitique (ENSC), membre de Bordeaux INP et de la Conférence des Grandes Ecoles.

Cette extension va permettre aux chercheurs et formateurs de l’école de travailler, avec ses partenaires industriels (Thales, IBM, Dassault …), sur de nouveaux projets associant Intelligence Artificielle, Big Data, pensée et comportement humains, dans une perspective de symbiose homme-système, notamment appliquée aux questions de C2 (Command and Control) et d’aide à la prise de décision en situation complexe.

Le traditionnel ruban tricolore, tenu par deux étudiantes de l’école, a été coupé devant plus d'une centaine de personnes par le Président Alain Rousset, président du Conseil Régional de Nouvelle Aquitaine, principal financeur de l’opération aux côtés de Bordeaux INP, en présence du Général Jean Rondel, commandant les Forces aériennes (CFA) et chef de la zone de défense du sud-ouest, du Professeur Dominique Rebière, DRRT, représentant le Préfet de région Nouvelle Aquitaine, de Marc Phalippou, directeur général de Bordeaux INP, de Jean-Louis Blouin, président du Conseil de l’ENSC et de son directeur, le professeur Bernard Claverie.

|

| Sud-Ouest 8/12/18 |

On notait aussi la présence des représentants d’écoles d’ingénieurs partenaires de l’ENSC sur ces problématiques futuristes, dont l’ESTIA, l’ISAE, l'EnseirbMMK, l’Ecole de l’Air, l'Institut Mines-Télécom, et de nombreux industriels membres de l’écosystème de l’ENSC (Club des entreprises de l'ENSC, Thales, Dassault, EDF, Bertin, Cluster Aquitaine Robotics, Digital Aquitaine, etc.), des directeurs des laboratoires d'appui de l'école (Laboratoire bordelais de recherche en informatique - LaBRI, laboratoire Intégration Matériau-Système - IMS, Institut de mathématiques de Bordeaux - IMB, Inria Sud-Ouest), et de représentants de la communauté scientifique internationale rassemblée autour du panel "information systems technology" de l’Organisation pour la Science et la Technologie (STO-NATO). La cérémonie a eu lieu en présence des élèves ingénieurs, des professeurs et des représentant des services de la Région Nouvelle Aquitaine et de la municipalité de Talence.

--

24 octobre 2018

IA - BIO : Construtif - numéro spécial NBIC

« Constructif » est le « Laboratoire d'idées » de la Fédération du bâtiment, abordant les grandes questions posées à la société moderne. Constitué en « espace de débat, d'analyse et d'échange d'expériences », il souhaite éclairer les cadres et les décideurs du monde du bâtiment dans leur réflexion sur les grandes questions du champ économique et social.

Le numéro 42, paru en novembre 2015, aborde la question des « nouvelles limites du vivant » et propose une série d’articles sur les NBIC. On y retrouvera un article sur « l’homme réparé ou augmenté - le prix de l’anormalité » (lien).

Le numéro 42, paru en novembre 2015, aborde la question des « nouvelles limites du vivant » et propose une série d’articles sur les NBIC. On y retrouvera un article sur « l’homme réparé ou augmenté - le prix de l’anormalité » (lien).

Libellés :

culture,

NBIC,

publication

Pays/territoire :

9 Rue La Perouse, 75016 Paris, France

19 octobre 2018

DIV : un administrateur de l’ENSC à l’UIMM.

Nicolas Foucard (lien) directeur du site du Haillan de Ariane Group, représentait l’Union des Industries et Métiers de la Métallurgie, membre fondateur de l’école, alors Institut de Cognitique, au conseil d’école. Nicolas Foucard sera cette annee auprès du directeur de l’ENSC pour délivrer les diplômes des nouveaux ingénieurs de l’école, le 17 novembre 2018. En effet, les diplômes sont toujours délivrés en présence d’un représentant significatif du monde industriel. Cette année, la promotion Stephan Howking sera honorée de la présence de Nicolas.

Celui-là vient d’être élu président de l’UIMM Gironde-Landes lors de son assemblée générale du 19 octobre dernier, un mandat stratégique pour le développement socio-économique de la région, mais également pour l’avenir des diplômes de l’ENSC.

Bravo à Nicolas Foucard, L’école se réjouit et lui présente ici ses félicitations pour cette promotion.

Celui-là vient d’être élu président de l’UIMM Gironde-Landes lors de son assemblée générale du 19 octobre dernier, un mandat stratégique pour le développement socio-économique de la région, mais également pour l’avenir des diplômes de l’ENSC.

Bravo à Nicolas Foucard, L’école se réjouit et lui présente ici ses félicitations pour cette promotion.

Libellés :

ENSC,

entreprise,

info générale,

ingénieur

Pays/territoire :

35-40 Avenue Maryse Bastié, 33520 Bruges, France

18 octobre 2018

IA-SHS : Cybersécurité - le piégeage du Web par faille cognitive.

Le Typosquatting » est une technique toxique et très efficace de piégeage des utilisateurs du Web. Elle repose sur l’écriture d’un nom de domaine qui ressemble à un nom de domaine officiel ou privé connu par celui qui reçoit un message comportant un lien. Celui-là, en confiance, ouvre le lien ... ce que souhaite ke cyber pirate.

Cette nouvelle technique a fait l’objet de deux rapports (1) et (2) publiés en février 2018 par la société de sécurité informatique Menlo Security.

Le Principe du typosquatting repose sur le fait que notre cveraue est doté ed capciatés éotanntes moibilsant des procsesus proches ed la dysxelsie. Ces processus ont fait l’objet d’études scientifiques (lien) qui montrent que les mots sont spontanément lus par groupes de lettres.

Cette propriété est à la fois une performance et une faille. Ainsi, un pirate peut acheter des noms de domaine imitant des noms de site connus, ou envoyer un message mail avec le nom falsifié d’un correspondant habituel, la différence résidant dans un détail, par exemple une faute d’inversion de lettres (ENCS pour ENSC) ou d’utilisation d’un caractère non romain (@, &, €, etc.) ou non codifié de manière informatique classique (ç, ë, å, etc.). Loin d’être une erreur typographiques, la stratégie consiste en un leurre pour l’usager qui n’a ainsi pas conscience de s’être fait piéger.

Le typosquattage peut s’appuyer sur des noms qui mobilisent l’émotion de l’internaute, tels que « tresor-pubilc, mais aussi tresor-publics, tresar-public, tresor-public, etc. », ou « dircetion-ensc, direction-esnc, mais aussi direction-ėnsc, direčtion-ensc, directiøn-ensc, etc. ». Il peut consister en utilisation, élision ou inversion de lettres (unviresite-bordeaux, unversite-bordeaux, etc.), en suppression ou ajout d’un tiret, d’un slash ou autre (universitebordeaux, universite_bordeaux, ou universite/bordeaux, pour universite-bordeaux), en utilisation d’accentuation orthographiquement correcte (université-bordeaux), ou en modification du code terminal (.tr pour .fr, .cam pour .com, .arg pour .org, etc.). L’important est que l’erreur soit efficace et que la victime n’en prenne pas conscience, ou trop tard. Une technique très efficace repose d’ailleurs sur l’étude statistique des erreurs de frappe récurrentes de l’internaute à piéger pour lui proposer des erreurs congruentes avec son propre handicap, ses habitudes ou sa personnalité cognitive.

Dans tous les cas réussis, la victime, pensant correspondre avec une personne, une société, un organisme typosquatté, est alors invitée à donner des informations personnelles ou confidentielles dans un processus de phishing (hameçonnage).

Libellés :

cerveau,

comportement,

ergonomie,

handicap,

NTIC

Pays/territoire :

2300 Geng Rd #200, Palo Alto, CA 94303, États-Unis

15 septembre 2018

DIV : Une chaire IBM à l'ENSC

Annoncée lors du salon NovAQ 2018, qui s'est tenu du 13 au 15 septembre 2018 au Hangar 14 du Port de Bordeaux, lors de l'interview que Nicolas Sekaki et Bernard Claverie, respectivement président de IBM France et directeur de l'ENSC, ont donné à TV7, une chaire industrielle IBM a ouvert à Bordeaux, au sein de l'Ecole Nationale Supérieure de Cognitique (lien).

Ce partenariat entre IBM et l'ENSC valorise des objectifs communs aux deux partenaires :

- enraciner des initiatives pédagogiques sur l'IA pour former de manière certifiante aux enjeux et aux outils émergeant de l'ère cognitive ;

- définir et, le cas échéant, mettre conjointement en oeuvre des projets prospectifs en favorisant le transfert et l'application de connaissances ;

- développer l'insertion professionnelle des étudiants de l'ENSC chez IBM et la formation permanente des spécialistes de IBM à l'école ;

- contribuer à un rayonnement mutuel dans différents réseaux et écosystèmes, et au développement de l'idée d'une approche scientifique concrète des dimensions humaines de l'IA.

La chaire est dirigée par Marc Rodier, ingénieur diplômé de l'ENSEEIHT (EN7 - Toulouse INP) ; docteur (PhD) et "distinguished Engineer" et leader du groupe de recherche et développement "Cloud IBM Services for Managed Application" ainsi que membre de la "IBM Academy of Technology".

Marc Rodier, qui a pris ses fonction de directeur de la chaire en décembre 2018, est le leader de l'équipe "global architecture and development team in IBM", spécialiste de Watson et des solutions cognitives de IBM, Marc Rodier intervient et enseigne la stratégie CAMSS (Cloud, Analytics, Mobile, Social and Security) dans différentes écoles d'ingénieurs et de management.

Marc Rodier, qui a pris ses fonction de directeur de la chaire en décembre 2018, est le leader de l'équipe "global architecture and development team in IBM", spécialiste de Watson et des solutions cognitives de IBM, Marc Rodier intervient et enseigne la stratégie CAMSS (Cloud, Analytics, Mobile, Social and Security) dans différentes écoles d'ingénieurs et de management.

Libellés :

ENSC,

ia,

info générale,

numérique,

partenariats,

Sciences cognitives,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

16 juillet 2018

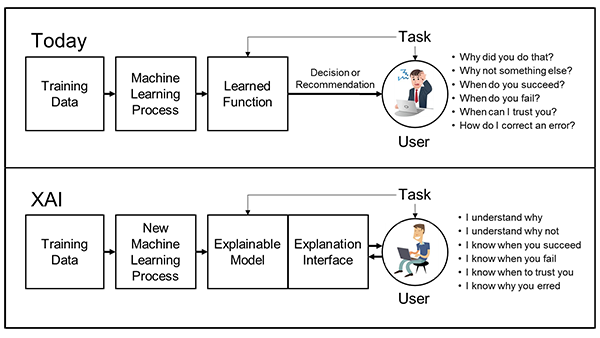

IA : Intelligence artificielle explicable

Les applications d'IA envahissent le quotidien des hommes, que ce soit dans le domaine professionnel, le domaine de la vie privée, et même au delà, dans celui de l'intimité personnelle.

Le premier problème reste celui de la communication avec les outils de l'intelligence artificielle (UX), avant celui de la communication avec l'IA elle-même (KX) qui réserve de solides problématiques à la fois techniques et épistémologiques.

La DARPA a mis en œuvre un programme de recherche "CwC & XAI" qui aborde d'une part les dimensions UX du partage direct entre les personnes et les smart machines, et d'autre part qui valorise le partage de représentations propres à chaque catégorie de partenaires pour un partage en toute sécurité, robustesse et confiance. Ce programme est dirigé par David Gunning, à la fois expert en informatique et en psychologie.

UX : Communiquer avec les ordinateurs, ou la Communication with Computers (CwC).

Le domaine CwC dépasse le simple domaine des IHM (interfaces homme-machine), voire des IHS (intégration homme-système) de génération actuelle. Son ambition est de permettre une communication "symétrique" entre des personnes, expertes ou non, et les machines, dont les ordinateurs. La CwC est une forme d'IHS v2.0, pour laquelle les machines ne sont pas de simples récepteurs d'instructions ou émetteurs de réponses ou comportements préprogrammés, mais de véritables collaborateurs capables de recourir et d'utiliser des modes spontanés de communication. On pense évidemment au langage naturel, dans ses désinences verbales ou écrites, mais également aux gestes avec l'haptique, à la compréhension des expressions faciales ou à celles des caractéristiques du regard ou de la motricité oculaire ...

La communication est ici comprise comme le partage de contenus cognitifs, représentations ou idées complexes mobilisées dans des contextes de collaboration. De telles idées complexes sont supposées être construites à partir de prototypes cognitifs variant de manière à être adaptés à chaque situation inattendue, non programmée, dans un registre ouvert de connaissances qui s'auto-enrichissent les unes les autres en fonction de l'expérience. C'est ainsi qu'à partir d'un nombre limité d'exemplaires représentationnels de départ, et notamment grâce aux caractéristiques d'un langage ouvert faisant place à l'analyse stochastique des ambiguïtés, peuvent émerger, se construire et se stabiliser des idées de plus en plus complexes.

Le recours à cette production émergente laisse une large part aux théories de la complexité et à celle de l'émergence, pour déboucher sur une forme d'intelligence artificielle capable d'exprimer des idées sur elle-même, c'est-à-dire de s'expliquer elle-même, d'expliquer ses "raisonnements", "représentations" et "décisions" à autrui, que celui-là soit humain ou machinique.

KX : la partage des connaissances ou l'Intelligence artificielle explicable (XAI).

Les succès des apprentissage par machine, apprentissage profond, décision automatique ... amène à un développement, au delà des interfaces CwC, à des applications d'intelligence artificielle (IA) de plus en plus rapide, robustes et autonomes. Ces systèmes sont capables de sentir, percevoir (c'est-à-dire associer des sensations à des représentations internes), se représenter (tenir des inventaires de correspondances congruents entre les éléments et situations réels et ceux représentés au sein des machines comme chez les personnes humaines. Ces apprentissages s'inscrivent dans des activités mnémoniques pour lesquelles les différents registres qualitatifs de mémoires rencontrent les masses de données qui peuvent être traitées dans le cadre du Big Data. Dans ce contexte, les machines sont capables de très rapidement et avec un taux d'erreur très faible de décider et le cas échéant d'agir dans des délais proches de l'immédiateté.

Ces dépassements des simples capacités humaines engendrent la création de machines autonomes, dont le contrôle éventuel ne peut être fait qu'à postériori, dans des temps compatibles avec ceux de la lenteur de l'appareil serveur et/ou cognitif humain.

C'est là que se pose le problème du blocage de l'efficacité des systèmes par l'impossibilité que l'homme a de faire confiance à la machine. On connait ce type de situation dans le domaine du véhicule autonome et encore plus dans celui des SALA (systèmes d'armes létales autonomes) avec lesquels le respect de la vie humaine peut être engagé. La seule solution est une forme d'apprentissage collaboratif, partenarial, de l'homme et de la machine, dans laquelle la machine est capable d'expliquer à l'homme le sens de ses décision et les limites de son autonomie ; ce que ne savent pas faire les machines actuelles.

De tels systèmes symbiotiques (HAT pour Human-Autonomy Teaming) nécessitent une Intelligence Artificielle capable de s'expliquer, et donc "explicable". C'est tout l'enjeu de la "confiance" dans les machines décisionnelles ou de contrôle, dans un projet global d'intégration bidirectionnelle des hommes et des machines, de type XAI.

Libellés :

futur,

homme augmenté,

hybridité,

ia,

numérique

Pays/territoire :

675 N Randolph St, Arlington, VA 22203, États-Unis

25 juin 2018

IA : IBM et la nano-informatique

La société IBM championne de la miniaturisation avec la conception du plus petit ordinateur du monde (lien). Celui-là mesure 0,3 millimètre de côté, de la taille d’un grain de gros sel, et peut donc tenir dans la pointe d’un grain de riz. Il est composé d’un processeur, de mémoire vive, d’une cellule photovoltaïque et un émetteur/récepteur Led pour la communication et sa programmation,

Le dispositif est alimenté par la lumière à la fois po puis ce qui est de l’apport en énergie et la réception des données. Ce nano ordinateur sert de capteur de température en convertissant les températures sous forme d’impulsions électroniques, recueillies au niveau d’un groupe précis de cellules vivantes. Les applications potentielles sont dans le domaine de l’oncologie, mais on lui voit déjà d'autres applications potentielles en santé humaine ou vétérinaire (contrôle des conditions d’élevage), mais également pour la surveillance technologique des composants vidéo et/ou audio, dans la lutte contre la cybercriminalité ou dans celle de la contrefaçon.

Le dispositif est alimenté par la lumière à la fois po puis ce qui est de l’apport en énergie et la réception des données. Ce nano ordinateur sert de capteur de température en convertissant les températures sous forme d’impulsions électroniques, recueillies au niveau d’un groupe précis de cellules vivantes. Les applications potentielles sont dans le domaine de l’oncologie, mais on lui voit déjà d'autres applications potentielles en santé humaine ou vétérinaire (contrôle des conditions d’élevage), mais également pour la surveillance technologique des composants vidéo et/ou audio, dans la lutte contre la cybercriminalité ou dans celle de la contrefaçon.

Libellés :

entreprise,

innovation,

nanotechnologies,

numérique,

technologie

Pays/territoire :

2810 Lemone Industrial Blvd #1, Columbia, MO 65201, États-Unis

03 avril 2018

DIV : Introduction aux sciences humaines et sociétales

par Jean-Claude Sallaberry & Bernard Claverie.

Éditions de L'Harmattan (Paris), collection "Cognition et Formation", 3 avril 2018.

L'idée directrice de cet ouvrage est celle d'une évidence pourtant encore discutée aujourd'hui. Les sciences humaines et sociétales ne peuvent plus ne pas s'inspirer de l'évolution de la science du XX et XXIe siècle. Loin de se vouloir exhaustif, quatre grands "évènements" sont choisis en tant qu'exemples marquants de cette exigence :

- le mouvement structuraliste, qui amène à la théorie des systèmes,

- l'apparition de la physique quantique, qui a radicalement boulversé bien des conceptions admises dans l'explication du monde,

- la complexité, qui ouvre les perspectives de l'auto organisation et de l'émergence.

Au fil de l'ouvrage, face aux "exigences" pour la modélisation qui découlent de ce souci de prise en compte, l'outillage fourni par les ensembles théoriques convoqués (théorie de l'institution, théorie des systèmes, cognitique, théorie de la représentation associée à une théorie du champ...) et retravaillés par les auteurs, permet d'y répondre, ainsi que de donner quelques outils pour la modélisation des "phénomènes" humains et sociétaux.

Broché, ISBN : 978-2-343-14357-6, 214 pages

Libellés :

culture,

épistémologie,

ressource pédagogique,

Sciences cognitives,

shs

Pays/territoire :

7 Rue de l'École Polytechnique, 75005 Paris, France

11 mars 2018

BIO - SHS : Ne pas dire "non" est une histoire de dégoût ou d'autorité.

Vous savez dire non ? Vous avez de la chance ! Certains en sont incapables...

Pourquoi donc certaines personnes peuvent affirmer leur désaccord et d'autres pas ? C'est la question que se sont posée des scientifiques du laboratoire de neurosciences sociales de l'Institute of Cognitive and Clinical Neurosciences de la Monash University (Melbourne), et de l'école de psychologie de l'University du Queensland (St Lucia) en Australie.

Les scientifiques, qui ont publiés leurs résultats dans Frontiers in Human Neuroscience, ont tenté de trouver une explication à ce phénomène bizarre : pourquoi certaines personnes ne peuvent-elles littéralement pas dire "non" ou entrer dans une forme d'opposition à autrui ? Ils ont étudié par imagerie par résonance magnétique fonctionnelle (IRMf) les zones du cerveau en activité chez des patients souffrant d'un trouble léger consistant à ne jamais oser affirmer leur opinion propre et à adopter systématiquement celle des autres. Que se passe-t-il lorsque on leur demande toutefois de se forcer à se dépasser et à imposer leur pensée en déclarant leur propre opinion contradictoire ?

Les régions les plus stimulées dans une telle condition expérimentale sont apparues au niveau du cortex préfrontal médian, supposées impliquées dans le langage, la mémoire de travail, et le raisonnement. Mais, à la différence des témoins, une autre zone est concernée : le cortex insulaire qui est stimulé à ce moment-là. Il correspond à un territoire dont l'activité est habituellement associée au dégoût, à la dépendance et qui semble impliquée dans les processus de prise de conscience. Ces deux régions interagissent chez les patients et provoquent un stress intense. Ainsi, lorsqu’une personne qui ne sait ou ne peut pas dire non est amenée à refuser une opinion, son cerveau génère un message d’anxiété, et elle se comporte comme si elle ne se sentait pas autorisée à penser par elle-même. Les personnes souffrant de ce problème se retrouvent alors dans une situation critique, car elles se sentent obligées d’être conformes à ce que pensent les autres, y compris à l’encontre de leur propre intérêt, ce dont elles ont néanmoins conscience.

De toute façon, être en désaccord n’est jamais une partie de plaisir, et ne facilite pas les bonnes relations sociales… Mais encore moins pour ces personnes qui, selon les chercheurs, se retrouvent en situation de "stress mental intense", dans une situation difficile et anxiogène. La solution, pour elles, serait alors de fuir les situations dans lesquelles elles risqueraient d'entrer en désaccord. Ou bien, l'idéal trouvé par certains est encore plus efficace : obliger les autres à adopter leurs idées.

Pourquoi donc certaines personnes peuvent affirmer leur désaccord et d'autres pas ? C'est la question que se sont posée des scientifiques du laboratoire de neurosciences sociales de l'Institute of Cognitive and Clinical Neurosciences de la Monash University (Melbourne), et de l'école de psychologie de l'University du Queensland (St Lucia) en Australie.

Les scientifiques, qui ont publiés leurs résultats dans Frontiers in Human Neuroscience, ont tenté de trouver une explication à ce phénomène bizarre : pourquoi certaines personnes ne peuvent-elles littéralement pas dire "non" ou entrer dans une forme d'opposition à autrui ? Ils ont étudié par imagerie par résonance magnétique fonctionnelle (IRMf) les zones du cerveau en activité chez des patients souffrant d'un trouble léger consistant à ne jamais oser affirmer leur opinion propre et à adopter systématiquement celle des autres. Que se passe-t-il lorsque on leur demande toutefois de se forcer à se dépasser et à imposer leur pensée en déclarant leur propre opinion contradictoire ?

Les régions les plus stimulées dans une telle condition expérimentale sont apparues au niveau du cortex préfrontal médian, supposées impliquées dans le langage, la mémoire de travail, et le raisonnement. Mais, à la différence des témoins, une autre zone est concernée : le cortex insulaire qui est stimulé à ce moment-là. Il correspond à un territoire dont l'activité est habituellement associée au dégoût, à la dépendance et qui semble impliquée dans les processus de prise de conscience. Ces deux régions interagissent chez les patients et provoquent un stress intense. Ainsi, lorsqu’une personne qui ne sait ou ne peut pas dire non est amenée à refuser une opinion, son cerveau génère un message d’anxiété, et elle se comporte comme si elle ne se sentait pas autorisée à penser par elle-même. Les personnes souffrant de ce problème se retrouvent alors dans une situation critique, car elles se sentent obligées d’être conformes à ce que pensent les autres, y compris à l’encontre de leur propre intérêt, ce dont elles ont néanmoins conscience.

De toute façon, être en désaccord n’est jamais une partie de plaisir, et ne facilite pas les bonnes relations sociales… Mais encore moins pour ces personnes qui, selon les chercheurs, se retrouvent en situation de "stress mental intense", dans une situation difficile et anxiogène. La solution, pour elles, serait alors de fuir les situations dans lesquelles elles risqueraient d'entrer en désaccord. Ou bien, l'idéal trouvé par certains est encore plus efficace : obliger les autres à adopter leurs idées.

Libellés :

bio,

cerveau,

comportement,

handicap,

publication,

shs

Pays/territoire :

Scenic Blvd, Clayton VIC 3800, Australie

BIO : Le cerveau n'est pas ce qu'il était ... pour les symbolistes, et encore moins pour l'IA.

Le débat n’est pas nouveau. Les psychologues s’écharpent depuis toujours pour l’adoption des modèles interprétatifs du fonctionnement de la pensée. À l’époque de Freud, l’hydraulique donnait les outils de comparaison avec les volumes, les pressions, les équilibres instables entre des volumes d’essences et de densités différentes. Vint l’époque des électrons circulant dans des câbles, celle les étincelles, et des différences entre les électricités statique ou circulante (attention ! il s’agit de l’interprétation du monde par les psychologues, pas par les physiciens). La physique quantique permit l’émergence de nouveaux modèles que vinrent encore plus compliquer ceux de la physique relativiste. La notion d’émergence eut récemment son heure de gloire, avant d’être balayée par le Graal de la psychologie cognitive : l’ordinateur.

En fait, ce n’est malheureusement pas l’ordinateur tel qu’on peut ici le penser, à la fois outil, moyen et objet d’étude de l’informatique. L’Albion est par définition perfide ; et les adeptes des chapeaux royaux imposent leur loi au reste du monde que les collaborateurs de la mondialité s’empressent d’adopter et surtout d’imposer : l’anglais. Outre-Manche, on parle de computer et de computation, c’est-à-dire de calcul. Et voici la cognition réduite à quelques opérations supportées par un organe imaginé comme une machine.

Cela aurait été injuste de poser là une forme de réductionnisme strict. Le génial Turing inventa une machine virtuelle : elle était à la fois le papier, la machine, le calcul et la mémoire… un peu comme s’il était impossible de séparer des choses qui, en fait, n’en sont pas vraiment, des choses. Certains autres génies se réunissaient outre-Atlantique pour donner naissance à la cybernétique, et certains d’entre eux inventaient, pour imiter la machine de Turing, les calculateurs selon l’architecture Von Neumann : un calculateur œuvrant sur des données électriques selon les itérations d’un programme rythmé par une horloge. On n'avait pas assez insisté sur le fait que c'était « pour faire comme si c'était ... ». Le plus grand pouvoir de l'analogie est de se faire oublier.

Et voilà que les psychologues avaient un modèle « concret » d’une idée jusque là parfaitement « abstraite »… un peu comme si Freud avait vraiment imaginé qu’il y avait de l’huile, de l’eau ou d’autres fluides dans la tête… et l’ordinateur devint le modèle du cerveau, et le programme celui de la pensée.

Et voilà que les psychologues avaient un modèle « concret » d’une idée jusque là parfaitement « abstraite »… un peu comme si Freud avait vraiment imaginé qu’il y avait de l’huile, de l’eau ou d’autres fluides dans la tête… et l’ordinateur devint le modèle du cerveau, et le programme celui de la pensée.

Autant une machine de Turing universelle (et donc virtuelle) est capable d’imiter toute autre machine de Turing, et par voie de conséquence tout ordinateur fonctionnant, autant elle ne simule aucune machine éteinte ni aucun programme non implémenté. Ce sont les deux en mouvement qu’elle simule, ou les deux volets simultanés de la même chose. Elle s’affranchissant de la ségrégation absurde du calcul, de l’information, de la mémoire, du langage de programmation et de l’horloge… toutes ces choses que nos amis électroniciens rendent séparément de plus en plus puissantes, performantes, séduisantes, merveilleusement imitantes.

Alors, pourquoi tant d’argent pour localiser l’administrateur central de Baddeley, la boucle audio-phonatoire ou le calepin visuo-spatial ? Pourquoi rechercher le neurone miroir de la carotte, du visage de sa mère ou de la bouteille de bière ? Pourquoi tant de psychologues formés à l’utilisation de ces modèles ségrégationnistes des éléments de la pensée, en oubliant son incarnation dans un corps d’humeurs, d’hormones, d'os et de viande soumise à la logique de l’humidité ? Les émotions et le cerveau humide… nous voilà bien loin d’une machine virtuelle dessinée au crayon sur un papier sec. D’autant que… le crayon doit être gras, et plus il l’est, plus il marque, et que le papier s’il est très sec part en poussière. Les choses ne sont donc, même pas là, aussi tranchées qu’elles pourraient le paraître.

Alors que penser de l’IA, cette intelligence artificielle dont tant et tant de spécialistes nous disent qu’elle va supplanter l’intelligence naturelle, la renvoyant aux oubliettes des choses obsolètes. C’est un peu comme si l’on avait prédit la disparition du corps humain et sa substitution par des vérins hydrauliques… et en avoir peur, c’est un peu comme si l’on craignait les locomotives qui font. Elles aussi, beaucoup mieux que le corps humain, en restant toutefois sur des rails, car à côté d’eux, elles ne font pas grand-chose.

Tel est l’avenir de l’intelligence artificielle : elle fera de grandes choses qui aideront les hommes, les rendront plus rapides, plus performants, plus puissants, plus intelligents… mais ne les remplaceront pas… Elle remplacera des métiers, fera beaucoup de chômeurs, enrichira encore plus les mêmes, ou d’autres… fera beaucoup de bonheur pour les uns, de malheur pour les autres, et peut-être fera émerger de nouveaux sentiments, transformera des passions et fera vivre les hommes de manière différente, meilleure ou pire selon le point de vue adopté. Mais pourquoi tirer les sonnettes d’alarmes, faire sonner le glas de la fin de l’humanité par l’IA ? C’est un peu comme si l’on avait craint que les locomotives allaient écraser toute l’humanité. La force n’est pas dans le vérin, le piston ou la bielle, comme l’intelligence n’est pas dans la machine. Ils ne font qu’imiter en mieux certaines parties artificiellement décomposées de ce que certains croient être des éléments d’intelligence.

Ainsi se posent deux problèmes : celui de la confusion entre le calcul et l’intelligence, et celui de la singularité. Prenons celle-là : si c’est pour dire que les machines feront des choses que les cerveaux ne peuvent faire, c’est déjà fait ; plus vite, mieux, de manière plus fiable, et sans être obligé de dormir, de se reposer, de ne pas boire ou de conduire. Si c’est pour craindre qu’elles fassent des choses que nous ne comprendrions plus, c’est également déjà fait. Si c’est pour imaginer qu’elles peuvent s’autonomiser, pourquoi pas. Mais si c’est pour penser qu’elles vont faire la même chose que l’homme ou les autres animaux, leur cerveau doté de leur pensée, alors il est probable que l’on se mette le doigt (qu’elles n’ont pas) dans l’œil (qu’elles n’ont pas non plus). Comme le pensent Miguel Nicolelis et Ronald Cicurel : « The Singularity is not near », tout au moins, pas celle qu’on fantasme.

Comme quoi, on peut être pour un transhumanisme rationnel, scientifique, éthique, et dédramatiser le débat dans lequel veulent nous faire tomber certains alarmistes catastrophismes. Nous ne sommes pas sortis du danger de l’holocauste nucléaire, de celui des viroses ou des atteintes bactériennes, de celui de l’impact d’un astéroïde destructeur ou du réveil d’un super volcan. Il est certain que l’IA va aussi compliquer les choses…

Mais pourquoi toujours se faire peur en donnant un monde sans espoir à nos enfants… ce n’est pas de la faute à l’intelligence artificielle, mais bien aux limites de la pensée naturelle, empreinte dans ses méandres irrationnels (voir ici).

Mais pourquoi toujours se faire peur en donnant un monde sans espoir à nos enfants… ce n’est pas de la faute à l’intelligence artificielle, mais bien aux limites de la pensée naturelle, empreinte dans ses méandres irrationnels (voir ici).

Libellés :

cerveau,

complexité,

épistémologie,

ia,

polémique,

Sciences cognitives

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

04 mars 2018

DIV : Le retour de l'obscurantisme.

Égypte, le 11 février 2018 ; alors que, selon Le Point, le gouvernement s'apprête à criminaliser l’athéisme, Marianne se fait l’écho (ici) d’un événement encore pour quelques-uns incroyable : l’expulsion d’une personne se disant athée (voir le sketch), du plateau d’une émission populaire de l’une des innombrables chaînes satellitaires égyptiennes (liste).

Quoi dire des arguments qui sont développés par le présentateur animateur et son invité, si celui-ci ne se présentait pas comme directeur adjoint (deputy sheikh) de l'université millénaire, certes islamique mais publique Al-Azhar. L’argumentaire du jeune homme reposait sur son choix d’adopter une théorie explicative des origines non déiste, et l’explication que le postulat du big-bang n’empêchait en rien sa moralité et son utilité sociale. De quoi émouvoir le Middle East Media Research Institute (MEMRI) qui a relayé l’extrait de l’émission le vendredi 2 mars suivant, diffusant la vidéo de ce moment jusque-là passé inaperçu et qui, s’il est avéré, frise le surréalisme le plus absolu (voir ici). Tout cela n’a pas manqué de mobiliser l’assemblée des bien-pensants de la théorie du complot. En effet, la question reste de savoir s’il s’agit ou non d’un « fake » (voir), et la blogosphère s’est enflammée pour dénoncer, discuter et surtout discutailler, à coups de relais, renvois (repost) et commentaires allant des plus farouchement opposés aux religions à la défense fanatique de celles-là, ou même, par voie de conséquence, au soutien inconditionnel à la neutralité et l’objectivité de MEMRI à sa critique la plus bassement antisémite.

Bref, cela nous rappelle le festival des branquignolles, et le projet d’Amira Kharoubbi, étudiante à l’École nationale d'ingénieurs de Sfax, qui a travaillé depuis 2011 sous la direction du Professeur Jamel Touir, dans le cadre d'une thèse dénonçant Copernic, Galilée, Kepler, Newton, Einstein, etc. et promouvant l’évidence physique de la platitude de la Terre (voir ici). Quant aux Américains, il y en a toujours pour aller encore plus loin… et Mike Hughes (voir ici) tente toujours de lancer sa fusée. Et voilà qu’à Bordeaux, certains ramènent « leur science » sous le masque de la « laïcité nouvelle donne » : tout le monde a le droit de penser ce qu’il veut, de croire à n’importe quoi, et surtout de venir « em....r » les professeurs avec des arguments aussi iréniques que débiles (au sens littéral de faibles et chétifs) pour les engager à plus de souplesse dans leur rigueur scientifique. Surréaliste, la perspective actuelle est celle d’une excommunication express des scientifiques : arguments confus, incompréhensibles et échappant au contrôle direct des citoyens par les réseaux sociaux, allant de la remise en cause de la physique, évidemment non complète, à la substitution de la psychologie par les belles images des neurobiologistes que tout le monde peut voir, ou le refus des nécessités de la vaccination pour les enfants. Cela est inquiétant, après un siècle de progrès théorique, voici revenu à grand galop les politiciens de la tolérance obligatoire et de l’acceptation des discours les plus religieux.

Mais revenons à Dieu ou, plus exactement, à son contraire « non-dieu ». Dans une excellente chronique du Point (lien), Roger-Paul Droit rappelle que déjà Platon, dans son dernier dialogue « les Lois », dénonce athées et agnostiques, tous ceux qui mettent en cause l'existence des dieux, pour les enfermer et même les tuer s’ils restent impossibles à fléchir. De tels esprits seraient des « ferments de discorde et de désorganisation », véritables majeurs pour toute « Cité juste ». L’inquisition et l’ordre islamiques n’ont pas été en reste, et Droit rappelle comment Voltaire, opposant au clergé, aux fanatismes et aux superstitions, dénonce paradoxalement les athées accusés « de s'affranchir de toute morale ». Si Voltaire est libre penseur, le vulgum pecus, le commun des mortels, la multitude ignorante ne peuvent jouir de pareille liberté et tenus à rênes courtes. Celles des freins de la religion et de la crainte du châtiment divin en sont d’excellente et « Si Dieu n'existait pas, il faudrait l'inventer ». Et Droit de citer le constat du Dmitri, le modèle de l'homme de tous les jours, partagé entre ses passions et ses doutes, celui des Frères Karamazov qui n’est ni l'homme de foi, ni l'intellectuel matérialiste : « Que faire, si Dieu n’existe pas, si Rakitine a raison de prétendre que c’est une idée forgée par l’humanité ? Dans ce cas, l’homme serait le roi de la terre, de l’univers. Très bien ! Seulement, comment sera-t-il vertueux sans Dieu ? Je me le demande. En effet, qui l’homme aimera-t-il ? À qui chantera-t-il des hymnes de reconnaissance ? Rakitine rit. Il dit qu’on peut aimer l’humanité sans Dieu. Ce morveux peut l’affirmer, moi je ne puis le comprendre » (DostoÏevski : ici). Voilà la crainte, si le big bang est théorisé, si tout est prédéterminé ou pour le moins les grandes règles de l’organisation physique, si dieu est inventé, si la science explique le réel, si les robots créent leur propre intelligence, et s’il n’y a pas un bout d’âme à montrer dans les images du cerveau, alors certains ne l’accepteront pas. C’est pour eux intolérable ; et l’intolérable est source d’intolérance (toujours selon Marianne, l'Egypte se prépare à adopter une loi criminalisant la non croyance en dieu - lien).

Et les pires sont comme d'habitude les mous ... les "laïques mous", les adeptes de la bien-pensance, ceux qui permettent de jeter tout en recommandant toujours plus d'ouverture et de tolérance, acceptant la toujours même discussion, sans fin, dans les mêmes « débats », celui d'un dieu absolu et de la suspecte science. Prenez garde, pauvres matérialistes, les juges vont un jour vous poursuivre ! Pendant ce temps, les stratèges de la défense rivent leurs yeux sur les brumes de Clausewitz en sortant de la messe sans voir Poutine investir dans l'IA. De nouveaux politiques, biberonnés à l’école confessionnelle sans avoir eu la chance de vivre une école républicaine, de la science et de la lumière, dont les hussards lassés pensent à d'autres mondes, rêvent parfois de régler son compte au statut protégé des scientifiques ... (peut-être après celui des cheminots ?). La science est en danger, le danger n'est pas dieu, mais bien entendu ceux qui s'en réclament de manière absolue, et refusent d'entendre. c'est aussi celui du découragement des scientifiques submergés d'administration plutôt qu'incité à librement chercher et encouragés à transmettre.

Quoi dire des arguments qui sont développés par le présentateur animateur et son invité, si celui-ci ne se présentait pas comme directeur adjoint (deputy sheikh) de l'université millénaire, certes islamique mais publique Al-Azhar. L’argumentaire du jeune homme reposait sur son choix d’adopter une théorie explicative des origines non déiste, et l’explication que le postulat du big-bang n’empêchait en rien sa moralité et son utilité sociale. De quoi émouvoir le Middle East Media Research Institute (MEMRI) qui a relayé l’extrait de l’émission le vendredi 2 mars suivant, diffusant la vidéo de ce moment jusque-là passé inaperçu et qui, s’il est avéré, frise le surréalisme le plus absolu (voir ici). Tout cela n’a pas manqué de mobiliser l’assemblée des bien-pensants de la théorie du complot. En effet, la question reste de savoir s’il s’agit ou non d’un « fake » (voir), et la blogosphère s’est enflammée pour dénoncer, discuter et surtout discutailler, à coups de relais, renvois (repost) et commentaires allant des plus farouchement opposés aux religions à la défense fanatique de celles-là, ou même, par voie de conséquence, au soutien inconditionnel à la neutralité et l’objectivité de MEMRI à sa critique la plus bassement antisémite.

Bref, cela nous rappelle le festival des branquignolles, et le projet d’Amira Kharoubbi, étudiante à l’École nationale d'ingénieurs de Sfax, qui a travaillé depuis 2011 sous la direction du Professeur Jamel Touir, dans le cadre d'une thèse dénonçant Copernic, Galilée, Kepler, Newton, Einstein, etc. et promouvant l’évidence physique de la platitude de la Terre (voir ici). Quant aux Américains, il y en a toujours pour aller encore plus loin… et Mike Hughes (voir ici) tente toujours de lancer sa fusée. Et voilà qu’à Bordeaux, certains ramènent « leur science » sous le masque de la « laïcité nouvelle donne » : tout le monde a le droit de penser ce qu’il veut, de croire à n’importe quoi, et surtout de venir « em....r » les professeurs avec des arguments aussi iréniques que débiles (au sens littéral de faibles et chétifs) pour les engager à plus de souplesse dans leur rigueur scientifique. Surréaliste, la perspective actuelle est celle d’une excommunication express des scientifiques : arguments confus, incompréhensibles et échappant au contrôle direct des citoyens par les réseaux sociaux, allant de la remise en cause de la physique, évidemment non complète, à la substitution de la psychologie par les belles images des neurobiologistes que tout le monde peut voir, ou le refus des nécessités de la vaccination pour les enfants. Cela est inquiétant, après un siècle de progrès théorique, voici revenu à grand galop les politiciens de la tolérance obligatoire et de l’acceptation des discours les plus religieux.

Mais revenons à Dieu ou, plus exactement, à son contraire « non-dieu ». Dans une excellente chronique du Point (lien), Roger-Paul Droit rappelle que déjà Platon, dans son dernier dialogue « les Lois », dénonce athées et agnostiques, tous ceux qui mettent en cause l'existence des dieux, pour les enfermer et même les tuer s’ils restent impossibles à fléchir. De tels esprits seraient des « ferments de discorde et de désorganisation », véritables majeurs pour toute « Cité juste ». L’inquisition et l’ordre islamiques n’ont pas été en reste, et Droit rappelle comment Voltaire, opposant au clergé, aux fanatismes et aux superstitions, dénonce paradoxalement les athées accusés « de s'affranchir de toute morale ». Si Voltaire est libre penseur, le vulgum pecus, le commun des mortels, la multitude ignorante ne peuvent jouir de pareille liberté et tenus à rênes courtes. Celles des freins de la religion et de la crainte du châtiment divin en sont d’excellente et « Si Dieu n'existait pas, il faudrait l'inventer ». Et Droit de citer le constat du Dmitri, le modèle de l'homme de tous les jours, partagé entre ses passions et ses doutes, celui des Frères Karamazov qui n’est ni l'homme de foi, ni l'intellectuel matérialiste : « Que faire, si Dieu n’existe pas, si Rakitine a raison de prétendre que c’est une idée forgée par l’humanité ? Dans ce cas, l’homme serait le roi de la terre, de l’univers. Très bien ! Seulement, comment sera-t-il vertueux sans Dieu ? Je me le demande. En effet, qui l’homme aimera-t-il ? À qui chantera-t-il des hymnes de reconnaissance ? Rakitine rit. Il dit qu’on peut aimer l’humanité sans Dieu. Ce morveux peut l’affirmer, moi je ne puis le comprendre » (DostoÏevski : ici). Voilà la crainte, si le big bang est théorisé, si tout est prédéterminé ou pour le moins les grandes règles de l’organisation physique, si dieu est inventé, si la science explique le réel, si les robots créent leur propre intelligence, et s’il n’y a pas un bout d’âme à montrer dans les images du cerveau, alors certains ne l’accepteront pas. C’est pour eux intolérable ; et l’intolérable est source d’intolérance (toujours selon Marianne, l'Egypte se prépare à adopter une loi criminalisant la non croyance en dieu - lien).

Et les pires sont comme d'habitude les mous ... les "laïques mous", les adeptes de la bien-pensance, ceux qui permettent de jeter tout en recommandant toujours plus d'ouverture et de tolérance, acceptant la toujours même discussion, sans fin, dans les mêmes « débats », celui d'un dieu absolu et de la suspecte science. Prenez garde, pauvres matérialistes, les juges vont un jour vous poursuivre ! Pendant ce temps, les stratèges de la défense rivent leurs yeux sur les brumes de Clausewitz en sortant de la messe sans voir Poutine investir dans l'IA. De nouveaux politiques, biberonnés à l’école confessionnelle sans avoir eu la chance de vivre une école républicaine, de la science et de la lumière, dont les hussards lassés pensent à d'autres mondes, rêvent parfois de régler son compte au statut protégé des scientifiques ... (peut-être après celui des cheminots ?). La science est en danger, le danger n'est pas dieu, mais bien entendu ceux qui s'en réclament de manière absolue, et refusent d'entendre. c'est aussi celui du découragement des scientifiques submergés d'administration plutôt qu'incité à librement chercher et encouragés à transmettre.

Libellés :

culture,

épistémologie,

éthique,

polémique

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

DIV : De l’oubli des contraintes cognitives.

Nous savons bien le mépris dans lequel les politiques tiennent les scientifiques. Persuadés qu'ils sont de détenir «"a réalité", ils "savent" ce qui est bien pour les autres, "investi d'une mission" d'histoire, et fiers d’etre capables d’assumer "être impopulaires", argument ultime pour faire passer leurs habituelles prétentions, oukases ou faiblesses de courage.

On peut parler du décalage entre l’heure d’hivers et l’heure d’été, que nos organismes supportent mal toujours plus de quarante ans après. Le 19 septembre 1975, dans un contexte d'économie d'énergie, MM. Chirac, D'Ornano et Cavaillé décrétèrent que le 28 mars 1976 serait le début d'une mesure "provisoire" qui ne devait durer que le temps du choc pétrolier. Un autre exemple encore plus caractéristique est celui des longueurs des mois, qui nous contraint toujours, plus de deux mille ans après une des décisions politiques les plus prétentieuses de l’ordre Romain.

Chacun sait, depuis l’école primaire, qu’une année fait 365 jours, un peu plus tous les quatre ans et en début de siècle, pour rattraper la désynchronisation des rotations terrestres, l’une sur elle-même, l’autre autour du soleil (365,24 jours). Il était donc possible, et les astrologues devenus astronomes puis astrophysiciens l’avaient bien montré, d’alterner des mois de 29 et de 31 jours (en fait, c’etait Un peu plus compliqué) et de supprimer un jour de temps en temps.

C’était sans compter sur l’empereur Auguste !!! Le calendrier julien, qui précéda notre calendrier grégorien, débutait alors en mars, mois du dieu de la guerre, pour se terminer en février, celui qui permettait ainsi les réajustements nécessaires à la fois de fin de mois et de fin d’année. Le nom de februarius dérive du verbe februare, qui signifie "purifier" ; la purification en fin de cycle.

Le mois de juillet était quant à lui consacré à César : julius en latin, july en anglais ... celui d’août célébrait le nom d’Auguste : augustus, august. Mais voilà, celui de Jules était de 31 jours et celui d’Auguste se retrouvait donc plus court. Impossible à supporter pour un nouvel qui devait s'inscrire dans l'histoire ! Auguste a donc décidé de prendre un jour au mois de rattrapage et de le rajouter au mois d’août. Le calendrier grégorien a depuis changé l’ordre des mois et février est alors apparu en début d’année, rendant le système complètement incompréhensible.

Mais l’empereur était content ; fier comme un bar-tabac, disait Bérurier quelques années avant d’être repris par Coluche ... S'engouffrant dans la brèche, de multiples conseillers ont amener les princes à ajouter, retirer, rattraper, supprimer des jours par ci, par là, afin de faire rentrer le décalage des deux rotations terrestre dans une logique calendaire des plus absconse : plus personne n'y comprend goute, et les savants discutent encore ...

Cela nous rappelle évidemment d’autres aberrations par rapport à des règles établies en prenant en compte la facilité de comprendre. Par exemple, il en est ainsi des vitesses sur la route. Sans entrer dans l’évidence que "diminuer la vitesse économise des morts" (voir aussi le modèle de Nilsson), les experts avaient admis que la complexité du code de la route devait faire l’objet de mesure de simplification "cognitique", reposant sur des règles spontanément compréhensibles pour les usagers de la route. Par exemple, les vitesses imposées aux automobilistes, ce qui est différent pour les poids lourds, sont « impaires » : 30 et 50 km/h en agglomération, 70 et 90 sur routes normales, 110 et 130 sur les voies rapides et autoroutes. C’etait simple et le serait resté si un politique n’avait souhaité imprimer sa marque : plutôt que de baisser à 70, il le fit à 80, rendant ainsi, comme Auguste, tout incompréhensible ... et évidemment pour de longues années !

Voulant rester sans l’histoire comme celui qui a eu le courage de sauver des vies, il n’est pas certains qu’il ne soit pas celui qui sera cité comme le responsable du grand bazar, comme Auguste ... toutes proportions gardées ; on espère bien que la voiture autonome n’attendra pas 2000 ans.

Cet exemple amusant montre combien il est encore difficile de convaincre de respecter les caracteristiques, limites ou préférences cognitives spontanés des usagers dans des processus qui les concernent tous.

Voulant rester sans l’histoire comme celui qui a eu le courage de sauver des vies, il n’est pas certains qu’il ne soit pas celui qui sera cité comme le responsable du grand bazar, comme Auguste ... toutes proportions gardées ; on espère bien que la voiture autonome n’attendra pas 2000 ans.

Cet exemple amusant montre combien il est encore difficile de convaincre de respecter les caracteristiques, limites ou préférences cognitives spontanés des usagers dans des processus qui les concernent tous.

Libellés :

complexité,

comportement,

éthique,

polémique

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

13 février 2018

BIO : Le sandwich pollutant.

Dans un article publié ce mois-ci, l’Association britannique du sandwich (BSA) rend compte d'une étude de l'université de Manchester, publiée dans la revue Sustainable Production and Consumption.

Cette étude révèle que la consommation annuelle des sandwichs consommés au Royaume Uni serait responsable de l’émission de près de 10 tonnes de CO2, ce qui équivaut à l’utilisation de 8,6 millions de voitures sur un an.

Cette consommation serait de 11,5 milliards de sandwichs par an, dont la moitié étant préparée à la maison et l'autre achetée dans le commerce. Elle génèrerait en moyenne 9,5 millions de tonnes d'équivalent CO2.

En cause, la production, la transformation, leur emballage, leur transport mais surtout la conservation au frais des sandwichs. Cclle-là, dans les grandes surfaces représente ainsi jusqu'à 25% de leur empreinte carbone. L'étude estime que cette empreinte pour un seul sandwich est équivalente en moyenne à celle d'une voiture roulant pendant 19 km.

Cette catastrophe écologique pourrait être réduite de 50% en modifiant d'une part les recettes, d'autre part l'emballage et le recyclage des déchets, et enfin en repoussant simplement leur date de péremption. Ainsi, la BSA estime que prolonger la durée de conservation des sandwichs en assouplissant les dates de consommation pourrait permettre d'économiser au moins 2.000 tonnes de déchets par an.

Le plus écologique serait de célèbre "jambon-fromage" fait à la maison.

Voir ici (pdf).

Libellés :

curiosité,

info générale,

publication

Pays/territoire :

18 Moor St, Chepstow NP16 5DB, Royaume-Uni

25 janvier 2018

BIO : Un pas de plus vers le clonage humain.

Des chercheurs d’un laboratoire de l’institut de neurosciences de l’Académie des Sciences de Shanghaï (Chine), dirigés par le professeur Qiang Sun, publient dans la revue scientifique

Cell du 24 janvier 2018

les résultats d’une manipulation génétique ayant conduit pour la première fois au clonage de primates.

Ils ont utilisé sur deux macaques les techniques qui avaient permis de créer la brebis Dolly il y a quelque vingt ans.

Les deux petits singes, Zhong Zhong and Hua Hua, ont été conçus à quelques semaines de différence l’un de l’autre. Ils sont pourtant porteur d’un patrimoine génétique commun, comme s’ils étaient des jumeaux homozygotes. Autrement dits, ce sont des clones issus, dans le cas présent, de la même cellule provenant de la même mère.

Selon les auteurs, cette percée pourrait contribuer à stimuler la recherche médicale, notamment en permettant d’observer chez l’un des clones l’impact de la modification d’un gène réputé lié à une maladie humaine, en comparant les deux animaux, et de liés à des maladies cancéreuses.

Néanmoins, cette manipulation suscite beaucoup d’inquiétudes en Occident, où elles n’auraient deontologiquement pas pu être menée. Ainsi, de possibles dérives sont à craindre, notamment sur d’autres espèces encore plus proches de l’humain, et pourquoi pas, in fine, sur l’homme lui-même pour lequel, puisque la barrière vient de tomber, on peut donc et on sait aujourd’hui facilement transférer la méthode.

Pays/territoire :

320 Yueyang Rd, Xuhui Qu, Shanghai Shi, Chine

21 janvier 2018

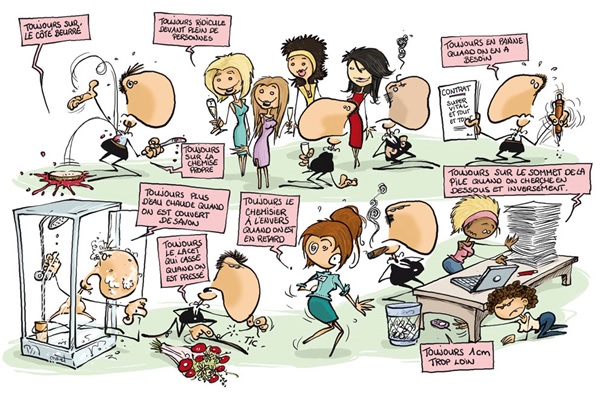

SHS : Un peu de management ... la Loi de Murphy.

La Loi de Murphy, dite de loi de l'emmerdement maximum, est un principe empirique dû à l'ingénieur en aérospatiale Edward Aloysius Murphy (1918-1990) de l'United States Air Force Institute of Technology. La paternité de son énonciation première reste néanmoins discutée par certains, ce qui n’a probablement pas grande importance.

Une de ses formulations les plus connues est « tout ce qui peut mal se passer va mal se passer »,

et en anglais pour les puristes « anything that can go wrong, will go wrong » ou « if anything can go wrong, it will ».

Pour l'histoire, c'est en 1945 que commença sur la Base Wright-Patterson, puis de 1947 à 1949 sur la Base Muroc de l'US Air Force, devenue depuis Base Edwards, le projet MX981. Le but était de tester la tolérance humaine à la décélération brutale. Pour cela, on lançait un chariot propulsé par une fusée sur des rails, ralenti de manière brutale par une série de freins hydrauliques . Les premiers tests utilisaient un mannequin, puis des chimpanzés, et enfin on eut recours à un cobaye humain. Edward Murphy, ingnieur en charge de l'étude, proposa de mesurer l'effort subi par des jauges électroniques sur les sangles du harnais. L'assistant de Murphy se serait trompé et aurait câblé les capteurs à l'envers, ce qui fait qu'un premier test sur un chimpanzé donna des valeurs aberrantes. Agacé, Murphy aurait prononcé sa célèbre phrase : « if that guy has any way of making a mistake, he will » (« si ce gars là trouve le moyen de faire une erreur, il la fera »). La Loi de Murphy serait donc initialement une énonciation péjorative impliquant une personne particulière. Elle a, en tout état de cause, été rapidement généralisée à l'ensemble des phénomènes observés qui motivent une perception négative.

Cet adage est ainsi habituellement associé en France à la loi dite de « l’emmerdement maximum » ou LEM. On en trouve des variétés sous la dénomination de « loi de la tartine beurrée » scientifiquement étudiée par Robert Matthews, éminent physicien de l'Université d'Aston (UK), et selon laquelle la tartine retombe toujours du mauvais côté, ou de « loi de la mauvaise queue au supermarché », qui dispose que la queue d'à coté, celle que l'on n'a pas choisie, avance évidemment plus vite.

On connait en France le principe ou « effet Bonaldi », associée au nom d'un célèbre animateur de télévision, Jérôme Bonaldi, qui présentait des objets et inventions insolites à la fin de l'émission « Nulle part ailleurs », présentations qui rataient toujours alors que l'objet fonctionnait habituellement sans problème. L'effet Bonaldi est donc un cas particulier de la loi de Murphy. qui s'énonce « toute démonstration d’un produit quelconque qui fonctionne parfaitement rate lamentablement lors de la démonstration publique ».

La « loi militaire de l'emmerdement maximal » semble remonter à la première guerre mondiale. Elle pronostique que « s'il y a une faille dans un plan de bataille, l'ennemi l'exploitera » puisqu'il analysera toutes les options possibles. Elle est à l'origine des procédures dites de « branch plan » qui mènent rapidement à une explosion combinatoire des solutions potentielles et motive aujourd'hui les stratèges à former des espoirs sur les outils analytiques du big data et de l'intelligence artificielle.

La « loi de Bouchard », dite « loi du Fatal Error », est une application informatique de la loi de Murphy. Le nombre de « crashes » (FatalError) d'un logiciel est inversement proportionnel au nombre de sauvegardes. C'est à dire que « moins l'on sauvegarde souvent, plus le risque de corruption est élevé ». On peut la formuler en bureautique par le fait que « c'est toujours à la fin d'un long travail et juste avant qu'on ne l'enregistre qu'un travail plante ». Certains considère même que « c'est juste quand on vient de sauvegarder un travail sur la sauvegarde précédente qu'on s'aperçoit que ce travail et donc la dernière sauvegarde sont pervertis, et l'avant dernière effacée ».

Pour les puristes, on différencie la « loi de Murphy », qui est devenue générale, de la « loi de Finagle », qui n'implique aucune intervention humaine volontaire. On la retrouve énoncée, selon le niveau de matérialisme ou spiritualité de chacun, comme règle de la perversité de l’univers qui tend vers un maximum, ou comme règle de la divinité malveillante. Ainsi, pas besoin de beurrer une tartine, de choisir une file de supermarché, ou d'agir en quelque que ce soit ... « quand ça peut aller mal, ca va forcément aller mal ».

L'ambiguïté réside dans la notion d'intervention humaine. On admet donc comme loi de Murphy le fait que « si tout de passe bien mais qu'il y a une solution pour que ça aille mal, il y aura toujours quelqu'un pour faire que ça aille mal », de la loi de Finagle selon laquelle « même si on a réussi miraculeusement à une épreuve d'examen, il y aura toujours un accident ou un recours qui fera qu'elle sera annulée ».

Pour résumé, on peut dire que la loi de Murphy correspond plus au fait que « il y aura forcément une inattention, une erreur, une maladresse, ou un imbécile, un malfaisant, un casse pieds pour que ça aille de travers ou que ça rate » (c'est toujours de la faute de quelqu'un, il n'avait qu'à beurrer les deux côtés de la biscotte, comme ça elle ne tomberait pas), alors que la loi de Finagle fait que « de toutes manières, si ça peut rater, ça va rater » ... et même parfois « ça va rater même si ça ne peut pas rater » (même si on ne beurre pas la tartine, elle va tomber).

Cette systématisation de la noirceur pronostique, amène ainsi à des paradoxes amusants. Des études statistiques rigoureuses ont ainsi montré que la loi de Murphy se vérifie avec une probabilité significativement plus grande. Pourtant, l'absence de résultats significatifs avec de la confiture ne laisse pas insensible ceux qui s'en mettent plein les doigts car elle ne tombe pas, mais elle casse. Des études ont permis d'étudier les biais cognitifs (biais d'observation erronée, biais d'évaluation du temps qui passe avec minimisation de secondes positives et maximisation des négatives, etc.) qui concernent les comportements erronés (changement de file lorsque celle qu'on a quittée avance plus vite) et le sentiment de frustration qu'induit le fait d'être passif dans la mauvaise file sur l’autoroute.

Cette systématisation de la noirceur pronostique, amène ainsi à des paradoxes amusants. Des études statistiques rigoureuses ont ainsi montré que la loi de Murphy se vérifie avec une probabilité significativement plus grande. Pourtant, l'absence de résultats significatifs avec de la confiture ne laisse pas insensible ceux qui s'en mettent plein les doigts car elle ne tombe pas, mais elle casse. Des études ont permis d'étudier les biais cognitifs (biais d'observation erronée, biais d'évaluation du temps qui passe avec minimisation de secondes positives et maximisation des négatives, etc.) qui concernent les comportements erronés (changement de file lorsque celle qu'on a quittée avance plus vite) et le sentiment de frustration qu'induit le fait d'être passif dans la mauvaise file sur l’autoroute.

Le « corollaire de Blumenfeld » dispose quant à lui que, les statistiques étant vérifiées, si une tartine beurrée tombe du côté non beurré, c'est qu'elle a été beurrée du mauvais côté ». Le « paradoxe du chat beurré » combine quant-à lui deux lois concurrentes. Une tartine beurrée fixée sur le dos d'un chat jeté par la fenêtre ne tombe pas puisque le chat ne peut tomber sur le dos. On produit donc ainsi un chat volant, ce qui ne fait pas les affaires de Batman.

A lire : La Loi de Murphy, de David McCallum (lien).

Une de ses formulations les plus connues est « tout ce qui peut mal se passer va mal se passer »,

et en anglais pour les puristes « anything that can go wrong, will go wrong » ou « if anything can go wrong, it will ».

Pour l'histoire, c'est en 1945 que commença sur la Base Wright-Patterson, puis de 1947 à 1949 sur la Base Muroc de l'US Air Force, devenue depuis Base Edwards, le projet MX981. Le but était de tester la tolérance humaine à la décélération brutale. Pour cela, on lançait un chariot propulsé par une fusée sur des rails, ralenti de manière brutale par une série de freins hydrauliques . Les premiers tests utilisaient un mannequin, puis des chimpanzés, et enfin on eut recours à un cobaye humain. Edward Murphy, ingnieur en charge de l'étude, proposa de mesurer l'effort subi par des jauges électroniques sur les sangles du harnais. L'assistant de Murphy se serait trompé et aurait câblé les capteurs à l'envers, ce qui fait qu'un premier test sur un chimpanzé donna des valeurs aberrantes. Agacé, Murphy aurait prononcé sa célèbre phrase : « if that guy has any way of making a mistake, he will » (« si ce gars là trouve le moyen de faire une erreur, il la fera »). La Loi de Murphy serait donc initialement une énonciation péjorative impliquant une personne particulière. Elle a, en tout état de cause, été rapidement généralisée à l'ensemble des phénomènes observés qui motivent une perception négative.

Cet adage est ainsi habituellement associé en France à la loi dite de « l’emmerdement maximum » ou LEM. On en trouve des variétés sous la dénomination de « loi de la tartine beurrée » scientifiquement étudiée par Robert Matthews, éminent physicien de l'Université d'Aston (UK), et selon laquelle la tartine retombe toujours du mauvais côté, ou de « loi de la mauvaise queue au supermarché », qui dispose que la queue d'à coté, celle que l'on n'a pas choisie, avance évidemment plus vite.

On connait en France le principe ou « effet Bonaldi », associée au nom d'un célèbre animateur de télévision, Jérôme Bonaldi, qui présentait des objets et inventions insolites à la fin de l'émission « Nulle part ailleurs », présentations qui rataient toujours alors que l'objet fonctionnait habituellement sans problème. L'effet Bonaldi est donc un cas particulier de la loi de Murphy. qui s'énonce « toute démonstration d’un produit quelconque qui fonctionne parfaitement rate lamentablement lors de la démonstration publique ».

La « loi militaire de l'emmerdement maximal » semble remonter à la première guerre mondiale. Elle pronostique que « s'il y a une faille dans un plan de bataille, l'ennemi l'exploitera » puisqu'il analysera toutes les options possibles. Elle est à l'origine des procédures dites de « branch plan » qui mènent rapidement à une explosion combinatoire des solutions potentielles et motive aujourd'hui les stratèges à former des espoirs sur les outils analytiques du big data et de l'intelligence artificielle.

La « loi de Bouchard », dite « loi du Fatal Error », est une application informatique de la loi de Murphy. Le nombre de « crashes » (FatalError) d'un logiciel est inversement proportionnel au nombre de sauvegardes. C'est à dire que « moins l'on sauvegarde souvent, plus le risque de corruption est élevé ». On peut la formuler en bureautique par le fait que « c'est toujours à la fin d'un long travail et juste avant qu'on ne l'enregistre qu'un travail plante ». Certains considère même que « c'est juste quand on vient de sauvegarder un travail sur la sauvegarde précédente qu'on s'aperçoit que ce travail et donc la dernière sauvegarde sont pervertis, et l'avant dernière effacée ».

Pour les puristes, on différencie la « loi de Murphy », qui est devenue générale, de la « loi de Finagle », qui n'implique aucune intervention humaine volontaire. On la retrouve énoncée, selon le niveau de matérialisme ou spiritualité de chacun, comme règle de la perversité de l’univers qui tend vers un maximum, ou comme règle de la divinité malveillante. Ainsi, pas besoin de beurrer une tartine, de choisir une file de supermarché, ou d'agir en quelque que ce soit ... « quand ça peut aller mal, ca va forcément aller mal ».

L'ambiguïté réside dans la notion d'intervention humaine. On admet donc comme loi de Murphy le fait que « si tout de passe bien mais qu'il y a une solution pour que ça aille mal, il y aura toujours quelqu'un pour faire que ça aille mal », de la loi de Finagle selon laquelle « même si on a réussi miraculeusement à une épreuve d'examen, il y aura toujours un accident ou un recours qui fera qu'elle sera annulée ».

Pour résumé, on peut dire que la loi de Murphy correspond plus au fait que « il y aura forcément une inattention, une erreur, une maladresse, ou un imbécile, un malfaisant, un casse pieds pour que ça aille de travers ou que ça rate » (c'est toujours de la faute de quelqu'un, il n'avait qu'à beurrer les deux côtés de la biscotte, comme ça elle ne tomberait pas), alors que la loi de Finagle fait que « de toutes manières, si ça peut rater, ça va rater » ... et même parfois « ça va rater même si ça ne peut pas rater » (même si on ne beurre pas la tartine, elle va tomber).

Cette systématisation de la noirceur pronostique, amène ainsi à des paradoxes amusants. Des études statistiques rigoureuses ont ainsi montré que la loi de Murphy se vérifie avec une probabilité significativement plus grande. Pourtant, l'absence de résultats significatifs avec de la confiture ne laisse pas insensible ceux qui s'en mettent plein les doigts car elle ne tombe pas, mais elle casse. Des études ont permis d'étudier les biais cognitifs (biais d'observation erronée, biais d'évaluation du temps qui passe avec minimisation de secondes positives et maximisation des négatives, etc.) qui concernent les comportements erronés (changement de file lorsque celle qu'on a quittée avance plus vite) et le sentiment de frustration qu'induit le fait d'être passif dans la mauvaise file sur l’autoroute.