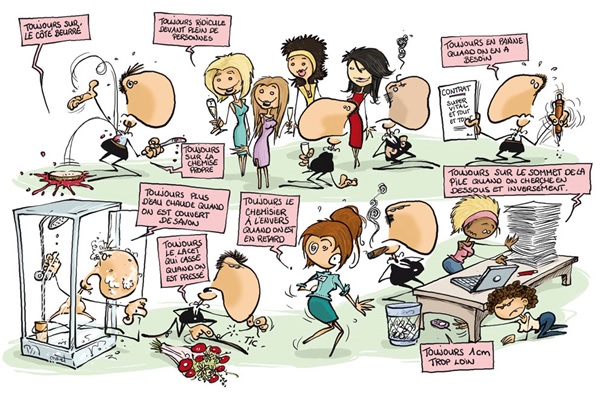

La Loi de Murphy, dite de loi de l'emmerdement maximum, est un principe empirique dû à l'ingénieur en aérospatiale Edward Aloysius Murphy (1918-1990) de l'United States Air Force Institute of Technology. La paternité de son énonciation première reste néanmoins discutée par certains, ce qui n’a probablement pas grande importance.

Une de ses formulations les plus connues est « tout ce qui peut mal se passer va mal se passer »,

et en anglais pour les puristes « anything that can go wrong, will go wrong » ou « if anything can go wrong, it will ».

Pour l'histoire, c'est en 1945 que commença sur la Base Wright-Patterson, puis de 1947 à 1949 sur la Base Muroc de l'US Air Force, devenue depuis Base Edwards, le projet MX981. Le but était de tester la tolérance humaine à la décélération brutale. Pour cela, on lançait un chariot propulsé par une fusée sur des rails, ralenti de manière brutale par une série de freins hydrauliques . Les premiers tests utilisaient un mannequin, puis des chimpanzés, et enfin on eut recours à un c

obaye humain. Edward

Murphy, ingnieur en charge de l'étude, proposa de mesurer l'effort subi par des jauges électroniques sur les sangles du harnais. L'assistant de Murphy se serait trompé et aurait câblé les capteurs à l'envers, ce qui fait qu'un premier test sur un chimpanzé donna des valeurs aberrantes. Agacé, Murphy aurait prononcé sa célèbre phrase : « if that guy has any way of making a mistake, he will » (« si ce gars là trouve le moyen de faire une erreur, il la fera »). La Loi de Murphy serait donc initialement une énonciation péjorative impliquant une personne particulière. Elle a, en tout état de cause, été rapidement généralisée à l'ensemble des phénomènes observés qui motivent une perception négative.

Cet adage est ainsi habituellement associé en France à la loi dite de « l’emmerdement maximum » ou LEM. On en trouve

des variétés sous la dénomination de

«

loi de la tartine beurrée » scientifiquement

étudiée

par Robert Matthews, éminent physicien de l'Université d'Aston (UK)

, et selon laquelle la tartine retombe toujours du mauvais côté, ou de «

loi de la mauvaise queue au supermarché », qui dispose que la queue d'à coté, celle que l'on n'a pas choisie, avance évidemment plus vite.

On connait en France le

principe ou «

effet Bonaldi », associée au nom d'un célèbre animateur de télévision,

Jérôme Bonaldi, qui présentait des objets et inventions insolites à la fin de l'émission « Nulle part ailleurs », présentations qui rataient toujours alors que l'objet fonctionnait habituellement sans problème. L'

effet Bonaldi est donc un cas particulier de la

loi de Murphy. qui s'énonce « toute démonstration d’un produit quelconque qui fonctionne parfaitement rate lamentablement lors de la démonstration publique ».

La «

loi militaire de l'emmerdement maximal » semble remonter à la première guerre mondiale. Elle pronostique que « s'il y a une faille dans un plan de bataille, l'ennemi l'exploitera » puisqu'il analysera toutes les options possibles. Elle est à l'origine des procédures dites de « branch plan » qui mènent rapidement à une explosion combinatoire des solutions potentielles et motive aujourd'hui les stratèges à former des espoirs sur les outils analytiques du big data et de l'intelligence artificielle.

La «

loi de Bouchard », dite «

loi du Fatal Error », est une application informatique de la

loi de Murphy. Le nombre de « crashes » (FatalError) d'un logiciel est inversement proportionnel au nombre de sauvegardes. C'est à dire que « moins l'on sauvegarde souvent, plus le risque de corruption est élevé ». On peut la formuler en bureautique par le fait que « c'est toujours à la fin d'un long travail et juste avant qu'on ne l'enregistre qu'un travail plante ». Certains considère même que « c'est juste quand on vient de sauvegarder un travail sur la sauvegarde précédente qu'on s'aperçoit que ce travail et donc la dernière sauvegarde sont pervertis, et l'avant dernière effacée ».

Pour les puristes, on différencie la «

loi de Murphy », qui est devenue générale, de la «

loi de Finagle », qui n'implique aucune intervention humaine volontaire. On la retrouve énoncée, selon le niveau de matérialisme ou spiritualité de chacun, comme

règle de la perversité de l’univers qui tend vers un maximum, ou comme

règle de la divinité malveillante. Ainsi, pas besoin de beurrer une tartine, de choisir une file de supermarché, ou d'agir en quelque que ce soit ... « quand ça peut aller mal, ca va forcément aller mal

».

L'ambiguïté réside dans la notion d'intervention humaine. On admet donc comme

loi de Murphy le fait que « si tout de passe bien mais qu'il y a une solution pour que ça aille mal, il y aura toujours quelqu'un pour faire que ça aille mal

», de la

loi de Finagle selon laquelle « même si on a réussi miraculeusement à une épreuve d'examen, il y aura toujours un accident ou un recours qui fera qu'elle sera annulée

».

Pour résumé, on peut dire que la

loi de Murphy correspond plus au fait que « il y aura forcément une inattention, une erreur, une maladresse, ou un imbécile, un malfaisant, un casse pieds pour que ça aille de travers ou que ça rate

» (c'est toujours de la faute de quelqu'un, il n'avait qu'à beurrer les deux côtés de la biscotte, comme ça elle ne tomberait pas), alors que la

loi de Finagle fait que « de toutes manières, si ça peut rater, ça va rater

» ... et même parfois « ça va rater même si ça ne peut pas rater

» (même si on ne beurre pas la tartine, elle va tomber).

Cette systématisation de la noirceur pronostique, amène ainsi à des paradoxes amusants. Des études statistiques rigoureuses ont ainsi montré que la

loi de Murphy se vérifie avec une probabilité significativement plus grande. Pourtant, l'absence de résultats significatifs avec de la confiture ne laisse pas insensible ceux qui s'en mettent plein les doigts car elle ne tombe pas, mais elle casse. Des études ont permis d'étudier les biais cognitifs (biais d'observation erronée, biais d'évaluation du temps qui passe avec minimisation de secondes positives et maximisation des négatives, etc.) qui concernent les comportements erronés (changement de file lorsque celle qu'on a quittée avance plus vite) et le sentiment de frustration qu'induit le fait d'

être passif dans la mauvaise file sur l’autoroute.

Le «

corollaire de Blumenfeld » dispose quant à lui que, les statistiques étant vérifiées, si une tartine beurrée tombe du côté non beurré, c'est qu'elle a été beurrée du mauvais côté

». Le «

paradoxe du chat beurré » combine quant-à lui deux lois concurrentes. Une tartine beurrée fixée sur le dos d'un chat jeté par la fenêtre ne tombe pas puisque

le chat ne peut tomber sur le dos. On produit donc ainsi un

chat volant, ce qui ne fait pas les affaires de Batman.

A lire : La Loi de Murphy, de David McCallum (

lien).