L'intelligence artificielle (IA) a de beaux jours devant elle en médecine (lien ici) et là. Ainsi, un robot chinois a même réussi l'examen national de médecine pour devenir médecin. Ainsi, le robot Xiaoyi, qui a été développé par le leader chinois de l'IA iFlytek en collaboration avec l’université pékinoise de Tsinghua, a obtenu son diplôme national de médecine après avoir obtenu 456 points sur 600, soit 96 points de plus que la note minimale pour être reçu, et bien supérieure à la moyenne nationale, en moins d'une heure pour une épreuve prévue sur dix heures. Pour obtenir ce résultat, alors que les examinateurs ont vérifié que Xiaoyi ne se connectait pas à Internet et ne travaillait qu'avec sa mémoire et sa réflexion, le robot a parcouru et compilé en moins d'un an et demi un million d'images médicales, 53 ouvrages, deux millions de dossiers médicaux et 400 000 autres documents et rapports. L'objectif d'iFlytek est dans un premier temps d'utiliser l'IA de Xiaoyi pour aider les praticiens à améliorer les traitements, notamment pour les cancers, améliorer leurs diagnostics et le choix des traitements, et aider à la formation de nouveaux médecins. Il devrait également être déployé dans toute la Chine dès mars 2018 pour lutter contre les déserts médicaux. Si les Chinois sont aujourd’hui les leader en matière d’intelligence artificielle médicale, il ambitionnent maintenant d'étendre leur suprématie de manière générale en IA d’ici à 2030 (lien).

Cognitique / Cognitics - Ce site est destiné aux élèves ingénieurs et aux doctorants de l'École Nationale Supérieure de Cognitique (ENSC Bordeaux-INP). Il donne en complément des enseignements des pistes de documentation et de débat selon les thèmes SHS, IA, BIO, TECH, culture, infos générales et vie de l'ENSC. Il prépare notamment aux épreuves du grand oral de fin d’études.

19 décembre 2017

IA : Pourquoi ne pas consulter un robot médecin ?

Libellés :

futur,

homme augmenté,

ia,

robot,

santé,

technologie

Pays/territoire :

30 Shuang Qing Lu, Haidian Qu, Beijing Shi, Chine, 100085

16 décembre 2017

BIO, INFO : Vers « la » grande base de données biométriques des humains.

La région autonome de Xinjiang, dite région ouïghoure du Xinjiang ou Turkestan oriental, est une des plus grande régions chinoise, occupant le nord-ouest de la Chine. Elle dispose d’un statut d’autonoimie et son gouvernement est en responabilité de la sécurité dans une région disposant de richesses métallifères et pétrolifère remarquables. Alors que la société est divisée en ethnies, dans un équilibre précaire, on assiste depuis une dizaine d’année à des violences interethniques opposant les populations chinoise et des adeptes religieux qui sont qualifiés de terroristes par le pouvoir en place. C’est dans ce contexte sympathique que les autorités ont entrepris de collecter l’ensemble des données biométriques des habitants de plus de douze ans, et notamment leur ADN. C’est par un rapport de Human Rights Watch (lien) que l’on a appris cette collecte officielle (lien vers l’information du site du gouvernement : ici) pour inventorier les données génétiques, sanguines et bipmétriques telles que les carcatéristiques de l’iris relevé par scanner et les empreintes digitales.

La Chine est donc en train d’expérimenter, sans bruit, dans l’une de ses régions les plus fermées, la collecte des informations biologiques sur des millions de personnes n’ayant pourtant aucun lien avec une quelconque entreprise criminelle ou terroriste.

Aussi intéressant, les autorités chinoises sont soutenues par deux entreprises américaines, Thermo Fisher Scientific, qui procure l’équipement pour le séquençage des ADN, et Blackwater, entreprise de protection impliquée dans nombre conflits récents, qui forme les agents de sécuité. Le partage des tâches se passe en bonne entente entre la police qui collecte les photos, empreintes digitales, le scanner de l’iris, ainsi que les informations familauile et de résidence, et les autorités de santé chargées de la collecte des échantillons d’ADN et des informations sanguines sous couvert d’un programme de “check-up médical pour tous”.

Bel exemple de « convergence » NBIC.

La Chine est donc en train d’expérimenter, sans bruit, dans l’une de ses régions les plus fermées, la collecte des informations biologiques sur des millions de personnes n’ayant pourtant aucun lien avec une quelconque entreprise criminelle ou terroriste.

Aussi intéressant, les autorités chinoises sont soutenues par deux entreprises américaines, Thermo Fisher Scientific, qui procure l’équipement pour le séquençage des ADN, et Blackwater, entreprise de protection impliquée dans nombre conflits récents, qui forme les agents de sécuité. Le partage des tâches se passe en bonne entente entre la police qui collecte les photos, empreintes digitales, le scanner de l’iris, ainsi que les informations familauile et de résidence, et les autorités de santé chargées de la collecte des échantillons d’ADN et des informations sanguines sous couvert d’un programme de “check-up médical pour tous”.

Bel exemple de « convergence » NBIC.

Libellés :

éthique,

futur,

info générale,

polémique

Pays/territoire :

Xinjiang, Chine

14 décembre 2017

DIV : Vers la fin de l’égalité devant Internet.

Le président Barack Obama avait en 2015 confirmé la règle de « neutralité du net », garantissant à tous un Internet libre et ouvert. L’Internet était alors considéré comme un bien public, au même titre que le réseau téléphonique, et les règles de neutralité et d’égalité s’y appliquaient donc selon le même principe.

Or, ce jeudi 14 décembre 2017, le gendarme américain de l’Internet, la Commission fédérale des communications, a fait voler en éclats le principe d’égalité de traitement et d’accès des connexions : désormais les opérateurs US feront ce qu’ils veulent (lien). Ralentir la vitesse de connexion pour accéder à certains sites, l’augmenter pour certains autres, seront possibles selon des logiques techniques, commerciales ou ... idéologiques. Ainsi, et c’est l’argument principal motivant cette mesure libérale , les réseaux sociaux qui génèrent le plus de trafic pourront être ralentis. Mais tout sera également permis, comme facturer des suppléments pour garantir des vitesses et des performances préservées.

Si ce principe est pour l’instant circonscrit aux USA, l’Europe étant préservée, notamment en France grâce à la Loi de 2016 pour une République numérique, certains n’ont évidemment pas attendu pour relancer l’idée. Ainsi le PDG d’un grand opérateur national déclare incontournable l’obligation de créer un Internet à plusieurs vitesses, avec évidemment une oreille attentive de certains nouveaux politiques ...

Or, ce jeudi 14 décembre 2017, le gendarme américain de l’Internet, la Commission fédérale des communications, a fait voler en éclats le principe d’égalité de traitement et d’accès des connexions : désormais les opérateurs US feront ce qu’ils veulent (lien). Ralentir la vitesse de connexion pour accéder à certains sites, l’augmenter pour certains autres, seront possibles selon des logiques techniques, commerciales ou ... idéologiques. Ainsi, et c’est l’argument principal motivant cette mesure libérale , les réseaux sociaux qui génèrent le plus de trafic pourront être ralentis. Mais tout sera également permis, comme facturer des suppléments pour garantir des vitesses et des performances préservées.

Si ce principe est pour l’instant circonscrit aux USA, l’Europe étant préservée, notamment en France grâce à la Loi de 2016 pour une République numérique, certains n’ont évidemment pas attendu pour relancer l’idée. Ainsi le PDG d’un grand opérateur national déclare incontournable l’obligation de créer un Internet à plusieurs vitesses, avec évidemment une oreille attentive de certains nouveaux politiques ...

Libellés :

économie,

éthique,

info générale,

internet,

numérique,

polémique,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

27 novembre 2017

IA : L'intelligence artificielle forte.

Les spécialistes de l’Intelligence Artificielle (IA) distinguent l’IA "forte" de l’IA "faible".

Il n’est évidemment pas question ici de puissance, mais d’une forme "épistémologique" de la discipline privilégiant l’inspiration d’imitation ou celle d’indépendance du fonctionnement de l’Intelligence Naturelle (IN).

Plus exactement, la première forme d'IA désigne l'intelligence d'une machine, ordinateur, drone ou robot, la plus similaire possible à l'intelligence des êtres humains, conçue comme étant issue de choses simples combinées entre-elles, pour arriver à des choses compliquées, voire complexes dans le cas de productions émergentes.

Ces productions potentielles permettraient alors à la machine la plus sophistiquée, pour l'heure théorique, d'être dotée de "conscience", allant jusqu’à pouvoir éprouver des besoins, des émotions et des sentiments. Cet automate imitatif pourrait à un certain niveau de complexité penser lui-même, croire que son existence bien qu’artificielle, et cela avec ou non l’intervention de composants naturels dans le cas de constructions "hybrides", soit d’essence animale ou même humaine.

Ce problème de la "conscience" doit être conçu à deux dimensions : celle de la "conscience de soi" et celle de la "conscience de situation". La première permet à l’automate de considérer sa propre existence comme "personnelle", unique et inscrite dans une forme d’expérience du passé et d’une ambition du futur, et la seconde, permettant l’appréciation des caractéristiques du milieu environnement physique, relationnel humain, hybride ou artificiel, est constitutive du sentiment de la différence entre "soi" et "non soi". Ces deux dimensions concurrentes sont constitutives d’une forme de "compréhension" de ses propres "raisonnements", d'une "métacognition", et de l’émergence d’un "sens moral", c'est-à-dire d'un jugement porté sur ses propres pensées, comportements et intentions.

Pour un tel projet, il convient de distinguer les deux formes incompatibles de l’IA que sont le "symbolisme" et le "connexionnisme".

Dans le premier cas, un programme exprimé dans un langage interne manipulant des symboles selon des règles d’une grammaire bio inspirée, hybride, ou complètement artificielle, permet l'expression d’éléments émergents, non strictement programmés. Il doit cependant disposer de caractéristiques fondamentales telles que de la mémoire, des capacités d’apprentissage, une logique interne et une forme de motivation à la "survie" et à l’appétence "cognitive". Ce programme doit donc être en mesure d’emmagasiner des informations et d’y adapter son propre fonctionnement, avec une "motivation" à s’enrichir lui-même. Un programme autonome intelligent qui reste dans son coin sans rien faire et rien connaître de son environnement ne sert à rien, ni pour lui ni pour d’autres. Il peut rester temporairement en sommeil, mais doit pouvoir être "réveillé" en fonction de l’apparition des circonstances qui permettraient son "intégration" environnementale.

Les spécialistes de l’IA imaginent qu’un tel programme commence avec des concepts simples pour les combiner selon des règles de logique, et ainsi arriver à l’expression de comportements complexes. Certains informaticiens s’inspirent de l'apprentissage de l’enfant qui s’adapte et apprend de son environnement physique et relationnel, pour programmer une "aptitude cognitive". Celle-là n’est pas suffisante sans une "motivation" qui entraîne le programme lui-même à s’auto-enrichir. Le programme assemble alors entre eux des éléments simples pour produire des éléments qui le sont moins, et ainsi de suite. Ces éléments sont des représentations de l’environnement ou d'éléments de logiques, c’est-à-dire des symboles. La perspective évolutive est ici non prévue, même si elle peut être incitée, et les connaissances comme les représentations ou les réactions ultérieures ne sont pas contenues dans le programme initial. Il y a bien "émergence" des éléments d’intelligence ; cette émergence peut être hiérarchisée en niveaux allant de l’inventaire des éléments de base jusqu’aux concepts les plus sophistiqués ou même, le cas échéant, jusqu’à la conscience de soi et celle de son environnement.

L’approche connexionniste s’affranchit quant à elle de la présence d’un programme interne manipulant des symboles. Elle s'affranchit également d'une mémoire déclarative contenant des symboles et surtout d'une horloge qui règle les séquences des itérations internes comme dans une architecture Von Neumann. Seules les caractéristiques organisationnelles, fonctionnelles et structurales, de la machine sont définies au départ. Ce sont les capacités de modifications internes de l’automate qui permettent une "auto-organisation" interne, intimement couplée avec l’environnement, capable d’en détecter les modifications et de s’y adapter en fonction de cette transformation interne. Les réseaux de la machine sont évolutifs et peuvent se doter de nouvelles connexions ou même de nouveaux composants par enrichissement circonstanciel. La machine peut alors, dans un cas théorique parfait, recruter d’autres machines ou même des hommes pour partager un patrimoine informationnel commun ou réparti en fonction des besoins. Le système de couplage environnemental est ici au centre d’un fonctionnement auto-émergent et peut, dans un cas idéal promu par certains spécialistes de l’IA connexionniste, s’auto-enrichir et s’autoproduire selon le principe d'une "autopoïèse", c'est-à-dire d'une propre production de soi.

L’apprentissage connexionniste se fait en deux processus concurrents et concourants : imprégnation, et enrichissement. Il n’y a pas à proprement parler de mémoire déclarée en symboles dans un programme formel. Les symboles ne sont ici que l'expression de la machine capable de lire certains de ses états internes. Cette expression est structurée par une grammaire qui émerge des contraintes structurales et fonctionnelles de l’automate, ainsi que de l’environnement dont la machine à "conscience" ; elle n’est pas en elle, ni implémentée ni incarnée, mais s’exprime dans l’intégration machine-milieu. Dans le connexionnisme, la mémoire prospective résulte de la disposition de nouveaux réseaux ou la modification d’anciens, la mémoire rétrospective dans le maintien de configurations existantes, qui peuvent ou non être réutilisées, remobilisées de manières complète ou partielle. Ce recyclage explique ainsi des phénomènes quasi naturels d’amnésie et de modulation des souvenirs.

De manière concrète, la plupart des programmes d’IA dite "ascendante" correspondent actuellement à des architectures comportant plusieurs éléments simples reliés entre eux, à l'imitation du vivant, mais implémentés sur des structures de calcul symbolistes (architecture Von Neumann). On joue à faire "comme si" c'était vivant. Même si c’est l’interaction entre les éléments qui dicte le fonctionnement du programme, celui-là reste contraint par une segmentation du programme et de la mémoire, et par un fonctionnement réglé par une rythmique séquentielle contrainte par une ultrahorloge interne totalement étrangère à une structure naturelle. Même si le programme peut évoluer et faire exprimer des comportements non initialement programmés, cette émergence est limitée par la structure même de l’électronique actuelle.

Néanmoins, le plus grand avantage de l’IA ascendante est qu’elle peut apprendre et s’adapter. Cette approche permet également une imitation plus fidèle de la cognition naturelle avec des programmes conçus analogiquement à des êtres vivants, ou même à des ensembles d’êtres vivants, réseaux ou collectivités En effet, les types de programmes les plus connus d’IA ascendante concernent les systèmes multi-agents, les algorithmes génétiques et le deep learning, et les réseaux de neurones formels ou artificiels.

On est donc encore loin d'une réalité artificielle connexionniste, en restant à un jeu d'imitation dans lequel même Alan Turing savait qu'il n'était question que d'une pâle copie de la réalité du vivant.

Libellés :

complexité,

hybridité,

ia,

NTIC,

numérique,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

25 octobre 2017

DIV : Vivre et agir avec les drones - RACAM 2017

La 11ème Rencontre Aviation Civile Aviation Militaire se tiendra le 16 novembre 2017 au siège de la Direction générale de l’Aviation civile – DGAC Paris 15ème.

La thématique sera cette année consacrée à "vivre et agir avec les drones".

Lieu privilégié d’échanges entre les grands acteurs internationaux du monde aéronautique, RACAM réunit les hauts responsables de l’aviation civile et des armées, les industriels, les directeurs généraux de compagnies aériennes et d’aéroports, les unions et groupements professionnels, les associations et, globalement, tous les utilisateurs de l’espace aérien.

Trois tables rondes aborderont successivement :

- L’AUTONOMIE DES SYSTÈMES : VISIONS CROISÉES RECHERCHE INDUSTRIE ET DÉFENSE

- LES USAGES FUTURS : PERSPECTIVES CIVILES ET MILITAIRES

- LA SÉCURITÉ ET LA SÛRETÉ DES DRONES : MAÎTRISER DES RISQUES

Programme (ici).

Inscription obligatoire (là).

Libellés :

conférence,

futur,

hybridité,

innovation,

robot,

technologie

Pays/territoire :

50 Rue Henry Farman, 75720 Paris, France

21 septembre 2017

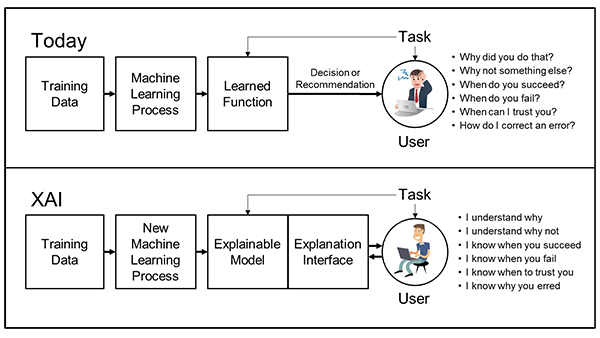

IA : eXplainable Artificial Intelligence - XAI

David Gunning, expert de la DARPA, a récemment promu une note sur l'eXplainable Artificiel Intelligence.

Le "deep learning" ou "apprentissage profond par machine" est un des domaines central d'application de l''Intelligence Artificielle. Les progrès en la matière ont permis de développer des systèmes autonomes qui collectent, analysent, regroupent et synthétisent des informations (perception), élaborent et stabilise des règles de représentation et de décision (apprentissage), et proposent ou prennent eux-mêmes des décisions (action). malheureusement, ces systèmes se heurtent au mu de la "confiance numérique" et mobilisant chez les humains des sentiments de méfiance, voire de défiance, conduisant dans les cas extrêmes de paranoïa à des déclarations intempestives de grands industriels du numérique sur la menace de l'IA sur l'avenir de l'humanité.

En fait, il est fort probable que cette "défiance numérique" soit relative à une forme d'incapacité des machines et systèmes à expliquer leurs processus, analyses et décisions ainsi que leurs propositions ou actions aux hommes avec lesquels ces machines sont sensées collaborer.

Les grands domaines régaliens de l'Etat, les services publics ainsi que de nombreuses entreprises privées sont aujourd'hui confrontés de plus en plus à de tels systèmes collaboratifs (HAT pour Human Artificial Teaming, ou MMS pour Man Machine Symbiosis). Ils sont de plus en plus nombreux, et de plus en plus performants, tout en échappant de plus en plus à la compréhension rationnelle. Il devient donc urgent de traiter d'un nouveau domaine de l'IA qui est connu chez les anglo-saxons court l'acronyme de "XAI" pour "Explainable Artificial Intelligence".

La XAI sera essentielle lorsque les futurs opérateurs de dispositifs amplifiés vont être amenés à à comprendre et gérer efficacement une nouvelle génération de smart machines.

Pour cela, le programme XAI doit s'attacher à des modèles plus explicables et compréhensibles, tout en maintenant un niveau élevé de performance, tant en précision qu'en rapidité et ciblage de l'efficacité, notamment prédictive (gaming), pour permettre l'établissement d'une confiance dans les artéfacts et leurs actions.

Les modèles explicables doivent s'inspirer et éventuellement être combinés aux techniques d'IHM, en valorisant les dimensions UX User eXperience) et KX (Knowledge eXchange). Cette préoccupation doit évidemment être prise en compte dès la conception des systèmes, alors qu'aujourd'hui, ce sont des patch explicatifs ou de convivialité qui sont surajoutés aux dispositifs existants.

Libellés :

futur,

ia,

ihm,

numérique,

technologie

Pays/territoire :

675 N Randolph St, Arlington, VA 22203, États-Unis

18 août 2017

TECH : Techno hype - Gartner publie son cycle 2017.

L’institut de conseil et d'études technologiques Gartner est l'un des grands observateurs et analystes mondiaux de l'évolution des technologies. Il a théorisé au début des années 2000 les étapes de maturité et d'adoption de ces technologies innovantes qui semblent suivre une dynamique particulière appelée "cycle du hype". Ce cycle correspond ni plus ni moins à une courbe logistique bien connue en biologie cybernétique pour traiter de l'homéostasie ("processus opposants" de Sokoloff), que les experts de Gartner ont redécouvert ou en s'en inspirant pour l'appliquer aux évolutions technologiques. Le peu de publications sur le sujet de la part de Gartner laisse planer l'ambiguïté sur ces quelque 110 cycles proposés (payants), mais chacun sait que la science est un éternel renouvellement!

Mais qu'est-ce que veut dire "hype" ?

Littéralement, on peut traduire par "branché", "dans le coup", "dans le vent". A l'origine, le terme vient du monde anglo-saxon de la couture et désigne le "battage" ou le "tapage médiatique", promu par certains médias à un moment donné (articles, reportages, éditoriaux, émissions tv, photos de starts portant de la "hype", etc.). Certains préfèrent la notion d’avant-gardisme suscitant d'abord une certaines méfiance, voire un refus, mais arrivant à percer grâce au battage et à la réputation des adeptes. Les trucs "hype" se diffusent par le "buzz".

Gartner observe ce qui est à la mode, participe par ses observations au tapage et fait donc le buzz. A force de répétition et de pouvoir de conviction, l'institut a imposé son cycle et en fait même commerce, en le protégeant probablement auprès de juriste qui n'ont jamais rien lu en biologie. Le buzz fait son effet, et le monde industriel et des technologies suivent la mode : en techno, et bien évidemment en électronique ou informatique, il faut être branché ! Sinon ça s'arrête et il faut rebooter...

Voyons de plus près : selon Gartner, chaque technologie innovante suit la dynamique de la "hype" (ou du "hype", comme l'on veut). Les technologies qui survivent passent par le phénomène "hype" théorisé en cinq stades. Ces étapes sont "déposées par Gartner" et correspondent à la perception de l'avancée de ces technologies par les experts et les industriels, et à leur popularité auprès du public.

Ce chemin traverse donc successivement les étapes de l'enthousiasme du début (innovation trigger), des attentes irrationnelles (peak of inflated expectations), du désenchantement ou de la désillusion (trough of disillusionment), du retour en lumière (slope of enlightenment), puis de la mise en productivité vers le succès (plateau of productivity).

D'après Gartner, qui se garde bien de publier les données sources sur lesquelles il s'appuie pour valider cette uniformité de parcours, toutes les technologies qui ont réussi telles que l'internet, le cloud, le big data, la 3G, le smartphone et les tablettes, etc. ont emprunté cette dynamique et ont franchi a leur propre vitesse les différentes étapes du cycle "hype".

Chaque été, l'Institut Gartner publie son édition annuelle, en précisant les états d'avancement et les délais nécessaires avant leur adoption à grande échelle pour chaque technologie potentiellement d'avenir.

L'an passé, Gartner indiquait par exemple le 16 aout (2016), les états suivants :

- enthousiasme pour la poussière intelligente, l'impression 4D et l'ordinateur quantique ;

- attente irrationnelle pour la blockchain, la maison connectée et les véhicules autonomes ;

- désillusion pour l'internet des objets, le machine learning et la réalité augmentée ;

- illumination pour la réalité virtuelle, le contrôle gestuel et l'impression 3D.

Ce 15 aout 2017, Gartner a publié (lien) :

- enthousiasme pour la poussière intelligente, l'impression 4D, l'homme augmenté et les BCI ;

- attente irrationnelle pour les robots intelligents, le machine learning, le deep et le smart learning ;

- désillusion pour les véhicules autonomes, la blockchain et la réalité augmentée ;

- illumination pour la réalité virtuelle.

En fait, Gartner indique trois tendances fortes.

1/ - L'intelligence artificielle généralisée (partout), avec l'IA générale mais aussi le deep et le machine learning, la poussière intelligente, les véhicules autonomes, l'informatique cognitive, les drones commerciaux, les interfaces de conversation, les robots et espaces de vie et de travail intelligents ...

Ces technologies suscitent les attentes les plus fortes que ce soit de la part du public, des experts ou des industriels.

2/- Les technologies d'immersion, avec l'impression 4D (objets qui peuvent changer de forme), les brain-computer interfaces, l'homme augmenté par les systèmes technologiques, et qui restent à des phases d'enthousiasmes. La réalité virtuelle, la réalité augmentée, les nanotubes électroniques ou la maison connectée sont plus proches de la maturité.

3/- Les plateformes digitales avec la 5G, la blockchain, l'internet des objets, l'informatique quantique, les systèmes neuromorphiques, le edge computing ...

Ces technologies sont chargées d'espoir et doivent pouvoir révolutionner le monde des usagers des technologies.

Voir le tableau synthétique ici (lien).

Tout cela est très "hype" ... On verra bien.

Mais qu'est-ce que veut dire "hype" ?

Littéralement, on peut traduire par "branché", "dans le coup", "dans le vent". A l'origine, le terme vient du monde anglo-saxon de la couture et désigne le "battage" ou le "tapage médiatique", promu par certains médias à un moment donné (articles, reportages, éditoriaux, émissions tv, photos de starts portant de la "hype", etc.). Certains préfèrent la notion d’avant-gardisme suscitant d'abord une certaines méfiance, voire un refus, mais arrivant à percer grâce au battage et à la réputation des adeptes. Les trucs "hype" se diffusent par le "buzz".

Gartner observe ce qui est à la mode, participe par ses observations au tapage et fait donc le buzz. A force de répétition et de pouvoir de conviction, l'institut a imposé son cycle et en fait même commerce, en le protégeant probablement auprès de juriste qui n'ont jamais rien lu en biologie. Le buzz fait son effet, et le monde industriel et des technologies suivent la mode : en techno, et bien évidemment en électronique ou informatique, il faut être branché ! Sinon ça s'arrête et il faut rebooter...

Voyons de plus près : selon Gartner, chaque technologie innovante suit la dynamique de la "hype" (ou du "hype", comme l'on veut). Les technologies qui survivent passent par le phénomène "hype" théorisé en cinq stades. Ces étapes sont "déposées par Gartner" et correspondent à la perception de l'avancée de ces technologies par les experts et les industriels, et à leur popularité auprès du public.

Ce chemin traverse donc successivement les étapes de l'enthousiasme du début (innovation trigger), des attentes irrationnelles (peak of inflated expectations), du désenchantement ou de la désillusion (trough of disillusionment), du retour en lumière (slope of enlightenment), puis de la mise en productivité vers le succès (plateau of productivity).

D'après Gartner, qui se garde bien de publier les données sources sur lesquelles il s'appuie pour valider cette uniformité de parcours, toutes les technologies qui ont réussi telles que l'internet, le cloud, le big data, la 3G, le smartphone et les tablettes, etc. ont emprunté cette dynamique et ont franchi a leur propre vitesse les différentes étapes du cycle "hype".

Chaque été, l'Institut Gartner publie son édition annuelle, en précisant les états d'avancement et les délais nécessaires avant leur adoption à grande échelle pour chaque technologie potentiellement d'avenir.

L'an passé, Gartner indiquait par exemple le 16 aout (2016), les états suivants :

- enthousiasme pour la poussière intelligente, l'impression 4D et l'ordinateur quantique ;

- attente irrationnelle pour la blockchain, la maison connectée et les véhicules autonomes ;

- désillusion pour l'internet des objets, le machine learning et la réalité augmentée ;

- illumination pour la réalité virtuelle, le contrôle gestuel et l'impression 3D.

Ce 15 aout 2017, Gartner a publié (lien) :

- enthousiasme pour la poussière intelligente, l'impression 4D, l'homme augmenté et les BCI ;

- attente irrationnelle pour les robots intelligents, le machine learning, le deep et le smart learning ;

- désillusion pour les véhicules autonomes, la blockchain et la réalité augmentée ;

- illumination pour la réalité virtuelle.

En fait, Gartner indique trois tendances fortes.

1/ - L'intelligence artificielle généralisée (partout), avec l'IA générale mais aussi le deep et le machine learning, la poussière intelligente, les véhicules autonomes, l'informatique cognitive, les drones commerciaux, les interfaces de conversation, les robots et espaces de vie et de travail intelligents ...

Ces technologies suscitent les attentes les plus fortes que ce soit de la part du public, des experts ou des industriels.

2/- Les technologies d'immersion, avec l'impression 4D (objets qui peuvent changer de forme), les brain-computer interfaces, l'homme augmenté par les systèmes technologiques, et qui restent à des phases d'enthousiasmes. La réalité virtuelle, la réalité augmentée, les nanotubes électroniques ou la maison connectée sont plus proches de la maturité.

3/- Les plateformes digitales avec la 5G, la blockchain, l'internet des objets, l'informatique quantique, les systèmes neuromorphiques, le edge computing ...

Ces technologies sont chargées d'espoir et doivent pouvoir révolutionner le monde des usagers des technologies.

Voir le tableau synthétique ici (lien).

Tout cela est très "hype" ... On verra bien.

Libellés :

économie,

futur,

homme augmenté,

hybridité,

ia,

info générale,

innovation,

interfaces,

internet,

modélisation,

NTIC,

numérique,

publication,

réalité virtuelle,

robot,

technologie,

technologies portables

Pays/territoire :

56 Top Gallant Rd, Stamford, CT 06902, États-Unis

10 août 2017

BIO : Tout est bon dans le cochon ... mutant !

George Church et Luhan Yang sont deux chercheurs en génétique de l'Université d'Harvard (Cambridge, Massachusetts, USA). Ils ont fondé la société

eGenesis

,

une startup de Cambridge qui a réuni 38 millions de dollars US en vue d'utiliser le CRISPR-Cas9 afin de modifier le génome des cochons pour les rendre compatibles avec des xénogreffes au bénéfice des humains.

En effet, les USA, comme d'ailleurs l'Europe, sont confrontés à une pénurie de donneurs et d'organes sains. La situation est telle que plus de vingt malades américains meurent chaque jour faute d'avoir pu recevoir un greffon à temps.

La société eGenesis est parvenue à obtenir la naissance de 37 porcelets dont les organes sont potentiellement compatibles pour une transplantation sur un humain depuis un donneur animal, sans effets secondaires ni danger viral pour le greffé

voir l'article ici

.

La transplantation du porc vers l'humain était jusqu'ici limitée aux valves cardiaques et sous certaines conditions très lourdes au pancréas. Grâce aux techniques d'ingénierie génétique, les deux scientifiques et une équipe internationale ont réussi à retirer les gènes responsables de certains virus dans l'ADN des porcs avant le développement embryonnaire.

Aujourd'hui âgés de 4 mois, 37 porcelets sont élevés en disposant d'organes développés naturellement tout en étant compatibles avec un future xénotransplantation sans effets secondaires ni danger pour la santé du greffé. Une première tentative pourrait être programmée d'ici 2 à 3 ans.

Ces travaux ont été publiés le 10 août 2017 dans la revue Science de l'American Association for the Advancement of Science

(article ici)

Voir le détail de la publication

selon ce lien.

A quand des transplantations d'oeil, de cochlée, d'épithélium olfactif, voire de morceau de cerveau ?

A quand des transplantations d'oeil, de cochlée, d'épithélium olfactif, voire de morceau de cerveau ?

Pays/territoire :

300 Technology Square, Cambridge, MA 02139, États-Unis

03 août 2017

BIO : Le CRISPR-Cas 9 et la modification des embryons humains.

Dans leur chronique publiée le 2 août 2017 sur le site de la revue Nature "Biotechnology: At the heart of gene edits in human embryos", Nerges Winblad et Fredrik Lanner du département des sciences cliniques de l’Institut Karolinska de Stockholm (Suède), commentent les nouvelles dimensions biologiques, les applications cliniques mais également les contraintes éthiques posées par le travail de l'équipe de Shoukhrat Mitalipov, directeur du centre de thérapie génétique et cellulaire des embryons de l’Université de Portland (Oregon, USA), qui avait créé pour la première fois des cellules souches à partir de cellules adultes humaines, en 2014.

Cette fois, les chercheurs américains rendent compte d'une étude, également publiée le même 2 août 2017 dans Nature sous le titre "Correction of pathogenic gene in human embryos", et dans laquelle ils ont réussi avec succès à corriger chez des embryons humain une mutation porteuse d'une maladie héréditaire grâce à la technique maintenant célèbre de CRISPR-Cas9. Cet outil à tout faire du génie génétique est capable de façonner l'ADN des bactéries, mais également aujourd’hui de tous les fœtus des organismes eucaryotes, et donc ceux des humains.

La méthode de modification du génome est à la fois ciblée, viable, avec une réussite proche de 100% dans le traitement des maladies héréditaires.

L’exemple abordé par les auteurs est celui de la cardiomyopathie hypertrophique, une maladie génétique à l’origine d’une hypertrophie du cœur. Cell-là entraine des troubles cardiaques à l’origine de syndromes de mort subite. Lorsque l’un des deux parents est porteur du gène pathogène, l’enfant à une chance sur deux d’être atteint et une chance sur deux d’échapper à la maladie.

La première solution consiste à trier les embryons par analyse génétique, après une fécondation in vitro (FIV), et de ne garder que ceux non porteurs de la maladie. Cela entraine de fait une sélection de la moitié du matériel disponible. La seconde solution menée à bien par l’équipe de Portland est de recourir au CRISPR-Cas9 et de modifier le génome afin de le nettoyer du gène pathogène.

Les chercheurs ont injecté le CRISPR-Cas9 en même temps que le spermatozoïde lors de la métaphase II (un cycle déterminé) de l'ovocyte. La technique a permis de réparer l’ADN et ainsi obtenir des gènes corrigés sans que le reste du génome n'ait été modifié, et en préservant la viabilité des embryons.

Au delà des espoirs apporté par la méthode pour le traitement des maladies génétiques, le problème reste celui de l’éthique dans l’utilisation clinique de leur méthode, et les risques liés à une modification de lignées germinales. Le recours à de telles méthodes en médecine vétérinaire ou en dehors des cadres de la clinique, pour modifier le génome de fœtus viables, ouvre la perspective vertigineuse des modifications ouvertes à tous les fous de la planète.

Cette fois, les chercheurs américains rendent compte d'une étude, également publiée le même 2 août 2017 dans Nature sous le titre "Correction of pathogenic gene in human embryos", et dans laquelle ils ont réussi avec succès à corriger chez des embryons humain une mutation porteuse d'une maladie héréditaire grâce à la technique maintenant célèbre de CRISPR-Cas9. Cet outil à tout faire du génie génétique est capable de façonner l'ADN des bactéries, mais également aujourd’hui de tous les fœtus des organismes eucaryotes, et donc ceux des humains.

La méthode de modification du génome est à la fois ciblée, viable, avec une réussite proche de 100% dans le traitement des maladies héréditaires.

L’exemple abordé par les auteurs est celui de la cardiomyopathie hypertrophique, une maladie génétique à l’origine d’une hypertrophie du cœur. Cell-là entraine des troubles cardiaques à l’origine de syndromes de mort subite. Lorsque l’un des deux parents est porteur du gène pathogène, l’enfant à une chance sur deux d’être atteint et une chance sur deux d’échapper à la maladie.

La première solution consiste à trier les embryons par analyse génétique, après une fécondation in vitro (FIV), et de ne garder que ceux non porteurs de la maladie. Cela entraine de fait une sélection de la moitié du matériel disponible. La seconde solution menée à bien par l’équipe de Portland est de recourir au CRISPR-Cas9 et de modifier le génome afin de le nettoyer du gène pathogène.

Les chercheurs ont injecté le CRISPR-Cas9 en même temps que le spermatozoïde lors de la métaphase II (un cycle déterminé) de l'ovocyte. La technique a permis de réparer l’ADN et ainsi obtenir des gènes corrigés sans que le reste du génome n'ait été modifié, et en préservant la viabilité des embryons.

Au delà des espoirs apporté par la méthode pour le traitement des maladies génétiques, le problème reste celui de l’éthique dans l’utilisation clinique de leur méthode, et les risques liés à une modification de lignées germinales. Le recours à de telles méthodes en médecine vétérinaire ou en dehors des cadres de la clinique, pour modifier le génome de fœtus viables, ouvre la perspective vertigineuse des modifications ouvertes à tous les fous de la planète.

Pays/territoire :

Portland, Oregon, États-Unis

IA : Les exosquelette ; on a le choix.

Le développement des exosquelettes est un des points centraux de la robotique collaborative. Un exosquelette est un dispositif cobotique actif. Il permet de développer une aide motrice ou sensori-motrice et amplifier l’effort de son utilisateur. Celui-là peut être un manutentionnaire, un soldat, un opérateur dans un atelier, sur une chaîne de montage, dans un chantier de BTP, ou une personne en fragilité ou en rééducation clinique de mobilité ou d'équilibre, voire une personne âgée qui peut, grâce à cette aide, recouvrer des fonctions perdues ou diminuées. Plusieurs sociétés proposent des exosquelettes, avec des philosophies conceptuelles et d'usage souvent différentes et parfois complémentaires.

Superflex est un prototype développé par un groupe de chercheurs de SRI International, l'ancien Stanford Research Institute. Il est conçu pour faciliter la marche des soldats et les déplacements des personnes âgées. Il s’agit d'une combinaison souple, équipée de capteurs et d'un système d'intelligence artificielle. Il s’adapte à la démarche de son utilisateur, apprend ses caractéristiques et permet d’apporter une force supplémentaire ou une meilleure précision au moment où l’utilisateur en a besoin. Cela se fait indépendamment de sa volonté, de manière totalement transparente. Une telle combinaison militaire et industrielle permettrait également aux personne à la mobilité réduite de gravir des escaliers, et aux opérateur d’éviter les troubles musculo-squelettiques (TMS) tout en favorisant le maintien de l'équilibre et la sécurité des personnes.

Exosuit est une solution développée par l’Institut Wyss de l’Universite de Harvard et financé par le DARPA (Defense Advanced Research Projects Agency) dans le cadre du programme Warrior-Web. Ce prototype souple permet aux militaires d’augmenter la distance parcourue avec une charge lourde. Il est composé de tissu souples, d’actionneurs et de capteurs qui en font une sorte de pantalon intelligent qui s’inspire des muscles et tendons des jambes de l’appareil locomoteur humain. L’appareil est maintenu par des sangles et peut donc être rapidement installé ou retiré en fonction des tâches à effectuer. Parallèlement, la DARPA finance XOS2 de l’entreprise Raytheon Sarcos pour un déploiement opérationnel prochain dans les unités combattantes. Un autre projet, Talos (Tactical Assault Light Operator Suit), associe un exosquelette à une armure intégrale de protection antibalistique.

Phoenix est proposé par SuitX, une spin-off développée par des anciens de l’Université de Californie à Berkeley. Il s’agit d’un dispositif léger et peu onéreux, prévu pour permettre aux paraplégiques de remarcher avec une autonomie de quatre heures. Le dispositif est modulable et peut s’adapter aux caractéristiques physiques de la personne, à celles de son handicap, et à ses préférences de vitesse ou de démarche aidée par des béquilles.

La France s’intéresse également au domaine avec plusieurs projets.

ExoPush est ainsi un exosquelette, proposé par la start-up RB3D, prévu pour l’aide aux opérateurs qui tirent des outils, tels que des râteaux pour le ramassage de feuilles, pour étaler le béton ou le ciment sur un chantier ou le bitume sur les routes. Exoback de RB3D est un exosquelette dédié, quant à lui, aux militaires pour les charges dorsales. ExoUp en est une déclinaison civile pour les manutentionnaires. Hercule, développé avec le soutien de la DGA (Direction Générale de l’Armement), entre quant à lui dans le programme « soldat du futur » et ambitionne doter l’armée française en théâtre d’operations.

Plus spécialisée, la ceinture Atlas est développée par la start-up française Japet. Il s’agit d’un système permettant aux personnes atteintes de sciatiques chroniques de recouvrer leurs activités socio-professionnelles. La ceinture robotisée est dotée de quatre vérins, dont l’asservissement est coordonné par une carte Arduino, qui diminuent la pression sur les disques intervertébraux par une décompression de la colonne vertébrale. Le gant de rééducation Exoglove a quant à lui été développé par des élèves ingénieurs du Polytech Marseille. Il s’agit d’un dispositif de rééducation de la main pour le traitement des déficiences motrices ou des développement des projets industriels.

Quant au géant technologique japonais Panasonic, il mise sur une évolution incrémentale des exosquelettes avec une large gamme de modèles. Du petit AWN-03 à l’impressionnant Power Loader, en passant par le modèle Ninja, la firme nippone offre une grande variété adaptée aux différentes forces nécessaires. Sincere Kourien est une filiale de Panasonic, spécialisée dans l’aide à la personne, et commercialise des adaptations des modèles de Panasonic pour chacun, dans sa vie de tous les jours. Mais le groupe asiatique a désormais un nouveau concurrent avec le groupe automobile sud-coréen Hyundai qui développe un nouveau prototype

d’exosquelette inspiré d’Iron Man. Son modèle H-LEX et son programme Next Mobility ambitionnent de devenir les éléments de base du futur de la mobilité avec les mêmes ambitions que celles de son concurrent, de l’autre côté de la Mer du Japon. Et les asiatiques ne sont pas les seuls sur le terrain de la concurrence. Ekso Bionics, BMW, Audi ou de nombreux groupes associés à des universités se sont lancés dans la course.

Bref. La guerre des exosquelettes ne fait que commencer.

Libellés :

handicap,

homme augmenté,

ia,

innovation,

robot,

technologie

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

02 août 2017

BIO - TECH : Mercredi noir pour le Monde.

Alors que le ministre français de l'environnement (ministre de la transition écologique et solidaire) appelle, dans une tribune publiée ce mercredi 2 août 2017 sur le site du Journal Le Monde, les citoyens à un "sursaut" pour la planète, l'humanité a franchit, sans réellement s'en préoccuper, le "Jour du dépassement".

Alors que le ministre français de l'environnement (ministre de la transition écologique et solidaire) appelle, dans une tribune publiée ce mercredi 2 août 2017 sur le site du Journal Le Monde, les citoyens à un "sursaut" pour la planète, l'humanité a franchit, sans réellement s'en préoccuper, le "Jour du dépassement".

C'est à partir de cette date que l'ONG Global Footprint Network (Oakland, Californie, USA) a déterminé que l'humanité vit "à crédit" en ce qui concerne les ressources de la Terre.

Le "jour du dépassement de la Terre" est chaque année calculé sur la base de quelque 15000 paramètres économiques et environnementaux fournies par les Nations Unies. Ainsi, la comparaison entre empreinte écologique de l’homme, exploitation des ressources naturelles, biocapacité de la Terre à absorber les gaz à effet de serre et reconstituer les ressources dépensées, montre aujourd'hui une dette cumulative de plus de 70% par an. Et celle dette augmente tous les ans selon une logique exponentielle.

Le jour du dépassement de la Terre intervient donc tous les ans de plus en plus tôt.

Les causes sont notamment celles d'une incohérence des constantes de temps. Le temps économique est de plus en plus bref, appelé en cela à la performance par les gestionnaires, manageurs, commerçants et autres apôtres de la performance marchande. C'est oublier que les temps biologiques, géologiques et écologiques restent les mêmes, immensément longs, sans réelle possibilité de comparaison.

L'homme coupe ainsi les arbres à un rythme nettement plus élevé que celui de leur croissance, que l'on ne sait pas biologiquement accélérer. Il prélève plus de poisson qu'il ne peut s'en reproduire naturellement et qu'on ne sait en élever de manière compensatoire. Il rejette d'avantage de carbone que les forêts et océans ne peuvent en absorber, sans aucune solution connue ou pouvant être raisonnablement mise en œuvre, et ainsi de suite.

Aujourd'hui, il faudrait 1,7 Terre par an pour répondre aux besoins économiques de l'humanité et aux ambitions toujours plus élevées des compagnies maritimes, aériennes, ferroviaire , automobiles, à ceux de leurs usagers, aux ambitions économiques des firmes industrielles, bancaires, commerciales et de communication, et aux besoins de consommateurs de plus en plus exigeants qui ne voient pas pourquoi, eux, devraient se priver face au luxe toujours plus insensé de la vie des riches de plus en plus riches.

Les conséquences de cette situation de surconsommation effrénée sont, pèle mêle selon l'ONG, une crise de l'eau avec l'acidification des océans et la pénuries en eau potable, une crise de la terre avec l'érosion des sols et l'accumulation des déchets,

une crise du vivant avec la déforestation et le déclin de la biodiversité, une crise de l'atmosphère avec l'élévation de la concentration de CO2 et le phénomène le Niño, etc.

Face à cette catastrophe annoncée dans l'indifférence générale, les réfugiés se pressent aux portes des nations et grandes puissances qui s'arment et perfectionnent leurs moyens de sécurité, de défense, mais aussi de conquête des territoires, espaces maritimes et autes lieux terrestres de ressources résiduelles. La course à l'armement accompagne celle de la conquête spatiale ; il faudra bien chercher des ressources ailleurs ... ou s'en aller.

Dans ce paysage noir, la technologie devient première et, phénomène nouveau, s'impose à l'économie alors qu'elle lui était jusqu'ici secondaire. Selon le ministre, "la transition écologique est en train de faire ses preuves" avec des énergies renouvelables de moins en moins chères et leur production de plus en plus performante, vers "un avenir sans énergies fossiles". Le monde du transport va "tripler l’offre de véhicules électriques d’ici à 2020". La biodiversité est aujourd'hui protégée par la Loi "et l’agriculture biologique décolle".

Si, selon le ministre, "de nouveaux choix de société sont en train de naître", accompagnés d'une prise de conscience nécessitant et menant à "une détermination politique" sans concession, c'est au niveau international que le problème se pose de manière critique, avec des grandes puissances qui ne jouent pas et ne joueront probablement pas, on le sait aujourd'hui, le jeu de la solidarité, et des peuples en devenir qui ne comprendraient pas qu'on leur interdise ce que l'occident s'est autorisé lui-même depuis des siècles en menant l'humanité dans cet impasse. Il faudra bien en sortir ... par la mort et ce n'est pas gai pour le futur de l'humanité, par la décroissance et c'est un combat perdu d'avance sauf pour quelques illuminés du retour à la campagne, ou par la science et la technologie, et il serait temps, Mister M, d'y "mettre le paquet!".

Libellés :

bio,

complexité,

économie,

futur,

info générale,

polémique,

technologie

Pays/territoire :

64490 Etsaut, France

01 août 2017

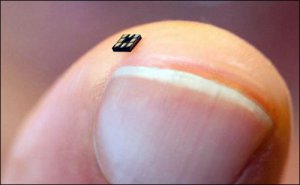

IA - TECH : Smart Dust, la poussière intelligente en réseaux pervasifs

La "poussière intelligente" (ou "smart bust"), parfois désignée au pluriel "poussières intelligentes" pour en surligner la diversité technologique, est un nom générique pour des systèmes qui combinent des éléments nanotechnologiques ou biotechnologiques, des systèmes énergétiques et de communication. Elle est constiuée de micro systèmes autonomes ou télécommandés, qui seront progressivement placés dans l'environnement, espaces publics et privés, externes comme internes, pour le meilleur et pour le pire.

Ces systèmes seront utilisés pour la surveillance et la gestion des risques, qu'ils soient (i) biologiques pour les malades ou des personnes saines tels que sportifs, enfants ou personnes âgées, enfants, etc., (ii) de l'habitat ou des véhicules pour la température, l'humidité, les intrusions ou les chocs ..., ou (iii) géologiques et environnementaux pour les activités sismologiques, les marées et intempéries, le contrôle des incendies et des pollutions, etc. et permettront de surveiller et remonter des informations pour déclencher des régulations ou provoquer des interventions. Plus intéressant, les chercheurs travaillent à doter ces micro-capteurs de capacités locales de calcul, de mémoire et de facilités de communication autonomes et auto-alimentés par la captation du mouvement, celle de fréquences radioélectriques ou de champs magnétiques.

Issus des premiers travaux de la DARPA (Defense Advanced Research Projects Agency) des années 1990, la poussière intelligente s'apparente à un ensemble de capteurs sensoriels ou grains d'échelle nanométrique reliés entre-eux dans un réseau auto-organisé en symbiose avec l'environnement, permettant de le quantifier en temps réel. Comme ces réseaux de capteurs sont composés de MEMS (microelectromechanical systems) micro- et nano-électromécaniques, aujourd'hui de la taille d'un grain sable et bientôt complètement invisible à l’œil nu, leur utilisation pourrait être généralisée pour permettre l'élaboration de systèmes informationnels denses et largement étendus, ultra précis et multi-spécialisés, sans être perceptibles et donc sans influencer les comportements des humains étudiés ou en interraction avec le milieu.

De tels micro-capteurs intelligents de demain sont développés par plusieurs laboratoires et entreprises. Ainsi, l'université de Berkeley, Intel et plusieurs start-up de la Silicon Valley (Californie, USA) consacrent-ils leurs efforts pour de multiples applications.

L'équipe d'Intel et l'université de Berkeley ont mis au point un système d'exploitation de ces réseaux, TinyOS. Il s’agit d’un logiciel libre, d’origine universitaire et construit sur le même modèle Linux. Il peut donc être repris et amélioré par de nombreux laboratoires ou entreprises, ce qui accélère les recherches. Aujourd’hui, Il permet d’exécuter des applications n'ayant besoin que de 24 ko de mémoire, disposant de fonctions de communication sans fil, et étant capables d'analyser la pertinence des données recueillies, d’en faire le tri et de ne transmettre que les informations utiles.

Un programme de recherche financé par la DARPA prévoit que de telles poussières pourraient être dispersées par avion sur les champs de bataille, les lieux de conflits ou les zones à contrôler pour observer en permanence les déplacements des militaires adverses, des terroristes ou simplement des populations civiles. Des essais concluant ont déjà eu lieu, dans le cadre du programme militaire baptisé NEST (Network Embedded Systems Technology), sur des zones d’essai désertiques de la Californie, avec des résultats satisfaisant montrant la capacité d’auto-organisation en réseau de tels composants.

Plusieurs start-up californienne, telles que Crossbow Technology financée par Intel Capital pour accélérer le développement dual de tels microcapteurs intelligents et des applications civiles, ou Dust Inc., spin-off de de Berkeley pour développer la communications de milliers de MEMS, offrent déjà des applications diverses en dehors de la sphère militaire.

Des exemples sont étudiés pour que les poussières puissent être incorporés dans les brosse à dents pour détecter les problèmes dentaires ou valoriser les comportements de brossage satisfaisants des enfants, en permettant d’avoir à la fois une information sur les smartphones de des parents et d’informer directement le dentiste qui pourra anticiper ses rendez-vous et gérer ses stocks. Ce type de régulation trouve déjà sa place dans l'automobile haut de gamme où certains véhicules communiquent avec le service de maintenance de la marque.

Crossbow estime que la commercialisation de quelques capteurs de la génération actuelle, avec une carte électronique connectée à un PC, coûte une centaine de dollars, alors que le coût de la technologie CMOS pour la poussière intelligente du futur sera inférieur à 5 centimes par millimètre carré de dispersion de la poussière, et cela dans les très prochaines années.

A ce prix, on pourra noyer l’environnement sous les capteurs, et Digital Sun, une autre star-up de San Jose, va commercialiser en 2018 des nano-sondes agricoles pour renseigner en permanence sur l'état de sécheresse des sols et ainsi adapter l'irrigation ou l’arrosage automatique en augmentant la performance et en économisant l’eau.

Le marché le plus porteur reste néanmoins celui de la sécurité des biens et des personnes. On imagine des puces incorporées dès la fabrication ou placées sur les objets à protéger. On peut concevoir des badges de clients ou d’employés dotés de tels composants, avec des capteurs répartis dans les portes, les murs, plafonds ou planchers ou certains endroits stratégiques des zones ou bâtiments à surveiller. La gestion de stocks des entrepôts, le contrôle des bureaux, la surveillance des salles ou des chambres des hôpitaux ou des hôtels, des cellules des prisons, peuvent être dévolues à de tels systèmes.

La société Nox Defense propose des solutions basées sur le saupoudrage des sols par de la poussière d’identification (ID-Dust), sorte de fibres optiques nanométriques qui se collent aux semelles des intrus ou cambrioleurs sans qu’ils en aient connaissance, permettant de les retrouver et surtout de les suivre à la trace grâce à des applications cartographiques sur smartphones. Simply RFiD, la société mère de Nox Defense, rapporte que son système est déjà utilisé par certains services de renseignement contre le terrorisme, ou de sécurité des aéroports. Ces puces sont très bon marché, moins de 20 centimes l’unité, et reposent sur une technologie passive, c’est-à-dire sont indétectables par les dispositifs de contre-surveillance électronique.

Ainsi, des applications potentielles sont en train de voir le jour, avec un objectif de prévention médicale et de santé, de meilleure maitrise de l’environnement et des ressources, ou de sécurité permanente, dans des espaces pervasifs hyperconnectés. Un rapport d'EY(Ernst & Young) prévoit d’ailleurs que "nous serons bientôt équipés chacun de 10.000 micro-capteurs" et que "des milliers d'ordinateurs s'occuperont de nous, et nous ne serons plus en mesure d'intervenir directement sur chacun d'entre eux".

Libellés :

futur,

ia,

innovation,

nanotechnologies,

NBIC,

numérique,

technologie,

technologies portables

Pays/territoire :

Berkeley, Californie 94720, États-Unis

17 juillet 2017

IA : Musk à la manoeuvre contre l’Intelligence Artificielle.

Il y a déjà deux ans qu'Elon Musk (Tesla, SpaceX, SolarCity, Hyperloop, Open AI, Neuralink...) avait cosigné deux lettres ouvertes avec des scientifiques dont le physicien Stephen Hawking et l'informaticien Steve Wozniak, cofondateur d'Apple. Les signataires appelaient à une limitation de l'Intelligence Artificielle et de l'autonomie des machines, notamment en ce qui concerne les armes autonomes, drones et robots tueurs. Certaines personnalités telles Hawking ou Bill Gates (Microsoft) pensent que l'humanité peut largement bénéficier de formes constructives d'intelligence artificielle, tout en appelant à certaines précautions. L'IA pourrait ainsi être positive à condition qu'elle soit régulée.

Lors de la réunion estivale de la National Governors Association (association des gouverneurs des états nord américains), organisée le dernier week-end à Providence (Rhode Island, USA), Elon Musk a appelé à la prise de mesures concrètes et urgentes de sécurité face à, selon lui, la menace de l'IA. Il a ainsi réclamé aux gouverneurs des états américains la rédaction des textes de loi et leur application afin de réguler les usages mais également l'autonomie de l'IA.

Pour lui, nous sommes confrontés à une sorte de schizophrénie avec d'un côté d'immenses espoirs et de l'autre des dangers incommensurables. Il assure travailler lui-même sur des formes très avancées d'IA, et tire les sonnettes d'alarmes pour que chacun s'inquiète des progrès accomplis et à venir. Pour lui, la prise de conscience se fera lorsque "des robots tueront des personnes", mais trop tard et de manière non préparée. Les autorités et les citoyens ne sauront pas comment réagir. tellement ça leur paraitra irréel, a assuré Elon Musk.

Précautions nécessaires, l'industriel pense que les autorités doivent être proactives dans la régulation, au lieu d'être passives dans l'attente d'être réactives, car "le temps que nous réagissions, il sera trop tard".

Décrivant quelques scénarios concrets bien qu'aujourd'hui encore hypothétiques d'une intelligence artificielle qui abuserait les humains, par exemple en lançant de fausses informations tels que celles d'une attaque économique, nucléaire ou cyber, par imitation d'e-mails frauduleux et de communiqués de presse erronés etc., l'industriel a déclaré solennellement que "L'intelligence artificielle est un danger fondamental pour l'existence de la civilisation humaine" et même "le plus grand risque auquel notre civilisation sera confrontée", en estimant qu'il serait déjà "trop tard" pour sauver l'humanité si l'homme ne prend pas des mesures immédiate et très contraignante de régulation de l'IA.

Liens presse : ici et là.

Pays/territoire :

Los Angeles, Californie, États-Unis

14 juillet 2017

BIO : Génétiquement modifiés, les moustiques de Google à l'attaque du zika, de la dengue et du chikungunya

La MIT Review, organisme de publication du Massachusetts Institute of Technology, annonce (ici) que "Verily Robot", compagnie de la holding "Alphabet", maison mère de Google, vient de lâcher plus de 20 millions de moustiques génétiquement modifiés à Fresno (Californie, USA).

Le but est de libérer dans la nature des moustiques OGM mâles afin qu’ils s’accouplent aux femelles "Aedes aegypti" en empêchant les mâles "naturels" de ces femelles de les féconder. Avantage attendu, les oeufs ainsi produits n'éclosent pas et on bloque ainsi la reproduction des insectes vecteurs des maladies virales telles la fièvre jaune, la dengue, le chikungunya et le zika. A terme, la disparition de l'espèce des moustiques dangereux, faute de combattants, permet de prévenir les viroses toxiques pour l'homme.

L'opération, suivie de près par la Food and Drug Administration, a été réalisée ce 14 juillet 2017 par la société du groupe Google, confirmant ainsi le souhait du géant américain de se diversifier dans les initiatives de convergence (NBIC).

Un second projet est prévu en Australie pour la fin d'année.

Une date historique dans la toute récente histoire de la singularité.

Le but est de libérer dans la nature des moustiques OGM mâles afin qu’ils s’accouplent aux femelles "Aedes aegypti" en empêchant les mâles "naturels" de ces femelles de les féconder. Avantage attendu, les oeufs ainsi produits n'éclosent pas et on bloque ainsi la reproduction des insectes vecteurs des maladies virales telles la fièvre jaune, la dengue, le chikungunya et le zika. A terme, la disparition de l'espèce des moustiques dangereux, faute de combattants, permet de prévenir les viroses toxiques pour l'homme.

L'opération, suivie de près par la Food and Drug Administration, a été réalisée ce 14 juillet 2017 par la société du groupe Google, confirmant ainsi le souhait du géant américain de se diversifier dans les initiatives de convergence (NBIC).

Un second projet est prévu en Australie pour la fin d'année.

Une date historique dans la toute récente histoire de la singularité.

Pays/territoire :

Fresno, Californie, États-Unis

13 juillet 2017

IA - BIO : Nouvelle frontière - le codage informatique sur l'ADN d'une colonie de bactéries.

La revue Nature du 12 juillet 2017 rapporte (ici) la réalisation d'une nouvelle brique NBIC de la révolution de la singularité.

Des chercheurs de la faculté de médecine d’Harvard (Boston, Massachusetts) et du Wyss Institute de l’université Harvard (Cambridge, Massachusetts) ont rapporté avoir codé des informations digitales sous forme ADN dans une population de bactéries.

Ils ont, pour cela, utilisé le système Crispr-Cas9, véritable outil à "couper-coller" l'ADN afin d'y insérer une séquence souhaitée. Comme le système Crispr est caractérisé par la possibilité d'aligner de façon chronologique des séquences ADN étrangères, les scientifiques ont ainsi codé des informations digitalisées temporellement organisées.

Dans le cas présent, ils ont utilisé cinq images de la célèbre chronophotographie de Eadweard Muybridge, ayant servi en 1878 à montrer l'instant fugace durant lequel les sabots du cheval au galop quittent le sol. La conversion des données informatiques, suites de 0 et de 1, en code constitué des bases A, T, C et G de l'ADN, a permis de représenter à la fois la position, la couleur et le temps de chacun de tous les pixels du film. La construction des fragments d’ADN correspondants a permis de les introduire de manière redondante dans une population de bactéries E.coli, à raison d’une image par jour pendant cinq jours.

Il suffisait alors de récupérer l’information, en repassant de l’ADN aux pixels depuis le génome bactérien, par séquençage des régions d’intérêt, et de reconstituer l'ensemble à partir de la population bactérienne. Cela ne va pas de soi, et chaque bactérie n’intègrant qu'une partie des fragments, c'est donc bien la colonie bactérienne qui porte l'information totale (Ah!, ces merveilleuses bactéries !). Les chercheurs ont pour l'heure vérifié la robustesse de la méthode avec un succès de quelque 90% de l'information récupérée correctement.

L’intérêt potentiel de cette technique consiste à la fois à utiliser l’ADN comme moyen de stockage et à conserver la trace de l’expression de gènes tels que nécessaire à la différenciation cellulaire. Le plus important à nos yeux est le premier, preuve de cette nouvelle frontière de la convergence bio-numérique qui vient de tomber ; un premier pas, modeste et encore hésitant, vers le "Man-Machine Symbiosis" que prévoyait déjà les cybernéticiens des années 1950 et 60.

Libellés :

bio,

épistémologie,

futur,

hybridité,

ia,

NBIC,

numérique,

technologie

Pays/territoire :

A-111, 25 Shattuck St, Boston, MA 02115, États-Unis

15 mai 2017

IA : L'Intelligence Artificielle française est en deuil.

Le professeur Alain Colmerauer est décédé à l'âge de 76 ans.

Originaire de Carcassonne, il fit ses études à Grenoble, où il devint Ingénieur Ensimag puis docteur d'Etat. Sa thèse portait sur l'analyse syntaxique des langages de programmation.

Ne reculant pas devant la difficulté, il devint expert de traduction automatique de l'Anglais vers le Français (chose que certains ne peuvent pas raisonnablement concevoir, y compris pour une traduction naturelle) et inventa pour cela les systèmes-Q. C'est notamment à partir de ces travaux et d'autres, qu'il conduisit à Marseille sur le traitement informatique de la langue, qu'il développa avec son collègue Philippe Roussel, à partir de 1972, le langage de programmation Prolog.

Libellés :

culture,

ia,

info générale

Pays/territoire :

11000 Carcassonne, France

11 avril 2017

BIO-TECH : Mauvais temps pour les humains !!! Viva la robosphère !!!

Le mouvement poshumaniste considère que l'avenir de l'humanité ne peut pas se réaliser sous la forme actuelle des humains biologiques. Douze principaux risques de disparition de l'humanité, surpopulation, viroses catastrophiques, éruption de super volcans, collision avec un astéroïde, ou simple écroulement social mondial, ont d'ailleurs été inventoriés il y a deux ans dans le rapport du "Future of Humanité Institute" de l'Université d'Oxford.

Dans ce contexte, plusieurs pistes sont entrevues par les transhumanistes des Gafa, allant de la modification génétique à la fuite vers l'espace, ou la simple implémentation de l'esprit humain sur des robots ou dans un réseau cosmique.

Selon un autre courant, il est probable que l'humanité disparaisse complètement en laissant sur Terre des machines qui pourrait survivre (si l'on peut dire) à l'homme grâce à des capacités d'intelligence Artificielle incommensurables. C'est ce que postule par exemple l'astrophysicien Martin Rees dont on connait l'excellente présentation TED suite à la publication en 2004 de son ouvrage "Our final hour".

Pour Rees, et dans le ton des craintes de Stephen Hawking qui prédit la fin prochaine de l'homme par l'intelligence artificielle, ce seront les robots qui supplanteront l'homme. Cette annonce faite au dernier festival de science de Cheltenham en Angleterre, repose sur la conviction que l'existence des hommes sur Terre ne représentera qu'une toute petite phase de l'histoire de la Terre. Pour lui, alors qu'il a fallu quatre milliards d'années pour passer des premiers protozoaires à l'homme, il y a autant de différence entre l'intelligence de ces unicellulaire et la notre qu'il y en aura entre la notre et celle des éléments intelligents qui nous pourraient nous survivre dans quelques millénaires. Mais pour lui, cette survie sera technologique, c'est-à-dire que des formes artificielles d'intelligence seront développées sur des entités fabriquées par cette propre intelligence. Celle-ci pourrait même être dématérialisée, comme des « entités électroniques » qui remplaceront les formes de vie organique qui les ont conçues à la base. L'humanité restera alors un souvenir pour des machines qui auront pris le dessus et auront, elles, des milliards d'années devant elles...

Libellés :

épistémologie,

futur,

NBIC,

polémique

Pays/territoire :

109-111 Bath Rd, Cheltenham GL53 7LS, Royaume-Uni

IA - SHS : La Réalité Virtuelle s'invite dans les sciences du comportement à Berkeley.

L'Université de Stanford avait déjà son "Virtual Human Interaction Lab." (VHIL). L’université de Berkeley ouvre son laboratoire dédié à la recherche sur la réalité virtuelle (RV) au sein de son "Centre pour la Cognition Augmentée" (CAC).

Le but est d'évaluer l'impact psychologique et comportemental de la RV sur l’être humain. Le "UC Berkeley Immerex Virtual Reality Lab." est organisé en joint venture entre l'université et une société de Santa Clara (Californie, USA), Immerex. Celle-là propose des lunettes de RV couvrantes et légères, ce qui est original par rapport aux autres solutions qui correspondent généralement à des casques classiques (lien).

Libellés :

homme augmenté,

ia,

interfaces,

réalité virtuelle,

shs,

simulation,

technologies portables

Pays/territoire :

253 Cory Hall, Berkeley, CA 94720, États-Unis

09 avril 2017

IA : L'Avenir selon IBM avec le "cognitive compting" pour augmenter notre connaissance du Monde.

IBM Research a publié la version 2017 de son « IBM 5 in 5 » innovations list, et explore comment le "cognitive computing" va augmenter notre connaissance du Monde.

Ainsi, pour IBM, l’intelligence artificielle et les nanotechnologies sont au cœur des innovations des cinq prochaines années. Les cinq innovations qui changeront nos vies sont les suivantes (ici) :

L’intelligence artificielle et la santé mentale. D'ici cinq ans, ce que nous dirons et écrirons sera analysés par de nouveaux systèmes cognitif, et pourra être utilisé comme indicateurs de notre santé mentale et de notre bien-être physique, et détecteurs de risque de maladies mentales et neurologiques pour mieux prédire, contrôler et suivre ces maladies. Les techniques de machine learning à partir de transcriptions et d'enregistrement d'entretiens psychiatriques permettent de trouver des schémas prédictifs de psychose, schizophrénie, obsession ou dépression. Aujourd’hui, 300 mots environ suffisent à aider les cliniciens à prédire la probabilité de trouble mental.

L’hyperimagerie augmentée par intelligence artificielle. De nouveaux dispositifs d'imagerie utilisant la technologie d'hyperimagerie et l'intelligence artificielle vont permettre de voir largement au-delà du domaine de la lumière visible, en combinant de multiples bandes du spectre électromagnétique pour révéler des informations utiles ou des dangers potentiels qui seraient cachés. Ces appareils vont devenir portables, financièrement abordables et accessibles à tous. L'hyperimage d’un médicament pharmaceutique, d’un chèque bancaire, ou autre, pourront par exemple nous dire ce qui est frauduleux et ce qui ne l’est pas, avec une nouvelle gamme du perceptible par l’humain là où il est aujourd'hui aveugle.

La compréhension de la complexité de la Terre. Dans cinq ans, nous maîtriserons des algorithmes de machine learning et des logiciels de traitement des informations issues milliards d’appareils contribuant à un « macroscope », système de logiciels et d’algorithmes qui permet de rassembler toutes les données complexes de la Terre pour analyser leur signification. En agrégeant, organisant et analysant ces données, sur le climat, les conditions du sol, les niveaux d’eau, les pratiques d’irrigation ou de culture, les agriculteurs bénéficieront d’informations clés qui les aideront à faire les bons choix de culture, de parcelles les meilleures pour planter tel ou tel végétal, de pratiques à adopter pour obtenir des rendements optimaux, tout en maîtrisant les réserves d’eau. De telles études sont déjà mises en oeuvre à la Gallo Winery, en Californie.

Des laboratoires médicaux « sur puce ». Les détectives nanotechnologiques de santé, capables d'identifier des indices invisibles dans nos différents fluides corporels, informeront immédiatement par réseau le médecin. Une seule puce de silicium comportera tous les processus nécessaires pour analyser les données biologiques, en ligne et de manière permanente, sans recours au laboratoire d'analyse que nous connaissons actuellement. Aujourd'hui, on sait déjà séparer et isoler les bioparticules d’un diamètre allant jusqu’à 20 nanomètres. Cette échelle donne accès à l’ADN, à des virus, à des exosomes. Ces particules pourront être analysées pour révéler la présence d’une maladie bien avant que n'en apparaissant es symptômes, permettant une véritable médecine prédictive adaptée à chacun.

Des capteurs détecteurs de pollution. Dans cinq ans, de nouvelles technologies de détection informeront à la vitesse de la lumière des données de capteurs déployées près des puits d'extraction de gaz, autour d'installations de stockage et le long des réseaux de pipelines et de distribution. L'industrie pourra localiser les fuites invisibles en temps réel et à des prix maîtrisés. Des réseaux de capteurs IoT connectés sans fil au Cloud assureront aussi le suivi continu au domicile, dans l'usine ou même dans les véhicules et drones, permettant ainsi de détecter instantanément les problèmes, de réduire la pollution et la survenue d'événements catastrophiques. Ces puces photoniques pourront être intégrées dans les sols, les infrastructures, les matériaux des véhicules et vêtements, générant des données qui, combinées à des données satellitaires et à d'autres sources historiques, peuvent être utilisées pour construire des modèles environnementaux complexes.

Voir le rapport IBM (ici).

Libellés :

futur,

homme augmenté,

ia,

info générale,

innovation,

NBIC,

numérique

Pays/territoire :

1 New Orchard Rd, Armonk, NY 10504, États-Unis

31 mars 2017

IA - SHS : Cybercriminalité - la santé attaquée - la protection cognitive à l'ordre du jour.

L'indice IBM X-Force Threat Intelligence est un indicateur d'observation de la cybercriminalité, publié chaque année par l'entité sécurité d’IBM.

Il est composé d'observations internes, issues de la surveillances de 8000 clients répartis dans 100 pays, et de données externes tels que des capteurs de spam, hameçonnage, honeynets et autres dispositifs malwares, grâce à des réseaux-pièges et à la surveillance de plus 37 milliards de pages Web, d'images et mails frauduleux.

IBM a publié son rapport le 30 mars 2017, et constate que le nombre de données compromises est passé de 600 millions 2015 à plus de 4 milliards en 2016, soit une augmentation de 566% pour la seule année dernière.

L'évolution concerne évidement les cartes de crédit, les mots de passe et les renseignements personnels, mais l'explosion concerne aujourd'hui n-beaucioup plus les données médicales personnelles.

De même, IBM a constaté un changement de stratégie des cyber-déliquants. Ainsi, ceux-là s'attaquent plus aux données non structurées, telles que les archives d’emails, les documents commerciaux et de propriété intellectuelle, et le code source.

Un troisième constat d'évolution qualitative concerne l'intention de ransomware qui a fait corrélativement augmenter le nombre de spams de près de 400%. En effet, la principale méthode utilisée pour le ransomware utilise les pièces jointes malveillantes dans les courriers indésirables.

Face à cette menace et ce danger, l'économie a elle-même évolué. IBM signale que 70 % des entreprises touchées par le ransomware payent plus de 10 000 $ pour récupérer l’accès aux données et aux systèmes. Le FBI a estimé que, pour les trois premiers mois de 2016 aux USA, les cybercriminels ont perçu en rançon près de 210 millions de dollars, ce qui permet une estimation d’un milliard de dollars sur l’année 2016. Le ransomware représente ainsi 85 % des attaques.

La santé et les services financiers sont les secteurs les plus atteints. Ainsi, l’industrie de la santé a été assaillie par un très grand nombre d’incidents, avec une concentration sur les des cibles plus petites, ce qui entraîne un nombre plus faible de fuites de données mais déstabilise beaucoup plus le système global, les petites structures étant moins bien protégées et culturellement préparées.

Le rôle de la prévention et de la protection cognitive semble de plus en plus évident. En moyenne les clients suivis par IBM ont enregistré plus de 54 millions d’événements de sécurité en 2016, soit seulement 3 % de plus qu'en 2015, avec une baisse de 12 % des attaques d’une année à l’autre. Ces résultats semblent liés à l'évolution des systèmes de sécurité qui s'améliorent et surtout, d'après IBM, à de nouvelles innovations, comme les systèmes cognitifs.

Accès au rapport IBM X-Force (ici).

Voir le communiqué d'IBM (ici).

Libellés :

entreprise,

ia,

NTIC,

numérique,

santé,

technologie

Pays/territoire :

294 Route 100, Somers, NY 10589, États-Unis

30 mars 2017

DIV : Les élèves de ENSC distingués par le prix du jury "Vie Professionnelle" de TousHanScène 2016-17

Le Concours Vidéos Handicap Étudiants "Tous HanScène" a pour objectif d'encourager les jeunes en situation de handicap à accéder aux études supérieures et d'inciter les établissements d'enseignement supérieur à s'ouvrir davantage à ces jeunes pour leur permettre de réussir leurs études et s'insérer dans la société en minimisant les conséquences de leur handicap.

Il est dramatique de constater que dans notre pays, seuls 7% des jeunes scolarisés en situation de handicap accèdent aux études supérieures et parmi eux, seulement 1% atteint le niveau bac+5 !!!

Partant de ce constat, "Tous HanScène" s'inscrit dans trois grands enjeux nationaux : (1) inciter plus de collégiens et lycéens en situation de handicap à prolonger leurs études dans l'enseignement supérieur, (2) amplifier l'ouverture des cursus des établissements de l'enseignement supérieur aux jeunes en situation de handicap, et (3) permettre aux entreprises de recruter des personnes handicapées avec des niveaux d'études supérieurs.

C'est dans cette philosophie active que "Tous HanScène", soutenu par des grandes entreprises et organes de presse nationaux, organise un concours vidéo dont les meilleures réalisations sont saluées par une série de prix : le prix du public va à la vidéo la plus vue, et des prix du jury distinguent les vidéos dans les catégories "Arts et essais, Humour, Sport, Vie étudiante, Vie professionnelle, Vie quotidienne". Un "coup de coeur" ainsi que des pris "Jeune Pousse" pour les lycées et "Mobilisation Etablissement" pour les universités sont d'ailleurs accompagnés d'une subvention pour financer la mise en place d'un projet handicap.

Les vidéos du concours 2016-2017 (saison 5) sont disponible en ligne (ici).

L'ENSC travaille depuis longtemps à la question de la facilitation de la vie des personne en situation de handicap. Véronique Lespinet, en charge du domaine Santé-Handicap, a coordonné cette année la production des élèves de l'école qui viennent d'être récompensés, lors de la cérémonie officielle du 30 mars 2017, par le prix du jury "Vie professionnelle".

Un grand bravo à tous ceux qui se sont associés à cette entreprise.

Libellés :

ENSC,

handicap,

info générale,

ressource pédagogique

Pays/territoire :

109 Avenue Roul, 33400 Talence, France

18 mars 2017

IA - SHS : Des robots tueurs ... des cols bleus.