Dans la suite des deux récentes chroniques (1) et (2), la question de la réutilisation des données publiques est posée par Internet Actu.

sic : Alors que le 6 décembre 2011 devrait enfin ouvrir EtaLab, le portail de données publiques de l'Etat français (plus de 2 ans après l'initiative américaine Data.gov), nous vous proposons de faire un rapide point sur "l'open data", ce mouvement d'ouverture des données publiques, qui vise à rendre accessible, dans un format lisible tant par les humains que les machines, des ensembles de données publiques. A quoi cela sert-il ? Qui cela sert-il ?A l'heure où de nombreuses collectivités territoriales françaises ont commencé à développer des portails d'informations et à libérer des jeux de données, il est tant de revenir sur les enjeux de la réutilisation des données publiques tant pour l'action publique que pour le simple citoyen.

Cognitique / Cognitics - Ce site est destiné aux élèves ingénieurs et aux doctorants de l'École Nationale Supérieure de Cognitique (ENSC Bordeaux-INP). Il donne en complément des enseignements des pistes de documentation et de débat selon les thèmes SHS, IA, BIO, TECH, culture, infos générales et vie de l'ENSC. Il prépare notamment aux épreuves du grand oral de fin d’études.

02 décembre 2011

IA - SHS : Données publiques - suite ...

28 novembre 2011

BIO : L'EEG repousse les limites de l'état végétatif.

C'est la question qui hante les cliniciens et les proches des patients comateux : existe-t-il une conscience ches les patients plongés dans des états végétatifs chroniques (EVC) ?

Campons le tableau. Un sujet est alité, immobile, sans mouvement volontaire, sans réponse aux stimulations extérieures. Peut-il nous entendre, peut-il penser alors que toute communication vers l'extérieur lui est impossible ? Cette absence totale de réponse volontaire et reproductible au Monde est-elle le signe d'une absence de vie intérieure cognitive et affective ?

La neurologie l'affirmait jusqu'ici. Mais le 3 février 2010, une équipe belge et britanique publiait sur le site du New England Journal of Medicine, une recherche montrant que, parmi 21 patients en EVC, l’IRM fonctionnelle avait mis en évidence chez 4 d'entre eux une activité cérébrale structurée. Il y avait donc une conscience élaborée en dehors de tout signe extérieur, et la pensée est dissociée de la capacité comportementale. Cette découverte remettait alors en cause la définition clinique des états végétatifs chroniques et posait la question de l'attitude clinique et legale (definition de la mort) en preconisant la recherche systématique d’un tel état de conscience chez les sujets en EVC.

Cependant, tant pour des raisons économiques que d'accès aux dispositifs de détection, et que pour des raisons d'incomatibilité clinique (métal intra corporel par exemple), il est difficile de tester en IRM fonctionnelle tous ces patients. La même équipe vient de décrire dans le Lancet du 10 novembre 2011 une nouvelle méthode ambulatoire basée sur l'EEG (électro-encéphalographie) de détection d’une réponse cérébrale adaptée et hors motricité à des commandes verbales simples.

Les auteurs ont proposé à 16 patients en EVC (contre 12 témoins sains) un protocole demandant de répondre à des ordres simples tels que bouger la main et un orteil. Dans 3 cas et alors que le dossières l'examen cliniques ne permettaient pas de différencier les patients ou de prévoir des états de conscience, les sujets ont pu produire des répondes EEG différentiées.

Outre la confirmation des résultats IRMf par l'EEG, l'etude permet d'envisager de tester facilement tous les patients et ainsi de modifier la prise en charge des patients "conscients" et surtout d'envisager des dispositifs électroniques permettant d'établir une communication avec çes patients, en court-circuitant la motricité volontaire.

Voilà probablement du travail pour les cogniticiens et les spécialistes de l'IMS.

La question reste de savoir comment aborder le cas des patients qui ne seront pas positifs au test, car rien ne on permet de penser qu'ils ne sont pas conscients, comme rien ne nous le permettait il y a quelques temps à propos des patients concernés par cette étude, et que pourtant la neurologie considéraient comme en état désespéré. La technologie électronique ne permet que de repousser la frontière clinique, elle ne modifie pas la réalité de l'emmurement? Mais elle permet d'augmenter l'homme contraint, au delà de son incapacité comportementale "totale".

Cruse, D, et la. (2011) Bedside detection of awareness in the vegetative state : a cohort study. Lancet, mise en ligne le 10 novembre 2011 (DOI:10.1016/S0140-6736(11)61224-5).

Campons le tableau. Un sujet est alité, immobile, sans mouvement volontaire, sans réponse aux stimulations extérieures. Peut-il nous entendre, peut-il penser alors que toute communication vers l'extérieur lui est impossible ? Cette absence totale de réponse volontaire et reproductible au Monde est-elle le signe d'une absence de vie intérieure cognitive et affective ?

La neurologie l'affirmait jusqu'ici. Mais le 3 février 2010, une équipe belge et britanique publiait sur le site du New England Journal of Medicine, une recherche montrant que, parmi 21 patients en EVC, l’IRM fonctionnelle avait mis en évidence chez 4 d'entre eux une activité cérébrale structurée. Il y avait donc une conscience élaborée en dehors de tout signe extérieur, et la pensée est dissociée de la capacité comportementale. Cette découverte remettait alors en cause la définition clinique des états végétatifs chroniques et posait la question de l'attitude clinique et legale (definition de la mort) en preconisant la recherche systématique d’un tel état de conscience chez les sujets en EVC.

Cependant, tant pour des raisons économiques que d'accès aux dispositifs de détection, et que pour des raisons d'incomatibilité clinique (métal intra corporel par exemple), il est difficile de tester en IRM fonctionnelle tous ces patients. La même équipe vient de décrire dans le Lancet du 10 novembre 2011 une nouvelle méthode ambulatoire basée sur l'EEG (électro-encéphalographie) de détection d’une réponse cérébrale adaptée et hors motricité à des commandes verbales simples.

Les auteurs ont proposé à 16 patients en EVC (contre 12 témoins sains) un protocole demandant de répondre à des ordres simples tels que bouger la main et un orteil. Dans 3 cas et alors que le dossières l'examen cliniques ne permettaient pas de différencier les patients ou de prévoir des états de conscience, les sujets ont pu produire des répondes EEG différentiées.

Outre la confirmation des résultats IRMf par l'EEG, l'etude permet d'envisager de tester facilement tous les patients et ainsi de modifier la prise en charge des patients "conscients" et surtout d'envisager des dispositifs électroniques permettant d'établir une communication avec çes patients, en court-circuitant la motricité volontaire.

Voilà probablement du travail pour les cogniticiens et les spécialistes de l'IMS.

La question reste de savoir comment aborder le cas des patients qui ne seront pas positifs au test, car rien ne on permet de penser qu'ils ne sont pas conscients, comme rien ne nous le permettait il y a quelques temps à propos des patients concernés par cette étude, et que pourtant la neurologie considéraient comme en état désespéré. La technologie électronique ne permet que de repousser la frontière clinique, elle ne modifie pas la réalité de l'emmurement? Mais elle permet d'augmenter l'homme contraint, au delà de son incapacité comportementale "totale".

Cruse, D, et la. (2011) Bedside detection of awareness in the vegetative state : a cohort study. Lancet, mise en ligne le 10 novembre 2011 (DOI:10.1016/S0140-6736(11)61224-5).

Libellés :

comportement,

éthique,

handicap,

homme augmenté,

santé

26 novembre 2011

BIO : Des cellules programmables pour de multiples fonctions.

Une équipe interdisciplinaire de biologistes, chimistes et informaticiens, travaille sur une solution permettant de créer des cellules re-programmables, à l'image du fonctionnement d'un ordinateur, afin de créer un système d'exploitation biologique. Ce projet est baptisé "Towards an Universal Biological Cell Operating System".

Le consortium associe l'Université de Nottingham (chef de file) et l'Université d'Edinburgh(UK), les Universités d'Etat d'Arizona, du Michigan, les Universités de Californie à Santa-Barbara et à San-Francisco, l'Université de New York, le Massachusetts Institute of Technology (USA), le Centro Nacional de Biotecnologia espagnol et l'Institut Weizmann pour la Science (Israël).

Ce projet de biologie synthétique associe les principes de la biologie avec des principes de l'ingénierie. Le but est de programmer des cellules bactériennes, qui seront capables d'exécuter ce programme. Autrement dit, il s'agit de créer un système d'exploitation pour des cellules biologiques.

Actuellement, lorsqu'on veut créer des organismes pour capturer per exemple du carbone relâche dans l'air suite à la combustion de pétrole, ou pour transformer l'arsenic polluant des rivières, ou pour des traitements synthétiques sur le corps humain, les biotechnologistes doivent sélectionner des souches et les transformer en fonction des buts à atteindre. Le projet vise à permettre de programmer, puis de reprogrammer des micro-organismes grâce à cet OS biologique (software), et ceci à partir d'une même souche de cellule utilisée comme hardware (par exemple la bactérie E. coli.

Inspirée du fonctionnement des systèmes d'exploitations des ordinateurs, qui sont capables d'assurer plusieurs fonctions sur le même matériel, les scientifiques envisagent, sur le même principe, de reprogrammer un groupe de cellules afin d'exécuter une action précise. Cette méthode pourrait permettre de créer de nouvelles entités vivantes qui n'existent pas dans la nature à ce jour, une nouvelle forme de vie à fonctionnement universel. Les perspectives sont envisagées dans la création de nouveaux médicaments adaptés aux besoins précis d'un patient particulier, de créer de nouvelles sources de nourriture ou d'énergie, de dépolluants, de capteurs de carbone ou de purificateurs d'eau alimentaire.

Le consortium associe l'Université de Nottingham (chef de file) et l'Université d'Edinburgh(UK), les Universités d'Etat d'Arizona, du Michigan, les Universités de Californie à Santa-Barbara et à San-Francisco, l'Université de New York, le Massachusetts Institute of Technology (USA), le Centro Nacional de Biotecnologia espagnol et l'Institut Weizmann pour la Science (Israël).

Ce projet de biologie synthétique associe les principes de la biologie avec des principes de l'ingénierie. Le but est de programmer des cellules bactériennes, qui seront capables d'exécuter ce programme. Autrement dit, il s'agit de créer un système d'exploitation pour des cellules biologiques.

Actuellement, lorsqu'on veut créer des organismes pour capturer per exemple du carbone relâche dans l'air suite à la combustion de pétrole, ou pour transformer l'arsenic polluant des rivières, ou pour des traitements synthétiques sur le corps humain, les biotechnologistes doivent sélectionner des souches et les transformer en fonction des buts à atteindre. Le projet vise à permettre de programmer, puis de reprogrammer des micro-organismes grâce à cet OS biologique (software), et ceci à partir d'une même souche de cellule utilisée comme hardware (par exemple la bactérie E. coli.

Inspirée du fonctionnement des systèmes d'exploitations des ordinateurs, qui sont capables d'assurer plusieurs fonctions sur le même matériel, les scientifiques envisagent, sur le même principe, de reprogrammer un groupe de cellules afin d'exécuter une action précise. Cette méthode pourrait permettre de créer de nouvelles entités vivantes qui n'existent pas dans la nature à ce jour, une nouvelle forme de vie à fonctionnement universel. Les perspectives sont envisagées dans la création de nouveaux médicaments adaptés aux besoins précis d'un patient particulier, de créer de nouvelles sources de nourriture ou d'énergie, de dépolluants, de capteurs de carbone ou de purificateurs d'eau alimentaire.

Libellés :

bio,

numérique,

santé,

technologie

24 novembre 2011

DIV : Batelle pointe le recul de la France en investissement de R&D.

Le conseil européen affichait en 2000 l'objectif de faire de l’Europe “l’économie de connaissance la plus compétitive et la plus dynamique du Monde”.

Cette stratégie de Lisbonne, véritable engagement européen vers l’avenir, s’accompagnait d’objectifs précis, dont la volonté de développer la recherche et développement (R&D), décrite comme seule source d’innovation et de croissance sur le long terme. La stratégie de Lisbonne a été développée au cours de plusieurs Conseils européens postérieurs et repose sur trois piliers :

Un pilier économique qui vise à transformer l'économie européenne en une économie compétitive, dynamique et fondée sur la connaissance.

Un pilier social qui doit permettre de moderniser le modèle social européen grâce à l'investissement dans les ressources humaines et à la lutte contre l'exclusion sociale.

Un pilier environnemental, ajouté lors du Conseil européen de Göteborg en juin 2001, qui attire l'attention sur le fait que la croissance économique doit être dissociée de l'utilisation des ressources naturelles.

Cet objectif était chiffré : les états s'engageaient à atteindre en 2010 un taux d'investissement -public et privé- total dans la R&D égal à 3% du PIB européen (objectif dit de Barcelone) et un taux d'emploi de 70% (proportion de la population européenne en âge de travailler qui occupe un emploi).

Cette règle unanime des 3% était jugée comme largement accessible en comparaison des autres pays développés. L'espoir était au rendez-vous, le développement scientifique était programmé, et d'ailleurs réaffirmé en 2005 par le Conseil Européen (chapitre 11 du rapport de mars 2005).

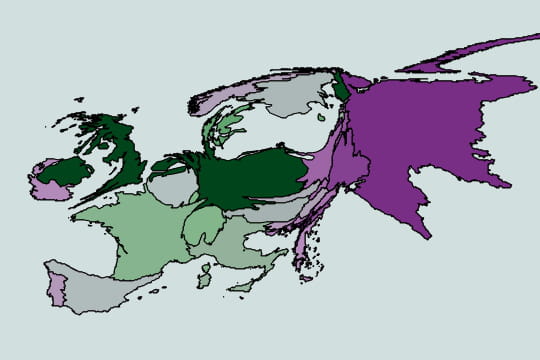

Même si la stratégie de Lisbonne a été revue à la baisse par les Etats, il convient de regarder les dépenses de R&D de manière relative entre eux. Ainsi la France se situait en 1993 au 5e rang mondial en pourcentage de la richesse nationale consacré à la recherche. Le rapport annuel de la société Battelle montre que le pourcentage de dépenses en R&D de la France est descendu sous la barre symbolique des 2% depuis 2010 (2% en 2009, 1,9% en 2010, 1,9% en 2011). La France se retrouve en 6ème place en valeur absolue dans le classement mondial en termes d’investissement en R&D pour 2011, alors qu'elle était encore 5ème en 2009. Elle se retrouve surtout mal placée en investissement relatif au PIB, bien loin des 3%, et 13ème derrière Israel (4,2%), le Japon et la Suède (3,3%), la Finlande (3,1%), la Corée du Sud (3%), les Etats-Unis (2,7%), l'Autriche (2,5%), le Dannemark (2,4%), l'Allemagne, Taiwan, la Suisse, l'Islande et Singapour (2,3%).

Bien entendu, toutes les bonnes raisons et justifications des politiques en charge sont au rendez-vous ! reste que la recherche française s'appauvrit, loin des engagements et du but fixé des 3%.

Voir le rapport Battelle 2009.

Voir le rapport Battelle 2011.

Voir l'ensemble des tableaux de la R&D en Europe/OCDE.

Cette stratégie de Lisbonne, véritable engagement européen vers l’avenir, s’accompagnait d’objectifs précis, dont la volonté de développer la recherche et développement (R&D), décrite comme seule source d’innovation et de croissance sur le long terme. La stratégie de Lisbonne a été développée au cours de plusieurs Conseils européens postérieurs et repose sur trois piliers :

Un pilier économique qui vise à transformer l'économie européenne en une économie compétitive, dynamique et fondée sur la connaissance.

Un pilier social qui doit permettre de moderniser le modèle social européen grâce à l'investissement dans les ressources humaines et à la lutte contre l'exclusion sociale.

Un pilier environnemental, ajouté lors du Conseil européen de Göteborg en juin 2001, qui attire l'attention sur le fait que la croissance économique doit être dissociée de l'utilisation des ressources naturelles.

Cet objectif était chiffré : les états s'engageaient à atteindre en 2010 un taux d'investissement -public et privé- total dans la R&D égal à 3% du PIB européen (objectif dit de Barcelone) et un taux d'emploi de 70% (proportion de la population européenne en âge de travailler qui occupe un emploi).

Cette règle unanime des 3% était jugée comme largement accessible en comparaison des autres pays développés. L'espoir était au rendez-vous, le développement scientifique était programmé, et d'ailleurs réaffirmé en 2005 par le Conseil Européen (chapitre 11 du rapport de mars 2005).

Même si la stratégie de Lisbonne a été revue à la baisse par les Etats, il convient de regarder les dépenses de R&D de manière relative entre eux. Ainsi la France se situait en 1993 au 5e rang mondial en pourcentage de la richesse nationale consacré à la recherche. Le rapport annuel de la société Battelle montre que le pourcentage de dépenses en R&D de la France est descendu sous la barre symbolique des 2% depuis 2010 (2% en 2009, 1,9% en 2010, 1,9% en 2011). La France se retrouve en 6ème place en valeur absolue dans le classement mondial en termes d’investissement en R&D pour 2011, alors qu'elle était encore 5ème en 2009. Elle se retrouve surtout mal placée en investissement relatif au PIB, bien loin des 3%, et 13ème derrière Israel (4,2%), le Japon et la Suède (3,3%), la Finlande (3,1%), la Corée du Sud (3%), les Etats-Unis (2,7%), l'Autriche (2,5%), le Dannemark (2,4%), l'Allemagne, Taiwan, la Suisse, l'Islande et Singapour (2,3%).

Bien entendu, toutes les bonnes raisons et justifications des politiques en charge sont au rendez-vous ! reste que la recherche française s'appauvrit, loin des engagements et du but fixé des 3%.

Voir le rapport Battelle 2009.

Voir le rapport Battelle 2011.

Voir l'ensemble des tableaux de la R&D en Europe/OCDE.

22 novembre 2011

DIV : 40 propositions des ingénieurs pour réindustrialiser la France !

Depuis trop longtemps négligés dans le débat public, méconnus des politiques plus prompts à valoriser les diplômés des écoles de commerce, de politique ou autres plus que de conception ou de production, régulièrement malmenés par des universitaires rêvant de dissoudre les écoles dans des universités pour conjurer leur propre décrépitude, et parfois victimes d'une nouvelle engeance de manageurs-dépaysateurs, les ingénieurs et scientifiques entendent profiter des campagnes électorales de 2012 pour faire valoir leur voix.

C'est sous la forme d'un livre blanc que les ingénieurs et scientifique de France ont regroupé 40 propositions pour réindustrialiser la France.

Le Livre blanc vient d'être envoyé aux candidats à la présidentielle et aux parlementaires.

Il fera l'objet de rencontres et débats jusqu'aux élections législatives, relayés par de grands médias comme L'Usine Nouvelle.

Les sujets n'y manquent pas : Fukushima, Mediator, PSA, Investissements d'avenir... C'est l'actualité qui guide les questions et les propositions pour lesquelles la science et l'ingénierie est au centre des réponses.

Selon L'Usine Nouvelle : un vrai travail d'ingénieurs, méthodique et mesuré. cela change de certains discours et sa lecture ferait certainement du bien à certains candidats ... pour peu qu'ils le veuillent ou le puissent, dans les quelques mois prochains qui s'annoncent fort mouvementés.

Lire le livre blanc (.pdf).

C'est sous la forme d'un livre blanc que les ingénieurs et scientifique de France ont regroupé 40 propositions pour réindustrialiser la France.

Le Livre blanc vient d'être envoyé aux candidats à la présidentielle et aux parlementaires.

Il fera l'objet de rencontres et débats jusqu'aux élections législatives, relayés par de grands médias comme L'Usine Nouvelle.

Les sujets n'y manquent pas : Fukushima, Mediator, PSA, Investissements d'avenir... C'est l'actualité qui guide les questions et les propositions pour lesquelles la science et l'ingénierie est au centre des réponses.

Selon L'Usine Nouvelle : un vrai travail d'ingénieurs, méthodique et mesuré. cela change de certains discours et sa lecture ferait certainement du bien à certains candidats ... pour peu qu'ils le veuillent ou le puissent, dans les quelques mois prochains qui s'annoncent fort mouvementés.

Lire le livre blanc (.pdf).

Libellés :

économie,

entreprise,

info générale,

ingénieur,

polémique,

publication

IA : L'année Turing

À l'occasion du centenaire de la naissance de Alan Turing, plusieurs actions vont être menées au cours de cette année 2012.

La revue Philosophia Scientiæ publiera un volume spécial, prévu pour mars, comportant une sélection d'articles en rapport avec trois thématiques :

La revue Philosophia Scientiæ publiera un volume spécial, prévu pour mars, comportant une sélection d'articles en rapport avec trois thématiques :

1. Histoire des sciences : L'œuvre de Turing dans l'histoire de la logique mathématique

2. Philosophie de la logique : L'œuvre de Turing du point de vue de la philosophie de la logique

3. Logique mathématique, informatique fondamentale: L'influence actuelle de l'œuvre de Turing en logique mathématique.

Du 2 au 6 juillet 2012 se tiendra à Birmingham (Royaume Uni) la réunion conjointe de l'AISB (The Society for the Study of Artificial Intelligence and Simulation of Behaviour) et de l'IACAP (The International Association for Computing and Philosophy) consacrée à Turing.

De nombreuses autres initiatives seront signalées ici au fil des mois prochains.

L'année Turing est coordonnée par le Turing Centenary Advisory Committee (TCAC).

Libellés :

culture,

épistémologie,

info générale,

numérique,

publication,

réunion scientifique

20 novembre 2011

DIV : Mystères chinois ...

(40.452107,93.742118), (40.458148,93.393145) pour un rectangle ou un carré rainurés, ou même des carrés en carré (ici) ;

(40.458679,93.31314) pour les douze cadrans d'une forme spirale ;

(40.452107,90.85693359375) pour de grands bassins ...!

Tapez ces coordonnées dans Google-Map ...

C'est la liste que Gizmodo publie en posant la question "mais que fait la Chine dans son désert" dans son billet du 13 novembre 2011 ?

Quelles sont ces gigantesques structures construites et couvertes parfois de voitures détruites, ou striées d'immenses bandes tirées au cordeau ? Et que sont ces aérodromes doubles et lumineux, à pièces déportées (40.488966,93.50004), ces immenses piscines côtoyant des tours similaires à celles d'une usine nucléaire, ou ces alignements de stries parallèles sur des kilomètres et des kilomètres (44.711336, 93.529494) ?

C'est à n'y rien comprendre, vu d'en haut, sauf que la Chine construit dans l'immensité du désert, des structures elle-mêmes démesurées, dont l'occident ignore tout ... mais que Google voit ...

(40.458679,93.31314) pour les douze cadrans d'une forme spirale ;

(40.452107,90.85693359375) pour de grands bassins ...!

Tapez ces coordonnées dans Google-Map ...

C'est la liste que Gizmodo publie en posant la question "mais que fait la Chine dans son désert" dans son billet du 13 novembre 2011 ?

Quelles sont ces gigantesques structures construites et couvertes parfois de voitures détruites, ou striées d'immenses bandes tirées au cordeau ? Et que sont ces aérodromes doubles et lumineux, à pièces déportées (40.488966,93.50004), ces immenses piscines côtoyant des tours similaires à celles d'une usine nucléaire, ou ces alignements de stries parallèles sur des kilomètres et des kilomètres (44.711336, 93.529494) ?

C'est à n'y rien comprendre, vu d'en haut, sauf que la Chine construit dans l'immensité du désert, des structures elle-mêmes démesurées, dont l'occident ignore tout ... mais que Google voit ...

Libellés :

inexpliqué

Pays/territoire :

Dunhuang, Jiuquan, Gansu, République populaire de Chine

19 novembre 2011

DIV : Encore trop vite pour la lumière ...

La polémique sur les particules qui semblent avoir dépassé la limite de la vitesse de la lumière, et que nous annoncions le 23 septembre dernier, n'est pas prête de s'arrêter.

Une nouvelle expérience organisée entre le Cern et l'Italie a encore une fois montré que les neutrinos avaient clairement dépassé la vitesse de la lumière, éliminant une source d'erreurs potentielles dans les premières mesures. Ces neutrinos ultraluminiques mettent à mal une nouvelle fois la théorie de la relativité restreinte.

faut-il revoir la physique ?

Une nouvelle expérience organisée entre le Cern et l'Italie a encore une fois montré que les neutrinos avaient clairement dépassé la vitesse de la lumière, éliminant une source d'erreurs potentielles dans les premières mesures. Ces neutrinos ultraluminiques mettent à mal une nouvelle fois la théorie de la relativité restreinte.

faut-il revoir la physique ?

Libellés :

épistémologie,

inexpliqué,

info générale

Pays/territoire :

CERN, 1211 Meyrin, Suisse

15 novembre 2011

IA : Google laboratoire du futur.

Le New York Times vient de révéler dans son édition du 13 novembre 2011 (lien) l'existence à Montain-View (juste entre Stanford et Sunnyvale, en plein coeur de la Silicon Valley) d'un laboratoire secret, baptisé Google X, où de nombreux projets futuristes et technologiques sont en train de voir le jour.

Ce laboratoire du futur développe théoriquement et/ou pratiquement des projets pensés par les cerveaux "maison" : voitures drones (déjà révélé par Google), robots, ampoules télécommandées, ascenseurs spatiaux, etc., concernant tous l'interface homme-machine, la robotique, la domotique, et l'intelligence artificielle.

Ce laboratoire du futur développe théoriquement et/ou pratiquement des projets pensés par les cerveaux "maison" : voitures drones (déjà révélé par Google), robots, ampoules télécommandées, ascenseurs spatiaux, etc., concernant tous l'interface homme-machine, la robotique, la domotique, et l'intelligence artificielle.

Libellés :

homme augmenté,

ia,

ihm,

NTIC,

numérique,

robot,

technologie

Pays/territoire :

Mountain View, Californie, États-Unis

13 novembre 2011

IA - SHS : L'Opendata s'ouvre aux entreprises.

L'opendata correspond à la fois à un processus et à un mouvement récent qui consistent pour certaines administrations, telles que par exemple les villes de Paris, San-Francisco, New-York, Toronto ou Bordeaux, les gouvernements des USA, britanique, du Piémont italien, ou de la, France notamment avec Etalab, et secondairement pour certaines entreprises utilisatrices et productrices de données, telles que par exemple Kéolis à Rennes, à les mettre librement à disposition pour pouvoir les étudier, les croiser notamment avec d'autres données locales, les synthétiser, de créer de nouvelles applications innovantes ou de nouveaux usages, etc. (voir le blog de la fabrique digitale).

L’intérêt de cette ouverture est de favoriser les innovations de rupture et, par conséquence, de permettre une aide au développement social et économique. Dans cette perspective, les entreprises sont principalement utilisatrices des données initialement fournies par les institutions, mais elles deviennent également elles-mêmes sources de données ouvertes. La culture a mis du temps à pénétrer (et du temps à pénétrer encore aujourd'hui) les institutions ; elle est loin d'avoir convaincu les chefs d'entreprises toujours soucieuses de confidentialité, souvent dans l'illusion du secret compétitif. Pourtant, d'après les spécialistes, l’opendata est un nouveau moyen d’engagement, de développement et de partenariat des organismes administratifs et des entreprises entre-elles.

Voir une présentation pédagogique sur Slideshare (lien).

En partenariat avec la SNCF, le Groupe La Poste, Suez Environnement, le Groupe POULT, Bluenove, l'un des leaders des services d'open-innovation et d'innovation de ruptures, publie son livre blanc «Open Data : quels enjeux et opportunités pour l’entreprise?»

Le livre est disponible au téléchargement ici (lien).

Le livre blanc est préfacé par Carlo Ratti, directeur du MIT Senseable City Lab., sous le titre «L’Open Data: quels enjeux et opportunité pour l’entreprise?», ainsi qu'en 4ème de couverture un texte de Martin Duval, CEO de Bluenove.

L’intérêt de cette ouverture est de favoriser les innovations de rupture et, par conséquence, de permettre une aide au développement social et économique. Dans cette perspective, les entreprises sont principalement utilisatrices des données initialement fournies par les institutions, mais elles deviennent également elles-mêmes sources de données ouvertes. La culture a mis du temps à pénétrer (et du temps à pénétrer encore aujourd'hui) les institutions ; elle est loin d'avoir convaincu les chefs d'entreprises toujours soucieuses de confidentialité, souvent dans l'illusion du secret compétitif. Pourtant, d'après les spécialistes, l’opendata est un nouveau moyen d’engagement, de développement et de partenariat des organismes administratifs et des entreprises entre-elles.

Voir une présentation pédagogique sur Slideshare (lien).

En partenariat avec la SNCF, le Groupe La Poste, Suez Environnement, le Groupe POULT, Bluenove, l'un des leaders des services d'open-innovation et d'innovation de ruptures, publie son livre blanc «Open Data : quels enjeux et opportunités pour l’entreprise?»

Le livre est disponible au téléchargement ici (lien).

Le livre blanc est préfacé par Carlo Ratti, directeur du MIT Senseable City Lab., sous le titre «L’Open Data: quels enjeux et opportunité pour l’entreprise?», ainsi qu'en 4ème de couverture un texte de Martin Duval, CEO de Bluenove.

Libellés :

économie,

entreprise,

internet,

NTIC,

numérique,

publication,

shs

Pays/territoire :

67 Rue d'Aguesseau, 92100 Boulogne-Billancourt, France

IA - SHS : Le RAT de l'ombre a-t-il été découvert ?

Qui est le RAT de l'ombre ? C'est la question que se pose la société de surveillance et sécurité informatique mondiale McAfee qui vient de révéler l'existence de la plus grande entreprise de piratage informatique de l'histoire.

En cinq ans, au moins 72 gouvernements, ONG, et autres organisations institutionnelles comme les Nations Unies, le Comité Olympique International, l’Agence mondiale antidopage, l'Agence américaine pour l’énergie, les gouvernements des Etats-Unis, de Taïwan, de l’Inde, de la Corée du Sud, du Vietnam et du Canada, l’Association des nations de l’Asie du Sud-Est, ainsi qu’une multitude de sociétés, des spécialistes de la défense aux entreprises de High-Tech ... ont été attaqués et victimes d'effractions au cours de ces 5 ans.

McAfee suppose, sans la nommer, qu’il y a une seule «entité étatique» derrière ces attaques. D'autres experts, relayés par la presse, désignent plus explicitement un grand état asiatique en pleine progression mondiale. Ces attaques baptisées « Operation Shady RAT » ou « Opération RAT de l’ombre », (RAT étant l’acronyme de « Remote Access Tool » ou « Outil d’accès à distance ») ont pu être liées les unes aux autres par le fait qu’elles ont été découvertes via les archives d’un serveur de « commande et contrôle » examiné par McAfee au début de l'année 2009.

Une carte des attaques est disponible sur le site de Reuters.

Dans le cas des Nations Unies, les hackers ont pénétré dans le système informatique du secrétariat de l’organisation à Genève, ils y sont restés cachés pendant presque deux ans et y ont tranquillement consulté des informations confidentielles. D'autres effractions ont été plus rapides, surement par manque d'intérêt des contenus.

Lire le rapport McAfee "Shady Rat" (.pdf).

En cinq ans, au moins 72 gouvernements, ONG, et autres organisations institutionnelles comme les Nations Unies, le Comité Olympique International, l’Agence mondiale antidopage, l'Agence américaine pour l’énergie, les gouvernements des Etats-Unis, de Taïwan, de l’Inde, de la Corée du Sud, du Vietnam et du Canada, l’Association des nations de l’Asie du Sud-Est, ainsi qu’une multitude de sociétés, des spécialistes de la défense aux entreprises de High-Tech ... ont été attaqués et victimes d'effractions au cours de ces 5 ans.

McAfee suppose, sans la nommer, qu’il y a une seule «entité étatique» derrière ces attaques. D'autres experts, relayés par la presse, désignent plus explicitement un grand état asiatique en pleine progression mondiale. Ces attaques baptisées « Operation Shady RAT » ou « Opération RAT de l’ombre », (RAT étant l’acronyme de « Remote Access Tool » ou « Outil d’accès à distance ») ont pu être liées les unes aux autres par le fait qu’elles ont été découvertes via les archives d’un serveur de « commande et contrôle » examiné par McAfee au début de l'année 2009.

Une carte des attaques est disponible sur le site de Reuters.

Dans le cas des Nations Unies, les hackers ont pénétré dans le système informatique du secrétariat de l’organisation à Genève, ils y sont restés cachés pendant presque deux ans et y ont tranquillement consulté des informations confidentielles. D'autres effractions ont été plus rapides, surement par manque d'intérêt des contenus.

Lire le rapport McAfee "Shady Rat" (.pdf).

Libellés :

info générale,

internet,

NTIC,

polémique

Pays/territoire :

Chine

12 novembre 2011

DIV : 7 merveilles de la nature.

A l'instar du classement des "7 nouvelles merveilles du Monde", établies sur le principe des "7 merveilles du monde antique" (établies par Philon de Byzance), et avant le classement des "7 villes merveilleuses", ou "Wondercities", le classement des "7 merveilles de la Nature" a été publié par la fondation suisse New7Wonders.

Par ordre alphabétique, les plus beaux endroits du monde seraient, parmi 28 finalistes :

- l'Amazonie,

- la baie d'Halong (Vietnam),

- les chutes d'Iguazu (Brésil, Argentine),

- l'île de Jeju (Corée du Sud),

- l'île de Komodo (Indonésie),

- la rivière souterraine de Puerto Princesa (Philippines),

- la montagne de la Table (Afrique du Sud).

Pourquoi pas, et à quand, les "7 merveilles de la littérature", les "7 merveilles de l'art", "7 merveilles de la sciences " et les "7 merveilles de la technologie" ? Encore un peu d'imagination, Monsieur Werber !

Libellés :

info générale

Pays/territoire :

Zurich, Suisse

11 novembre 2011

DIV : C'est le moment "1" à la minute près.

Il est onze heures onze, ce vendredi 11 novembre 2011.

Autrement dit ou, pour l'occasion, écrit : 11/11/11 11:11

Rendez vous l'an prochain, dans 13 mois et 71 minutes de plus ... ou dans un siècle exactement !

Autrement dit ou, pour l'occasion, écrit : 11/11/11 11:11

Rendez vous l'an prochain, dans 13 mois et 71 minutes de plus ... ou dans un siècle exactement !

09 novembre 2011

IA - SHS : Du sérieux dans les jeux - Revue d'Intelligence Artificielle.

La Revue d’Intelligence Artificielle (RIA) publie ous la direction de Jérome Dupire, Jean-Marc Labat et Stéphane Natkin, un numéro spécial sur les "Serious Games".

Dans ce domaine, la France accompagne le mouvement international avec les américains, canadiens, anglais, allemands ou japonais. L'activité du domaine est d'ailleurs loin d'être négligeable, représentant un réel enjeu économique.

Intitulé "Jeu sérieux, révolution pédagogique ou effet de mode ?", RIA propose 6 articles questionnant les enjeux et problèmes soulevés par les serious games.

Au sommaire :

Du jeu sérieux au jeu utile - Introduction - par Jérome Dupire, Jean-Marc Labat et Stéphane Natkin;

Les sciences cognitives jettent un pont entre éducation et jeux sérieux - par Elena Pasquinelli;

Evaluation d’un jeu sérieux pour l’apprentissage de la programmation - par Mathieu Muratet, Patrice Torguet, Fabienne Viallet et Jean-Pierre Jessel;

Usage d’un jeu sérieux dans l’enseignement secondaire. Modélisation comportementale et épistémique de l’apprenant - par Eric Sanchez;

Améliorer la motivation dans les environnements d’apprentissage basés sur le jeu - par Thibault Carron et Jean-Charles Marty;

Techniques d’adaptation dans les jeux ludiques et sérieux. Etat de l’art - par Nadia Hocine, Abdelkder Gouaïch, Ines Di Loreto et Lylia Abrouk;

Authenticité d’un jeu sérieux. Modèle pour la conception et l’analyse - par Celso Gonçalves, Marie-Caroline Croiset, Muriel Ney, Nicolas Balacheff, Claudine Schwartz et Jean-Luc Bosson.

Accéder à la présentation du volume (.pdf).

Se procurer le numéro (lien).

Dans ce domaine, la France accompagne le mouvement international avec les américains, canadiens, anglais, allemands ou japonais. L'activité du domaine est d'ailleurs loin d'être négligeable, représentant un réel enjeu économique.

Intitulé "Jeu sérieux, révolution pédagogique ou effet de mode ?", RIA propose 6 articles questionnant les enjeux et problèmes soulevés par les serious games.

Au sommaire :

Du jeu sérieux au jeu utile - Introduction - par Jérome Dupire, Jean-Marc Labat et Stéphane Natkin;

Les sciences cognitives jettent un pont entre éducation et jeux sérieux - par Elena Pasquinelli;

Evaluation d’un jeu sérieux pour l’apprentissage de la programmation - par Mathieu Muratet, Patrice Torguet, Fabienne Viallet et Jean-Pierre Jessel;

Usage d’un jeu sérieux dans l’enseignement secondaire. Modélisation comportementale et épistémique de l’apprenant - par Eric Sanchez;

Améliorer la motivation dans les environnements d’apprentissage basés sur le jeu - par Thibault Carron et Jean-Charles Marty;

Techniques d’adaptation dans les jeux ludiques et sérieux. Etat de l’art - par Nadia Hocine, Abdelkder Gouaïch, Ines Di Loreto et Lylia Abrouk;

Authenticité d’un jeu sérieux. Modèle pour la conception et l’analyse - par Celso Gonçalves, Marie-Caroline Croiset, Muriel Ney, Nicolas Balacheff, Claudine Schwartz et Jean-Luc Bosson.

Accéder à la présentation du volume (.pdf).

Se procurer le numéro (lien).

Libellés :

ia,

NTIC,

numérique,

publication,

Sciences cognitives,

shs

Pays/territoire :

Rue d'Ulm, 75005 Paris, France

08 novembre 2011

IA : Un chien d'aveugle en dur.

La firme NSK du japon vient de développer le NR003, qui est un chien robotique destiné aux aveugles.

Ce prototype de "dogbot" se présente comme une quadrupède, dont le malvoyant saisi une anse de collier, et qui est doté d’un capteur Kinect.

Kinect est un néologisme issu de kinetic et connect. Ce capteur est bien connu du monde du jeu vidéo depuis 2007, année de sa commercialisation. Il s'agit d'un périphérique de la console de jeux vidéo Xbox 360, qui permet d'interagir avec elle sans utiliser de manette ou de clavier, directement grâce à une caméra et un capteur sonore. La caméra utilise des techniques d’interaction développées par PrimeSense, et elle permet la reconnaissance d’image et de mouvement. Kinect permet ainsi d’interagir par commande vocale ou par geste.

Le capteur permet au robot-guide d’identifier des obstacles et de les franchir avec plus ou moins de rapidité.

NSK envisage de doter son dogbot d'un système de commandes vocales et de le doter d’un GPS permettant une géolocalisation interactive.

Le robot est actuellement en phase prototype, et bien peu adaptable à une utilisation fluide des déplacements des malvoyants. Néanmoins, on peut saluer la performance et prévoir des développements qui permettent d'espérer des dogbots en remplacement des chiens d'aveugles les prochaines années. Bien qu'il ne faille plus lui "apprendre le trottoir" ni lui servir sa "gamelle", restera cependant à savoir si les relations avec ce tas de ferraille seront aussi conviviales qu'avec un vrai "meilleur ami de l'homme".

Voir une vidéo (lien).

Ce prototype de "dogbot" se présente comme une quadrupède, dont le malvoyant saisi une anse de collier, et qui est doté d’un capteur Kinect.

Kinect est un néologisme issu de kinetic et connect. Ce capteur est bien connu du monde du jeu vidéo depuis 2007, année de sa commercialisation. Il s'agit d'un périphérique de la console de jeux vidéo Xbox 360, qui permet d'interagir avec elle sans utiliser de manette ou de clavier, directement grâce à une caméra et un capteur sonore. La caméra utilise des techniques d’interaction développées par PrimeSense, et elle permet la reconnaissance d’image et de mouvement. Kinect permet ainsi d’interagir par commande vocale ou par geste.

Le capteur permet au robot-guide d’identifier des obstacles et de les franchir avec plus ou moins de rapidité.

NSK envisage de doter son dogbot d'un système de commandes vocales et de le doter d’un GPS permettant une géolocalisation interactive.

Le robot est actuellement en phase prototype, et bien peu adaptable à une utilisation fluide des déplacements des malvoyants. Néanmoins, on peut saluer la performance et prévoir des développements qui permettent d'espérer des dogbots en remplacement des chiens d'aveugles les prochaines années. Bien qu'il ne faille plus lui "apprendre le trottoir" ni lui servir sa "gamelle", restera cependant à savoir si les relations avec ce tas de ferraille seront aussi conviviales qu'avec un vrai "meilleur ami de l'homme".

Voir une vidéo (lien).

Libellés :

handicap,

homme augmenté,

ihm,

robot

Pays/territoire :

East Asia

06 novembre 2011

IA - SHS : Du Web 1 au Web 5 - le 3, ça coince.

Du Web 1.0 au Web 5.0, le passage au Web 3.0 n'est pas celui que l'on attendait.

Lire la chronique de Jean-Marie Le Ray (lien), expert du monde web, sur l'excellent site "presse citron" et sur "humain sémantique".

DIV : Après "Aerospace valley", Agrimip devient pôle inter-régional Aquitaine Midi-Pyrénées.

Le pôle de compétitivité "Agrimip Sud-Ouest" devient une nouvelle structure inter-régionale associant Aquitaine et midi-Pyrénées, à l'exemple du pôle de compétitivité Aerospace Valley, pour l'excellence et l'innovation agro-industrielle.

Issu du développement du pôle midi pyrénéen AgriMip et à son extension à la région Aquitaine, le pôle de compétitivité a été officialisé ce 4 novembre 2011 lors de l'Assemblée générale de la Fédération Régionale des Coopératives Agricoles (FRCA).

Plus de détails (lien).

Issu du développement du pôle midi pyrénéen AgriMip et à son extension à la région Aquitaine, le pôle de compétitivité a été officialisé ce 4 novembre 2011 lors de l'Assemblée générale de la Fédération Régionale des Coopératives Agricoles (FRCA).

Plus de détails (lien).

Libellés :

info générale

Pays/territoire :

680 Cours de la Libération, 33400 Talence, France

IA - SHS : Les nouvelles technologies : révolution culturelle et cognitive selon Serres

« Les nouvelles technologies nous ont condamnés à devenir intelligents ! ». C'est ce que postule Michel Serres...

Le 11 décembre 2007, à l'occasion des 40 ans de l'INRIA, le sociologuqe Michel Serres a donné une conférence sur la révolution culturelle et cognitive engendrée par les nouvelles technologies.

Pour lui, la révolution informatique change notre rapport au monde, comme avant elle l'écriture, puis l'imprimerie l'avaient fait. Une conséquence inévitable de cette révolution est le changement de notre rapport au monde.

La révolution cognitive générée par la révolution de l'information relève notamment de la dépersonnalisation et de l'externalisation de la mémoire, entrainant aussi inventivité, nouvelle intelligence et participation à cette nouvelle Histoire.

Visionner la vidéo - 1 heure - sur le site de culture scientifique "interstices" (lien).

Écouter la conférence en MP3 (lien).

Le 11 décembre 2007, à l'occasion des 40 ans de l'INRIA, le sociologuqe Michel Serres a donné une conférence sur la révolution culturelle et cognitive engendrée par les nouvelles technologies.

Pour lui, la révolution informatique change notre rapport au monde, comme avant elle l'écriture, puis l'imprimerie l'avaient fait. Une conséquence inévitable de cette révolution est le changement de notre rapport au monde.

La révolution cognitive générée par la révolution de l'information relève notamment de la dépersonnalisation et de l'externalisation de la mémoire, entrainant aussi inventivité, nouvelle intelligence et participation à cette nouvelle Histoire.

Visionner la vidéo - 1 heure - sur le site de culture scientifique "interstices" (lien).

Écouter la conférence en MP3 (lien).

Libellés :

conférence,

NTIC

Pays/territoire :

Le Chesnay, France

05 novembre 2011

IA : Un UAV pour le viaduc de Millau.

Le viaduc de Millau est aujourd'hui l'ensemble routier le plus haut du Monde. Ce pont à haubans franchit la vallée du Tarn (Aveyron, France), sur une brèche de 2460 mètres de longueur avec 270 mètres de profondeur au point de surplomb le plus important. Il permet ainsi à l’autoroute "Méridienne" de relier, au sud de Millau, Clermont-Ferrand à Béziers. Oeuvre de l’architecte Norman Foster, il a été construit pour 320 millions d’euros par le groupe Eiffage, et mis en service en décembre 2004.

Bien que garanti pour 120 ans, l'ouvrage subit une "grande visite" d'entretien tous les six ans. C'est dans cette perspective que Eiffage a missionné la société Diadès qui adjoindra à la vingtaine d'ingénieurs, techniciens et experts, un drone doté de moyens de transmission et d'enregistrement des photos et vidéos. Ce dispositif technique permettra un diagnostic détaillé de pièces inaccessibles avec un géo-référencement temps réel.

L'UAV U-130 a été conçu par la société de robotique aérienne Novadem et peut voler à plus de 200 m de hauteur, en vol dynamique ou statique, par condition de beau temps.

Bien que garanti pour 120 ans, l'ouvrage subit une "grande visite" d'entretien tous les six ans. C'est dans cette perspective que Eiffage a missionné la société Diadès qui adjoindra à la vingtaine d'ingénieurs, techniciens et experts, un drone doté de moyens de transmission et d'enregistrement des photos et vidéos. Ce dispositif technique permettra un diagnostic détaillé de pièces inaccessibles avec un géo-référencement temps réel.

L'UAV U-130 a été conçu par la société de robotique aérienne Novadem et peut voler à plus de 200 m de hauteur, en vol dynamique ou statique, par condition de beau temps.

Libellés :

info générale,

robot,

technologie

Pays/territoire :

Creissels, France

01 novembre 2011

IA - SHS : Comment débattre des nouvelles technologies ?

Le Centre d'analyse stratégique propose un colloque

Comment débattre des nouvelles technologies ?

Mardi 8 novembre 2011 de 14h30 à 18h30

Maison de la Chimie, Salle 162

28, rue Saint-Dominique - 75007 Paris

Comment notre société peut-elle débattre du développement des technologies et des innovations émergentes, afin d’aboutir à leur développement responsable ? Quels principes doivent nous guider dans l’organisation des concertations correspondantes ?

Inscription (lien).

Comment débattre des nouvelles technologies ?

Mardi 8 novembre 2011 de 14h30 à 18h30

Maison de la Chimie, Salle 162

28, rue Saint-Dominique - 75007 Paris

Comment notre société peut-elle débattre du développement des technologies et des innovations émergentes, afin d’aboutir à leur développement responsable ? Quels principes doivent nous guider dans l’organisation des concertations correspondantes ?

Inscription (lien).

Libellés :

NTIC,

réunion scientifique

Pays/territoire :

Val-de-Grâce, Paris, France

BIO : Le posthumanisme est-il en marche ? Reprogrammation de cellules âgées en cellules souches.

Le projet posthumaniste de maîtrise du vieillissement est-il en train de prendre de la concrétude ?

Des chercheurs de l'Institut de génomique fonctionnelle de l'université de Montpellier 1 viennent de publier dans le numéro du 1er novembre 2011 (lien) de la revue Genes & Development des travaux portant sur la possibilité d'effacer les marques de vieillissement des cellules de donneurs âgés de plus de 100 ans, et de les reprogrammant au stade de cellules souches, montrant ainsi que le processus du vieillissement est biologiquement réversible : il est possible de renverser le cours spontané du vieillissement.

En 2006-2007, l'équipe japonaise de Shinya Yamakanaka a montré qu'on pouvait obtenir des cellules souches non embryonnaires (Induced Pluripotent Stem Cells - IPSC) à partir de cellule adultes littéralement "reprogrammées" grâce à un "cocktail" de quatre gènes transportés par des virus qui vont s'intégrer au noyau (lentivirus). Ces cellules "artificiellement" dopées présentent les mêmes potentialités que des cellules souches embryonnaires et sont donc pluripotentes, c'est-à-dire capables de se différentier en différents tissus anatomo-fonctionnels selon les besoins.

On pensait que la reprogrammation des cellules adultes humaines en cellules souches était pourtant contrainte par la limite de la sénescence. la frontière est aujourd'hui tombée et les cellules ayant atteint l'arrêt de leur propre capacité de reproduction par prolifération en culture, peuvent être de la même manière reprogrammées.

Au delà des applications potentielles pour la réparation des organes malades, on pense évidemment au maintien d'une capacité cicatricielle, aux greffes de tissus tels que la peau ou les neurones, et au maintien artificiel d'une situation de combat du vieillissement. Cette reprogrammation à partir de propres cellules du receveur contourne d'ailleurs le problème éthique de l'utilisation potentielle de cellules souches d'embryons, jusqu'ici interdite.

La publication rapporte comment les chercheurs ont dans un premier temps multiplié des cellules de la peau (fibroblastes) d'un donneur de 74 ans pour atteindre l'état de sénescence et l'arrêt conséquant de la prolifération des cellules. La reprogrammation in vitro de ces cellules étant alors impossible avec la préparation classique (à base de quatre facteurs génétiques : OCT4, SOX2, C MYC et KLF4 utilisés par les chercheurs japonais), les chercheurs montpellierains ont ajouté deux autres facteurs génétiques (NANOG et LIN28) pour un nouveau "cocktail" à six ingrédients. Les cellules sénescentes reprogrammées ont réacquis les caractéristiques de cellules souches pluripotentes de type embryonnaire, en ne conservant aucune trace de leur vieillissement antérieur. Tout se passe comme si les marqueurs de l'âge des cellules ont été effacés, avec l'acquisition d'une capacité de prolifération et une longévité accrues.

Ce cocktail a également été testé sur des cellules de donneurs de 92 à 101 ans, avec le même résultats, montrant que l'âge n'est plus une barrière à la reprogrammation cellulaire.

Si le débat sur l'utilisation de cellules embryonnaires est ainsi contournée, s'ouvre aujourd'hui celui de la réparation des organes ou des tissus chez des sujets pouvant ainsi espérer reculer indéfiniment le vieillissement de leur corps.

La porte est-elle aujourd'hui ouverte sur le posthumanisme ? En tous cas, ce résultats ne manqueront pas d'alimenter les débats des partisans de l'homme augmenté.

Résumé de la publication (lien).

Les équipes citées appartiennent aux institutions montpelliéraines :

Institut de génomique fonctionnelle (Inserm, Cnrs, Université de Montpellier) - Institut de génomique humaine (Cnrs) - Département de génétique du CHU Arnaud de Villeneuve - Institut de recherche en biothérapie (CHU Saint-Eloi et Université de Montpellier).

Des chercheurs de l'Institut de génomique fonctionnelle de l'université de Montpellier 1 viennent de publier dans le numéro du 1er novembre 2011 (lien) de la revue Genes & Development des travaux portant sur la possibilité d'effacer les marques de vieillissement des cellules de donneurs âgés de plus de 100 ans, et de les reprogrammant au stade de cellules souches, montrant ainsi que le processus du vieillissement est biologiquement réversible : il est possible de renverser le cours spontané du vieillissement.

En 2006-2007, l'équipe japonaise de Shinya Yamakanaka a montré qu'on pouvait obtenir des cellules souches non embryonnaires (Induced Pluripotent Stem Cells - IPSC) à partir de cellule adultes littéralement "reprogrammées" grâce à un "cocktail" de quatre gènes transportés par des virus qui vont s'intégrer au noyau (lentivirus). Ces cellules "artificiellement" dopées présentent les mêmes potentialités que des cellules souches embryonnaires et sont donc pluripotentes, c'est-à-dire capables de se différentier en différents tissus anatomo-fonctionnels selon les besoins.

On pensait que la reprogrammation des cellules adultes humaines en cellules souches était pourtant contrainte par la limite de la sénescence. la frontière est aujourd'hui tombée et les cellules ayant atteint l'arrêt de leur propre capacité de reproduction par prolifération en culture, peuvent être de la même manière reprogrammées.

Au delà des applications potentielles pour la réparation des organes malades, on pense évidemment au maintien d'une capacité cicatricielle, aux greffes de tissus tels que la peau ou les neurones, et au maintien artificiel d'une situation de combat du vieillissement. Cette reprogrammation à partir de propres cellules du receveur contourne d'ailleurs le problème éthique de l'utilisation potentielle de cellules souches d'embryons, jusqu'ici interdite.

La publication rapporte comment les chercheurs ont dans un premier temps multiplié des cellules de la peau (fibroblastes) d'un donneur de 74 ans pour atteindre l'état de sénescence et l'arrêt conséquant de la prolifération des cellules. La reprogrammation in vitro de ces cellules étant alors impossible avec la préparation classique (à base de quatre facteurs génétiques : OCT4, SOX2, C MYC et KLF4 utilisés par les chercheurs japonais), les chercheurs montpellierains ont ajouté deux autres facteurs génétiques (NANOG et LIN28) pour un nouveau "cocktail" à six ingrédients. Les cellules sénescentes reprogrammées ont réacquis les caractéristiques de cellules souches pluripotentes de type embryonnaire, en ne conservant aucune trace de leur vieillissement antérieur. Tout se passe comme si les marqueurs de l'âge des cellules ont été effacés, avec l'acquisition d'une capacité de prolifération et une longévité accrues.

Ce cocktail a également été testé sur des cellules de donneurs de 92 à 101 ans, avec le même résultats, montrant que l'âge n'est plus une barrière à la reprogrammation cellulaire.

Si le débat sur l'utilisation de cellules embryonnaires est ainsi contournée, s'ouvre aujourd'hui celui de la réparation des organes ou des tissus chez des sujets pouvant ainsi espérer reculer indéfiniment le vieillissement de leur corps.

La porte est-elle aujourd'hui ouverte sur le posthumanisme ? En tous cas, ce résultats ne manqueront pas d'alimenter les débats des partisans de l'homme augmenté.

Résumé de la publication (lien).

Les équipes citées appartiennent aux institutions montpelliéraines :

Institut de génomique fonctionnelle (Inserm, Cnrs, Université de Montpellier) - Institut de génomique humaine (Cnrs) - Département de génétique du CHU Arnaud de Villeneuve - Institut de recherche en biothérapie (CHU Saint-Eloi et Université de Montpellier).

Libellés :

bio,

éthique,

homme augmenté,

polémique,

santé

Pays/territoire :

Hérault, France

28 octobre 2011

SHS : D'Alembert s'interroge sur les pratiques du numérique.

Le Centre Interdisciplinaire d'Étude de l'Évolution des Idées, des Sciences et des Techniques d'Alembert (CIEEIST) de l'Université Paris Sud organise son séminaire annuel autour des notions de Nouvelles pratiques et cultures du numérique dans les sciences et les technologies.

Le séminaire aborde l'émergence de ces nouvelles pratiques et cultures dans la production du savoir scientifique, sa validation et sa circulation, sous l'influence des récentes évolutions du numérique en particulier afférentes à Internet.

Au programme :

Renseignements - programme (pdf).

Le séminaire aborde l'émergence de ces nouvelles pratiques et cultures dans la production du savoir scientifique, sa validation et sa circulation, sous l'influence des récentes évolutions du numérique en particulier afférentes à Internet.

Au programme :

- Modification de la manière de construire et partager le savoir.

- Science participative, apprentissage collaboratif.

- Les observatoires virtuels.

- Nouveaux modes de publication scientifique, de validation et d'accès.

- Logiciel libre, ressources libres, données libres.

- Les mathématiques à l'heure du numérique.

- Les changements dans les mathématiques appliquées.

- Nouvelles problématiques et mise en réseau des données en physique des particules.

- Web sémantique, web social.

- Enseignement et apprentissage des sciences

- Biologie et numérique.

- Visualisation de données.

Renseignements - programme (pdf).

Libellés :

conférence,

épistémologie,

NTIC

Pays/territoire :

407 Domaine de l'Université de Paris Sud, 91400 Orsay, France

SHS : Nouveaux usages d’Internet, nouvelle gouvernance pour l’Etat

Colloque : Nouveaux usages d’Internet, nouvelle gouvernance pour l’Etat

Lundi 7 novembre 2011 de 8h30 à 13h

Amphithéâtre Boris Vian - Grande Halle de la Villette, 211 avenue Jean Jaurés - Paris XIXème.

L'Open Data est l'un des thèmes phares qui sera abordé lors de cet évènement en présence de nombreuses personnalités et en collaboration avec Etalab.

Programme du colloque (lien).

Lundi 7 novembre 2011 de 8h30 à 13h

Amphithéâtre Boris Vian - Grande Halle de la Villette, 211 avenue Jean Jaurés - Paris XIXème.

L'Open Data est l'un des thèmes phares qui sera abordé lors de cet évènement en présence de nombreuses personnalités et en collaboration avec Etalab.

Programme du colloque (lien).

Libellés :

internet,

NTIC,

réunion scientifique,

shs

Pays/territoire :

211 Avenue Jean Jaurès, 75019 Paris, France

IA : Le guépard dévore les données.

Jubatus est le nom scientifique du guépard (Acinonyx jubatus). C'est aussi le nom d'une nouvelle technologie d'analyse en temps réel de très gros volumes de données développé par Nippon Telegraph and Telephone (NTT), l'un des leaders japonais des technologies de l'information connu récemment pour avoir doublé la vitesse et détenir le record de transmission par fibre optique, et par Preferred Research, la branche R&D de Prefered Infrastructure, une entreprise japonaise d'informatique et télécom du Hongo Campus de l'Université de Tokyo.

Classiquement, les systèmes d'analyse de données reposent sur un traitement séquentiel "par lots" (batch). Un tel type de traitement n'est pas assez efficace pour les applications massives temps-réel, puisque le batch demande à un serveur d'attendre que toutes les données précédemment reçues soient traitées avant de commencer sa propre analyse.

Les systèmes précédents qui traitent de ce problème d'"explosion des données" sont par exemple Hadoop [1], un framework de développement communautaire supporté par Yahoo!, permettent de diviser des données en clusters selon un procédé de type MapReduce (système conçu par Google) et de les proposer indépendemment à différents serveurs.

Le principe de Jubatus est une analyse continue "distribuée" entre les serveurs. Pour surmonter le problème de la communication entre les serveurs, Jubatus agrège de manière particulièrement flexible des résultats intermédiaires (appelé MIX). Au lieu d'effectuer une comparaison des résultats d'analyse uniquement à la fin de chaque itération, le système optimise le moment où cette opération sera réalisée de façon à augmenter la productivité de chaque serveur et la rapidité de début de calcul. Le système repose sur une architecture dite "pluggable" : les moteurs et modules d'analyse disposent d'interfaces communes. Ils peuvent alors être simplement utilisés comme "briques logicielles".

L'objectif de Jubatus est clairement l'analyse temps réel des informations Internet, avec des projets sur l'étude et la catégorisation instantannée des messages des réseaux sociaux types à des fins de filtrage ou de "recherche floue", dans la détection immédiate de tentatives terroristes ou de cyber-attaques.

Le framework sera prochainement mis à disposition du public en open-source, avec l'espoir ouvertement affirmé de créer une communauté d'utilisateurs

Classiquement, les systèmes d'analyse de données reposent sur un traitement séquentiel "par lots" (batch). Un tel type de traitement n'est pas assez efficace pour les applications massives temps-réel, puisque le batch demande à un serveur d'attendre que toutes les données précédemment reçues soient traitées avant de commencer sa propre analyse.

Les systèmes précédents qui traitent de ce problème d'"explosion des données" sont par exemple Hadoop [1], un framework de développement communautaire supporté par Yahoo!, permettent de diviser des données en clusters selon un procédé de type MapReduce (système conçu par Google) et de les proposer indépendemment à différents serveurs.

Le principe de Jubatus est une analyse continue "distribuée" entre les serveurs. Pour surmonter le problème de la communication entre les serveurs, Jubatus agrège de manière particulièrement flexible des résultats intermédiaires (appelé MIX). Au lieu d'effectuer une comparaison des résultats d'analyse uniquement à la fin de chaque itération, le système optimise le moment où cette opération sera réalisée de façon à augmenter la productivité de chaque serveur et la rapidité de début de calcul. Le système repose sur une architecture dite "pluggable" : les moteurs et modules d'analyse disposent d'interfaces communes. Ils peuvent alors être simplement utilisés comme "briques logicielles".

L'objectif de Jubatus est clairement l'analyse temps réel des informations Internet, avec des projets sur l'étude et la catégorisation instantannée des messages des réseaux sociaux types à des fins de filtrage ou de "recherche floue", dans la détection immédiate de tentatives terroristes ou de cyber-attaques.

Le framework sera prochainement mis à disposition du public en open-source, avec l'espoir ouvertement affirmé de créer une communauté d'utilisateurs

Libellés :

NTIC,

numérique,

technologie

Pays/territoire :

Japon, Tokyo Bunkyō Hongo 2丁目40−1

IA : Définition du Cloud Computing par le NIST (USA)

Mandaté par le Congrès américain via le Federal Information Security Management Act (FISMA 2002), notamment pour établir des standards et des directives dans le domaine de l'informatique à l'attention des agences fédérales américaines, le National Institute for Standards and Technology (NIST) a publié en septembre 2011 un rapport de définition finale du Cloud Computing (Informatique dans le nuage) et les recommandations pour le CC (lien).

Le cloud computing possède 5 caractéristiques essentielles :

Le NIST distingue 3 niveaux de service :

Le CC possède 4 modèles hiérarchiques de déploiement :

Ce processus de standardisation implique un grand nombre d'institutions d'Etat et une large partie du secteur privé économique, administratif et industriel. La prochaine étape des travaux prévus est celle de l'élaboration des normes, notamment en termes d'échange de données, et celle des méthodes pour éviter le "lock-in" (emprisonnement) et des méthodes de sécurité.

Ce rapport sera présenté et discuté lors du prochain "Cloud Computing Forum & Workshop IV" qui se tiendra du 2 au 4 novembre 2011 à Gaithersburg (Maryland - USA).

Accès au rapport du NIST (pdf).

Le cloud computing possède 5 caractéristiques essentielles :

- un service en libre-service à la demande;

- accessible sur l'ensemble d'un réseau;

- avec une mutualisation des ressources;

- rapidement élastique (adaptation rapide à une variation du besoin);

- et mesurable (mesure et affichage de paramètres de consommation).

Le NIST distingue 3 niveaux de service :

- le logiciel en tant que service (Software as a Service - SaaS) - par exemple un usager "loue" un logiciel de comptabilité, en ligne, à la demande, chez un prestataire externe;

- la plateforme en tant que service (PaaS) - une solution externe qui propose une suite logicielle et les outils d'intégration et de suivi, tels qu'un serveur web (Linux+Apache+MySQL+Php);

- l'infrastructure en tant que service (IaaS) - la totalité de l'infrastructure (ressources matérielles) est externe, par exemple une capacité de stockage et une capacité de calcul à la demande sur un réseau.

Le CC possède 4 modèles hiérarchiques de déploiement :

- le nuage privé (au sein d'une même organisation);

- le nuage communautaire (réservé à une communauté);

- le nuage public (ouvert au grand public);

- le nuage hybride (composition de plusieurs types de nuages).

Ce processus de standardisation implique un grand nombre d'institutions d'Etat et une large partie du secteur privé économique, administratif et industriel. La prochaine étape des travaux prévus est celle de l'élaboration des normes, notamment en termes d'échange de données, et celle des méthodes pour éviter le "lock-in" (emprisonnement) et des méthodes de sécurité.

Ce rapport sera présenté et discuté lors du prochain "Cloud Computing Forum & Workshop IV" qui se tiendra du 2 au 4 novembre 2011 à Gaithersburg (Maryland - USA).

Accès au rapport du NIST (pdf).

Pays/territoire :

Gaithersburg, Maryland 20899, États-Unis

20 octobre 2011

IA : Colloque "Ingénierie numérique" : ruptures et technologies émergentes

Le Colloque Ingénierie Numérique «Entre ruptures technologiques et progrès économique et sociétal» est organisé par le pôle de compétitivité parisien des contenus et services numériques "Cap Digital".

Il se tiendra au Conseil Économique, Social et Environnemental à Paris (Palais d’Iéna) le vendredi 25 novembre 2011.

Ce colloque permettra de croiser les approches technologiques, économiques et sociétales, à propos des avancées et ruptures de certaines technologies-clé du numérique (virtualisation, immersion-3D, modélisation et simulation, masses de données), ainsi que des opportunités et des conditions de leur mise en œuvre à partir de l’expérience de quelques grands secteurs industriels (transports, chimie-matériaux, industries agro-alimentaires).

Organisé sous forme de tables rondes thématiques, le colloque fait intervenir chercheurs et industriels, grands groupes et PME, acteurs des pôles de compétitivité.

MATIN : Ruptures et technologies émergentes : virtualisation et immersion 3D, modélisation et simulation, masses de données ;

APRES-MIDI : Contribution des ruptures technologiques à l’activité industrielle : Secteurs des Transports, de la Chimie et des Matériaux, et Agro-alimentaire.

Il se tiendra au Conseil Économique, Social et Environnemental à Paris (Palais d’Iéna) le vendredi 25 novembre 2011.

Ce colloque permettra de croiser les approches technologiques, économiques et sociétales, à propos des avancées et ruptures de certaines technologies-clé du numérique (virtualisation, immersion-3D, modélisation et simulation, masses de données), ainsi que des opportunités et des conditions de leur mise en œuvre à partir de l’expérience de quelques grands secteurs industriels (transports, chimie-matériaux, industries agro-alimentaires).

Organisé sous forme de tables rondes thématiques, le colloque fait intervenir chercheurs et industriels, grands groupes et PME, acteurs des pôles de compétitivité.

MATIN : Ruptures et technologies émergentes : virtualisation et immersion 3D, modélisation et simulation, masses de données ;

APRES-MIDI : Contribution des ruptures technologiques à l’activité industrielle : Secteurs des Transports, de la Chimie et des Matériaux, et Agro-alimentaire.

Libellés :

économie,

NTIC,

numérique,

réunion scientifique,

technologie

Pays/territoire :

Palais d'Iéna, 75116 Paris, France

SHS : Les réseaux sociaux en débat.

L’Institut de Recherches Economiques et Sociales sur les Télécommunications (IREST) organise une réunion-débat sur les réseaux sociaux le jeudi 8 décembre 2011 de 18:00h à 20h à Telecom ParisTech (46, rue Barrault 75013 Paris).

Les réseaux sociaux : Quelles pratiques ? Quels usages ?

Débat animé par Anne-Marie Laulan (professeur émérite à l'Université Bordeaux 3),

avec : Alexandre Coutant (Université de Franche-Comté et ISCC), Bruno Salgues (Institut Télécom), Thomas Stenger (Université de Poitiers et ISCC), Jean-Michel Vergne (BlueKiwi Software).

infos et réservation en ligne (lien).

Les réseaux sociaux : Quelles pratiques ? Quels usages ?

Débat animé par Anne-Marie Laulan (professeur émérite à l'Université Bordeaux 3),

avec : Alexandre Coutant (Université de Franche-Comté et ISCC), Bruno Salgues (Institut Télécom), Thomas Stenger (Université de Poitiers et ISCC), Jean-Michel Vergne (BlueKiwi Software).

infos et réservation en ligne (lien).

Libellés :

internet,

NTIC,

numérique,

réunion scientifique,

shs

Pays/territoire :

Rue Barrault, 75013 Paris, France

IA - SHS : Culture numérique - le réseau.

Culture Numérique est un réseau de chercheurs issus de différents domaines scientifiques, qui s'intéressent aux problématiques posées par les usages des technologies du numérique.

Culture Numérique organise chaque année le Colloque scientifique "Ludovia", lors de la dernière semaine d'août,

à Ax les thermes (Ariège).

Accès au site (lien).

Culture Numérique organise chaque année le Colloque scientifique "Ludovia", lors de la dernière semaine d'août,

à Ax les thermes (Ariège).

Accès au site (lien).

Libellés :

culture,

info générale,

internet,

NTIC,

numérique

Pays/territoire :

09110 Ax-les-Thermes, France

DIV : Infuser les idées - un blog à suivre ...

L’Infusoir est le blog de Mélodie Faury, qui s'illustre aussi dans le Portail "Science et société" et "les atomes crochus". Elle le présente ainsi :

Une approche réflexive sur des sciences ? Faisons infuser nos idées… Mettons dans notre théière quelques pincées de réflexion, trois grammes de bioéthique, un zeste de politique, un parfum d’avenir ; en prendrez-vous une tasse ?

Un point de départ : questionner ma discipline d’origine, la biologie moléculaire et cellulaire.

Qui m’emmènera bien plus loin, aux croisements de l’histoire, de l’épistémologie, de la philosophie et de la sociologie des sciences… avec toujours au centre la question des relations entre sciences et société.

Pour une approche réflexive de la science, où communication scientifique, notamment via la vulgarisation, et culture scientifique auront certainement un place de choix.

Une approche réflexive sur des sciences ? Faisons infuser nos idées… Mettons dans notre théière quelques pincées de réflexion, trois grammes de bioéthique, un zeste de politique, un parfum d’avenir ; en prendrez-vous une tasse ?

Un point de départ : questionner ma discipline d’origine, la biologie moléculaire et cellulaire.

Qui m’emmènera bien plus loin, aux croisements de l’histoire, de l’épistémologie, de la philosophie et de la sociologie des sciences… avec toujours au centre la question des relations entre sciences et société.

Pour une approche réflexive de la science, où communication scientifique, notamment via la vulgarisation, et culture scientifique auront certainement un place de choix.

Libellés :

info générale

Pays/territoire :

Lyon, France

IA - SHS : "Big Brother" impossible à arrêter !

"Surtout les réseaux sociaux, planétaires avec des ramifications infinies, et la géolocalisation, invisible et irréversible. Il est prévu qu'un jour les nanotechnologies soient utilisées dans les systèmes d'information. On se retrouvera alors avec des milliers, voire des millions, de puces RFID [de radio-identification, NDLR] invisibles à l'œil et disséminées partout à l'initiative du secteur public ou privé. On regrettera bientôt l'idée du bon vieux Big Brother, visible et ventripotent. Avec ces milliers de "nano-Brothers" invisibles qui se promènent partout dans la nature, on sera alors face à un phénomène irréversible. Les systèmes d'informations verront et entendront à distance. Nous n'aurons plus jamais la certitude absolue d'être seul, et serons toujours entendu, vu, surveillé... C'est absolument insupportable !"

Déclaration de Alex Türk, sénateur du Nord et président démissionnaire de la Commission nationale de l'informatique et des libertés (Cnil), dans le Nouvel Obs (lien).

Voir également sur ce sujet : Tous fichés ... (Nouvel Obs)

Déclaration de Alex Türk, sénateur du Nord et président démissionnaire de la Commission nationale de l'informatique et des libertés (Cnil), dans le Nouvel Obs (lien).

Voir également sur ce sujet : Tous fichés ... (Nouvel Obs)

Libellés :

éthique,

info générale,

nanotechnologies,

NTIC,

numérique,

polémique,

technologie

19 octobre 2011

SHS - BIO - IA : pour une définition de l'interdisciplinarité

Séminaire Intersciences

Centre François Viète

Université de Nantes

28 octobre à 14h

Édouard Kleinpeter de l'Institut des Sciences de la Communication du CNRS.

«Pour une définition de l’interdisciplinarité»

http://www.sciences.univ-nantes.fr/cfv/

Centre François Viète

Université de Nantes

28 octobre à 14h

Édouard Kleinpeter de l'Institut des Sciences de la Communication du CNRS.

«Pour une définition de l’interdisciplinarité»

http://www.sciences.univ-nantes.fr/cfv/

Libellés :

conférence,

épistémologie,

réunion scientifique

Pays/territoire :

Nantes, France

16 octobre 2011

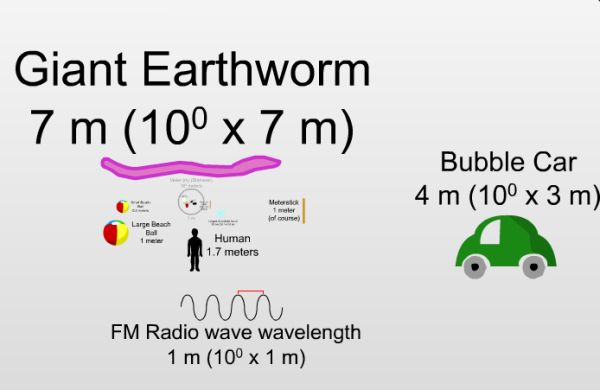

DIV : Les dimensions de l'univers physique.

En musique, pour comprendre les dimensions physiques, de l'immensité du cosmos aux espaces les plus fins de la matérialité, le site "The Scale of thé Universe" donne à voir la physique sous un jour amusant.

15 octobre 2011

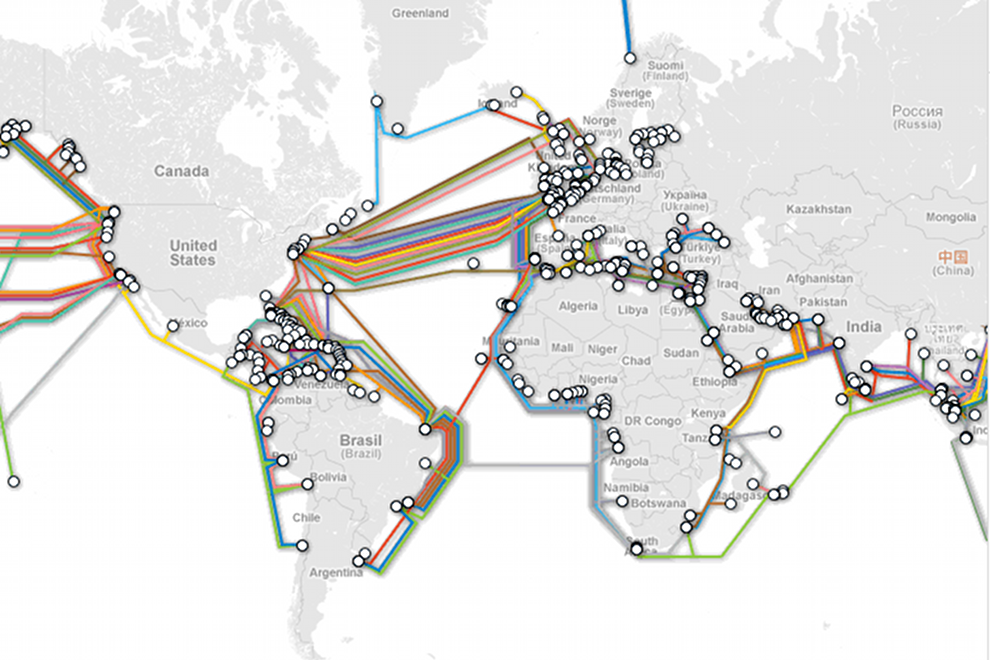

IA : Anatomie du Web

La société Telegeography récolte et analyse depuis plus de vingt ans les données du marché des télécommunications pour en donner des illustrations compréhensibles, en déduire les grandes tendances, et donner des conseils aux entreprises et organismes du secteur.

Telegeographie vient de publier la carte interactive des câbles sous-marins et des infrastructures gigantesques qui sous-tendent notamment le Web mondial.

D’autres schémas sont également publiés, tels que celui de la morphologie du net.

Voir la carte interactive (lien).

Telegeographie vient de publier la carte interactive des câbles sous-marins et des infrastructures gigantesques qui sous-tendent notamment le Web mondial.

D’autres schémas sont également publiés, tels que celui de la morphologie du net.

Voir la carte interactive (lien).

07 octobre 2011

DIV : ABECédaire - appel à contributions

Pour faire évoluer l'ABÉCédaire, chaque lecteur est invité à rédiger et communiquer des pages de documentation et de définition des grandes notions utiles aux étudiants de l'ENSC.

Merci de votre contribution collective.

Merci de votre contribution collective.

Libellés :

culture,

ressource pédagogique

Pays/territoire :

Ecole Nationale Supérieure de Cognitique - Bordeaux - France

06 octobre 2011

BIO : Un laboratoire sur une puce.

La biopuce « mChip » conçue par Samuel Sia et ses collègues du département de biological engineering de l’Université de Columbia, est un véritable laboratoire d’analyses portable. Cette puce a un coût de production d'environ un dollar, et a la capacité de diagnostiquer (pour l'instant) dix maladies différentes simultanément.

Le système nécessite une goutte de sang déposée sur une carte dans laquelle est insérée la biopuce. La lecture se fait immédiatement sur un appareil électronique d’une centaine d’euros, comme un lecteur de cartes bancaires.

Le principe repose sur un dispositif qui fonctionne sur un système de nano particules d’or et d’argent couplées avec une puce électronique. En fonction de la concentration d’agents pathogènes, le film de la biopuce est plus ou moins opaque.

Testée sur une centaine de patients rwandais, l’efficacité de « mChip » est surprenante pour sa facilité et sa fiabilité (proche de 100%). Cette découverte ne manquera pas de modifier profondément le domaine de l'analyse biologique et médicale, avec une commercialisation facilitée qui peut être envisagée directement chez le médecin ou dans les pharmacies ou parapharmacies, avec un dépistage sur place.

Résumé dans Nature Medicine, n°17, pp. 1015–1019 (2011) doi:10.1038/nm.2408

DIV : Internet : toute une histoire ! (conférence)

Internet : toute une histoire !

Conférence de Serge Soudoplatoff.

Jeudi 13 octobre 2011 à 18h

A Cap Sciences

Hangar 20 des quais de Bordeaux

"De tout temps, nous avons inventé des nouveaux outils pour transmettre, partager et conserver nos connaissances et nos idées : l'écriture, l'alphabet puis le livre, l'imprimerie… et aujourd’hui Internet.

Serge Soudoplatoff vient nous parler de ce phénomène qui a si vite envahi nos vies que l’on oublie de s’interroger : quelle est l'origine d'Internet ? Comment fonctionne-t-il ? Pourquoi bouleverse-t-il tant notre quotidien et quel futur nous construit-il ?"

Entrée libre et gratuite.

Conférence de Serge Soudoplatoff.

Jeudi 13 octobre 2011 à 18h

A Cap Sciences

Hangar 20 des quais de Bordeaux

"De tout temps, nous avons inventé des nouveaux outils pour transmettre, partager et conserver nos connaissances et nos idées : l'écriture, l'alphabet puis le livre, l'imprimerie… et aujourd’hui Internet.

Serge Soudoplatoff vient nous parler de ce phénomène qui a si vite envahi nos vies que l’on oublie de s’interroger : quelle est l'origine d'Internet ? Comment fonctionne-t-il ? Pourquoi bouleverse-t-il tant notre quotidien et quel futur nous construit-il ?"